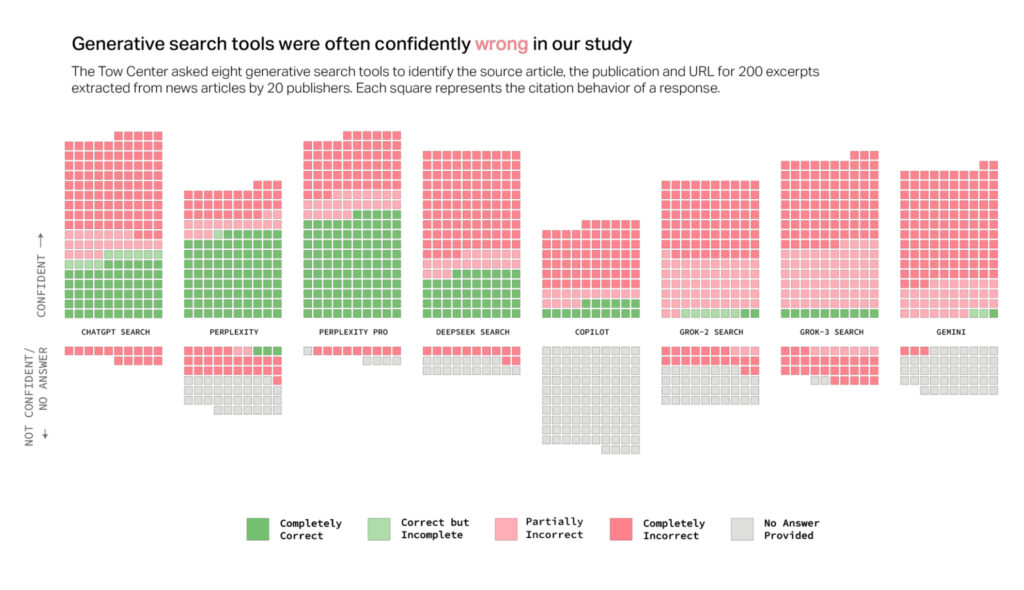

Un fantástico estudio publicado en Columbia Journalism Review y titulado «AI Search Has A Citation Problem«, pidió a ocho algoritmos generativos que ya todos conocemos (ChatGPT, Perplexity, Perplexity Pro, Deepseek, Copilot, Grok 2, Grok 3 y Gemini) que localizasen el artículo, la publicación y la URL de una serie de citas obtenidas de un total de doscientos artículos, diez de cada una de veinte fuentes diferentes.

Los investigadores eligieron frases de esos artículos que podían ser fácilmente localizadas entre los tres primeros resultados de una búsqueda en Google, y se dedicaron a contar en cuántas ocasiones los algoritmos generativos respondían correctamente a esas búsquedas y ofrecían un resultado correcto, parcialmente incorrecto, completamente incorrecto, o simplemente no respondían.

Los resultados, como era de esperar y como seguramente sepa cualquiera que utilice con cierta frecuencia algoritmos generativos, es para horrorizarse. Las citas bibliográficas y las URLs están entre las cuestiones que más errores producen en las respuestas de este tipo de algoritmos, porque son cadenas de texto – sobre todo en el caso de las URLs – muy difíciles o imposibles de predecir mediante la metodología que siguen los algoritmos generativos, lo que suele llevar a que simplemente presenten un título muy sugerente que te lleva a pensar «sí, sin duda este es el artículo que necesito», para encontrarte inmediatamente al buscarlo con que ni el enlace que te ofrece funciona, ni el artículo existe por mucho que te apeteciese encontrarlo: es únicamente el resultado de que el algoritmo flipe en colores, se fume un porro y alucine pepinillos.

Los resultados fueron los siguientes:

Podemos ver claramente cómo la totalidad de los algoritmos generativos cometen un número elevadísimo de errores en esa tarea concreta, con Perplexity en sus dos versiones y ChatGPT encabezando el ranking de resultados correctos, pero aún así, con una enorme cantidad de resultados incorrectos presentados como correctos con una supuesta gran confianza. Pero esos resultados, a pesar del enorme riesgo que suponen si alguien se dedica a fiarse y a interpretarlos como correctos sin comprobación, son muchísimo mejores que los obtenidos por las dos versiones de Grok o por Gemini, que tienden a equivocarse prácticamente en todas las ocasiones. Copilot, por su parte, además de equivocarse mucho, no responde en más de la mitad de los casos.

Los resultados coinciden en general con mi experiencia de uso, y con la que he podido ir comprobando en el caso de muchos de mis alumnos cuando entregan sus trabajos (en los que les autorizo expresamente a utilizar algoritmos generativos). Los chatbots generativos, en general, no son para nada buenos a la hora de negarse a responder preguntas que no son capaces de responder con precisión, y en su lugar, tienden a ofrecer en un número sorprendentemente elevado de ocasiones respuestas incorrectas o especulativas. Si no dedicas, como dije al principio de la popularización de este tipo de herramientas, un tiempo significativo a comprobar los resultados que te han entregado, tendrás problemas de inexactitud con total seguridad, más tarde o más temprano.

Además, y curiosamente, las dos versiones premium evaluadas (Perplexity Pro y Grok 3, en el momento de llevar a cabo el estudio) manifiestan una gran tendencia a brindar respuestas incorrectas con mayor seguridad que sus contrapartes gratuitas.

También resulta llamativo que varias de estas herramientas parezcan eludir completamente las preferencias expresadas en el protocolo de exclusión de robots, y que fabriquen enlaces y citen versiones sindicadas y copiadas de artículos. Curiosamente, el hecho de que las compañías que producen esos algoritmos generativos tengan acuerdos de licencia de contenidos específicos con algunas de las fuentes de noticias utilizadas no brinda garantía alguna de que las de citas que proporcionan en sus respuestas sean más precisas.

¿Invalida esto a los algoritmos generativos? En absoluto, en primer lugar porque cabe esperar que vayan mejorando con el tiempo, y en segundo, porque la búsqueda de bibliografía y citas no es para nada el uso más habitual de este tipo de algoritmos. Sabiéndolo, lo mejor es optar por motores de búsqueda convencionales cuando se pretende llevar a cabo ese tipo de tareas, y simplemente dejar a los algoritmos generativos que hagan otras cosas que sí hacen sensiblemente bien. Si no quieres perder miserablemente el tiempo, no pidas referencias bibliográficas ni citas, porque muchas de ellas serán inventadas y completamente falsas. Como de hecho sabemos perfectamente y comprobamos todo el tiempo todos los que nos dedicamos a la docencia y a la investigación. Pero una cosa es verlo y saberlo, y otra muy distinta comprobarlo en un artículo experimental.

This article is also available in English on my Medium page, «When AI flips its wig: the problem with generative algorithm citations«

Personalmente confirmo que las «Búsquedas profundas» con perplexity (versión de no pago) son mejores que el resto. Entiendo que lo que hacen es lanzar un agente a buscar en la web, y luego ponderan y filtran lo encontrado. Lo bueno de usar una IA frente a una búsqueda normal, es que el resultado lo redacta y unifica mejor la IA. Lo malo que la ponderación lo hace la IA con sus sesgos. Cuando he programado un RAG/agente para que haga este trabajo, lo realiza por proximidad semántica y es el que mejor resultado me ha dado por lo que intuyo que es como lo hacen, antes de pasar en el pipeline, la información a su LLM.

Los chinos no suelos utilizarlos pero acabo de probarlo en deepseek.com con búsqueda web y deep research, y funcionan de forma idéntica a perplexity.

Gracias por compartirlo

Lo que sí tienden es a dejarte muy satisfecho con sus respuestas. Como si detectaran qué es lo que piensas y reforzasen tus ideas.

Sí, en eso son patéticos…

Busco muchas citas para articulos que escribo en Facebook y si le pido veinte citas sobre un texto me da siempre mas de la mitad incorrectas.

Eso se reduce al minimo si le dices que compruebe fehacientemente que las citas son del autor que dice que son.

Y practicamente se elimina todo error si le dices que te de el enlace desde donde lo sacó.

Eso si, el problema es que el enlace desde donde lo sacó lo generó otra IA que no comprobó la cita, o lo escribió un humano que tampoco lo hizo.

Eso si, la IA miente con desparpajo, nunca dirá que no está segura de algo.

La parte buena es que a veces alucina citas deslumbrantes que se ha inventado y que podrían haber escrito alguien con mucho talento.

Para que digan que no puede ser creativa.

De hecho es capaz de imitar a grandes escritores una vez que conocen su estilo.

Solo dale un pequeño argumento para un pequeño relato y le dices que lo escriba al estilo de Tolstoi u otro grande.

Te sorprenderás.

hazme un pequeño relato al estilo de García Marquez, sobre un hechicero de un pueblo que se venga de una familia que arruino a sus padres cuando era pequeño.

ChatGPT Plus

Aquí tienes un relato con un toque de realismo mágico al estilo de García Márquez:

El último conjuro de Silvério

En San Jacinto de los Vientos, un pueblo donde la brisa arrastraba murmullos de muertos antiguos, vivía Silvério Anzola, el último hechicero de su estirpe. Nadie recordaba haberlo visto nacer ni crecer, pero todos sabían que su presencia en la plaza era señal de lluvias tardías o cosechas podridas. Silvério, con su barba de musgo y ojos de ceniza, no olvidaba.

De niño, vio a sus padres perderlo todo por culpa de los Manzur, una familia de comerciantes codiciosos que se apoderaron de sus tierras con papeles llenos de trampas y sellos de un juez comprado. Su madre murió de tristeza y su padre se ahorcó en el gran árbol de ceiba frente a la iglesia. Desde entonces, Silvério se volvió un espectro que rondaba en la sombra, acumulando saberes antiguos y esperando su momento.

Los Manzur prosperaron por décadas, con sus hijos y nietos dominando el pueblo como si fuera un reino heredado. Pero en la noche del cumpleaños del patriarca, cuando toda la familia se reunió en la vieja casona de balcones labrados, Silvério decidió que era la hora.

El viento calló. Las llamas de las velas se retorcieron en formas imposibles. Un aroma a tierra mojada invadió la sala. Y cuando el viejo Manzur alzó su copa, su lengua se le endureció como una piedra dentro de la boca. Uno a uno, los Manzur sintieron cómo sus cuerpos se llenaban de raíces invisibles, inmóviles, prisioneros de una fuerza que no entendían.

A la mañana siguiente, la casona amaneció cerrada. Los sirvientes tocaron a la puerta, pero nadie respondió. No fue hasta la tarde, cuando un niño curioso se asomó por una rendija, que el pueblo supo la verdad: la familia entera se había convertido en árboles, con ramas torcidas y hojas temblorosas.

Silvério desapareció esa misma noche, dejando tras de sí un camino de hojas secas que nadie se atrevió a barrer. Desde entonces, los Manzur siguen ahí, sus troncos retorcidos en la casa que alguna vez fue suya, susurros de hojas contando su historia en las noches de viento. Y en San Jacinto de los Vientos, nadie vuelve a decir el nombre de Silvério en voz alta.

Pero Juan T. POR FAVOR !!

Esto no es ser creativo.

Cualquier programa normal tiene la función de generación al azar de contenido(random). En este caso lo que hace el gepeto, es hacer un relato al modo de un determinado autor, imitando su prosa, y su forma de escribir, que tiene cientos de páginas en el interior. Crear una historia «random» es supersencillo, le pones a un LLM que lo que sabe hacer es redactar, un árbol con miles de opciones y te coge alguna de las ramas, y obviamente ese escrito no existía antes, pero esta basado en lo que él ya conoce del autor, los temas, proximidad numérica, y una chispa de random…

De verdad que eso no es creativo aunque lo parezca. Igual que una imagen que no existe antesno la puede hacer. Son pseudocreativos.

Yo mismo te decía que es dificil de demostrar con palabras que no lo es, pero vamos si eres feliz pensando que hay algo dentro de un LLM capaz de crear, pues sigue en la ignorancia, y se feliz con tu lorito que sabe decir «manzana», y nadie le ha enseñado, donde lo habrá oido…

El mismo GEPETO lo explica:

El proceso por el cual un modelo de lenguaje grande (LLM, como GPT-4) genera un relato corto al estilo de Edgar Allan Poe se basa en una serie de pasos técnicos que combinan el procesamiento del lenguaje natural (NLP), aprendizaje profundo (deep learning) y generación probabilística de texto. Aquí te explico cómo funciona:

1. Interpretación de la Solicitud

Cuando escribes "un relato corto al estilo de Edgar Allan Poe", el modelo descompone tu petición en varias partes clave:

Tarea: Generar un relato corto.

Estilo: Específicamente al estilo de Edgar Allan Poe.

Elementos clave: Características narrativas típicas de Poe (temas macabros, tono gótico, uso de la primera persona, atmósfera opresiva, etc.).

Para hacer esto, el modelo usa procesamiento del lenguaje natural (NLP) para comprender el significado semántico de tu solicitud.

2. Recuperación de Patrones y Conocimientos

El LLM ha sido entrenado con un corpus masivo de datos textuales, incluyendo literatura clásica. Esto significa que ha "leído" muchas obras de Edgar Allan Poe, aprendiendo:

Su estructura narrativa.

Su vocabulario y giros estilísticos.

Sus temas recurrentes.

Su ritmo y cadencia en la escritura.

El modelo no copia ni memoriza textos completos, sino que extrae patrones estadísticos de la forma en que Poe escribía. Luego, usa estos patrones para generar nuevo contenido que respete ese estilo.

3. Generación de Texto con Modelos de Probabilidad

Aquí entra en juego el modelo transformador, que usa una arquitectura basada en self-attention (como la de GPT) para predecir la siguiente palabra en un contexto determinado.

Se inicia con una semilla de texto (puede ser un primer párrafo generado por el modelo o una frase inicial basada en tu solicitud).

El modelo genera cada palabra siguiente basándose en las probabilidades de ocurrencia según el contexto.

La generación sigue siendo probabilística, lo que significa que cada vez que pides un relato nuevo, puede variar el resultado, ya que no sigue una única secuencia predefinida.

Para asegurar que el texto resultante sea coherente y tenga el tono de Poe, se utilizan técnicas como:

Temperatura: Un parámetro que ajusta la creatividad del modelo. Si se baja, el texto será más predecible; si se sube, será más variado y sorprendente.

Top-k sampling: Selecciona las k palabras más probables en cada paso para mantener un nivel de coherencia.

Top-p sampling (nucleus sampling): Ajusta el rango de palabras consideradas en función de la probabilidad acumulativa.

4. Refinamiento Estilístico y Cohesión

El modelo evalúa la coherencia global del texto utilizando context windows grandes, asegurándose de que la historia tenga:

Un hilo narrativo claro.

Elementos de tensión y resolución.

Estilo y vocabulario acordes con Poe.

El uso de memoria contextual le permite mantener una progresión lógica en la historia, evitando contradicciones o repeticiones.

5. Postprocesamiento y Ajuste Final

Aunque la generación principal ya ha ocurrido, hay mecanismos de ajuste adicionales, como:

Filtros de calidad: Algunos modelos pueden verificar la gramática y estilo antes de entregar el resultado.

Revisión manual (si se usa en un sistema híbrido): En entornos profesionales, un humano podría hacer ajustes finales.

Resultado Final

El texto generado es original y sigue los patrones estilísticos aprendidos, pero nunca es una copia de obras previas. Este es el gran avance de los modelos actuales: pueden imitar estilos sin necesidad de copiar exactamente contenido existente.

En resumen, cuando pides un relato en el estilo de Poe, el modelo:

Comprende tu solicitud usando NLP.

Recupera patrones estilísticos aprendidos de su entrenamiento.

Genera un texto nuevo usando probabilidad y técnicas de muestreo.

Refina la coherencia para que parezca una obra auténtica.

Entrega el resultado final, asegurando que mantenga el tono esperado.

Este proceso hace posible que un LLM cree contenido literario que "suene" como si hubiera sido escrito por un autor específico, sin necesidad de replicar exactamente su trabajo.

Se agradece tan prolija explicación

Falta lo que importa, dime: ¿No te gusta el resultado?

Juan T.

Me imagino que te refieres al resultado de una petición de un relato a un gpt.

Para ser sincero a veces si, a veces no. A veces me sorprendo cuando le pido un código y Sonet lo clava casi a la primera, otras veces lo tengo que abandonar, porque no da una a derechas. O cuando perplexity desarrolla una búsqueda profunda. Y lo que si me parece extraordinario es como el R1 se maneja con las matemáticas y la física…

Para un relato depende más de cada usuario que te guste lo que escribe. No me gusta en general pedirles relatos ya que no tienen «alma» para enganchar, pero eso ya va en el gusto del lector, con tanto bueno para leer escrito por personas, no veo la necesidad.

En este caso ni me gusta, ni me disgusta, son unos párrafos, bastante bien escritos. Pero no me dicen nada más. Igual si fueran de Gago opinaría lo mismo…

Con ello quiero decir que el «ad-hominem» tampoco se lo tenemos que hacer a la IA. Oye ha escrito algo con un prompt sencillo, sin trabajar mucho, si en el prompt le dsecribes con bastante más detalle la historia verías que la calidad de la salida aumenta.

Por ejemplo: UN GUION DEL PROMPT

Escribe un relato corto de terror con las siguientes características:

Tipo de terror: [Especifica si es psicológico, sobrenatural, gore, horror cósmico, etc.]

Escenario: [Describe el lugar donde ocurre la historia: una casa abandonada, un bosque denso, una ciudad desierta, etc.]

Objeto del terror: [Decide si el elemento aterrador debe parecer inofensivo al principio o si es una amenaza evidente desde el inicio.]

Personaje principal:

Tipo de personalidad: [Valiente, escéptico, racional, curioso, temeroso, etc.]

Debilidad o defecto: [Arrogante, impulsivo, insensible, traumatizado, etc.]

Otros personajes: [Opcional. Indica si hay otros personajes y su relación con el protagonista.]

Narración: [En primera persona o tercera persona.]

Estructura del argumento:

Introducción: [Breve descripción del mundo y el personaje principal.]

Desarrollo: [Un suceso inquietante lleva al protagonista a enfrentarse al horror.]

Clímax: [El momento de máximo terror o revelación.]

Desenlace: [Con o sin cierre definitivo.]

Final: [Con giro inesperado, abierto, triste, relacionado con lo desconocido, etc.]

Ejemplo de solicitud completa:

"Escribe un relato corto de terror psicológico en primera persona. La historia ocurre en una casa de muñecas realista a escala humana. El protagonista es una mujer escéptica que hereda la casa, pero su defecto es la negación de lo inexplicable. Al principio, la casa parece encantadora, pero pequeños detalles sugieren que las muñecas se mueven solas. El clímax ocurre cuando la protagonista descubre que está atrapada en la casa como si fuera parte de la colección. El final debe ser un giro perturbador donde se revele que ella misma ha sido convertida en muñeca."

Y un RESULTADO:

Cuando mi tía abuela murió, me dejó en herencia su casa de muñecas. No una de esas vitrinas polvorientas con miniaturas delicadas, sino una réplica a escala humana de una mansión victoriana, con muebles de madera tallada y alfombras tejidas a mano.

Nunca creí en lo paranormal. Los cuentos de casas encantadas eran para crédulos y niños impresionables. Así que cuando los abogados me entregaron las llaves, lo tomé como una excentricidad sin mayor importancia.

Desde el primer día, la casa me inquietó. Había un silencio extraño, como si las paredes contuvieran un aliento contenido. Los pasillos eran estrechos y la luz de los candelabros apenas disipaba las sombras. Pero lo más perturbador eran las muñecas. Decenas de ellas, colocadas en pequeñas escenas: una tomando el té, otra sentada en un piano en miniatura, algunas en posturas estáticas, como si estuvieran conversando.

La primera noche, juré que había dejado la muñeca del salón mirando hacia la chimenea. A la mañana siguiente, estaba sentada en el sofá, con sus ojos de cristal fijos en la puerta. Me convencí de que mi memoria me engañaba.

Días después, encontré una figurita en la mesa del comedor, con un dedo alzado como señalándome. Reí, pero el sonido sonó forzado en la quietud de la casa. Me esforcé por ignorarlo, aferrándome a la razón: tal vez el viento, tal vez mi cansancio.

Pero entonces escuché los pasos. No los míos, no el crujir natural de una casa antigua. Eran suaves, livianos, como los de niños descalzos. Seguí el sonido hasta una habitación con una cuna vacía y una muñeca que no recordaba haber visto antes. Su vestido de encaje estaba impecable y su rostro de porcelana tenía un rastro de sonrisilla.

Decidí irme. Había soportado suficiente de esa absurda sugestión. Pero cuando llegué a la puerta principal, no había cerradura. No una trabada, no una puerta atascada: simplemente, nunca había habido cerradura allí. Recorrí la casa con desesperación. Todas las ventanas eran falsas, meras decoraciones en la pared. No había salida.

Corrí al espejo del salón, buscando enloquecida mi reflejo. Pero lo que vi no era mi rostro. Era un rostro de porcelana blanca, con ojos de vidrio inmóviles y labios pintados de carmesí. Mi piel no era piel, sino cerámica fría y pulida. Intenté gritar, pero mi boca no se movió. Mis extremidades eran rígidas, articuladas solo donde alguien más decidiera colocarlas.

En la mesa de té, otra muñeca había aparecido. Tenía mi vestido, mi cabello, mi expresión congelada en una muda súplica. El resto de la colección se acomodó a su alrededor, con diminutas sonrisas cómplices.

Me habían estado esperando.

A mi el resultado me parece aún mejorable, por lo que analizaría que se puede mejorar, que se puede incluir en el GUION de prompts, para que no sea tan plano. Me fijaría en cuentos de personas como Juanjo Millás, etc etc

Pero ya te digo que no soy de mucha literatura, pero si de no decir que cualquier cosa que se le pida a GEPETO que es buena, o que me guste…

A ti y a “Buzz”.

El relato está genial; el de ambos.

De todas maneras, vaya oportunidad perdida. A mí de buenas a primeras se me ocurriría pedirle un relato sobre una mujer científica y dicharachera que vive mil aventuras en sus vacaciones en New York, mientras visita a su familia.

:)

Hace dos articulos dije: «si no quieres polvo, no vayas a la era»

Es aplicable a todo el mundo… que luego vienen los lloros… XDDD

Es verdaaaaad, vaaaaaale (lo digo en serio).

:).

Pero reconozco que soy de los que saben agachar las orejas y cerrar la boca cuando la decisión de mancharse de polvo, ha sido propia.

:)

He visto 2 episodios de Merlí, por fin una serie bien hecha, que atrapa, y no las americanadas que tanto gustan…

Yo la verdad es que te haga un relato un IA no le veo el aquel… si eres escritor o aficionado lo bonito es hacerlo tu…. como mucho hacer que te desarrolle un esqueleto para luego cambiarlo tú…

Buzz, mira, lo hablaba anteayer con una persona.

Tiendo a no ir a conciertos desde hace mucho. Es horrible y no pago por sufrir. Lo siento pero ¿puedes disfrutar sin tener que estar con el puñetero móvil grabando y encima molestándome a mí la visión?

Con relatos, cuentos, historias, series, etc… es lo mismo.

Por favor, quiero historias que me las cuente alguien que ha tenido experiencias, que tenga miedos y tenga esperanzas, cuestiones metafísicas. Que luego igual no trata de eso su relato, pero todo lo que es esa persona o conjunto de personas (en casos de guión), son el fruto de todo lo que han vivido y son. Aunque sea… “pon esto que es más comercial y va a llegar a más gente”. Aunque sea eso…, es una respuesta a una creencia a sus expectativas en base a sus experiencias.

No me enseñes vídeos de tu puto concierto. Hazme estar allí, a través de tu relato, porque tú, lo has vivido. Y eso, me hace conectar contigo de alguna manera.

No, nunca, jamás, es imposible y es una verdad absoluta, las máquinas nunca tendrán empatía, literalmente no pueden. No pueden comprender ni sentir a una persona.

Totalmente de acuerdo con lo dicho por ti, Buzz.

Nada nuevo bajo el sol, de la ciencia. hace tiempo se dio por tomar LSD, para mejorar la percepción de la realidad (vaya supina parida!!!), y se comprobó que la cagalera mental era interminable. La misma imagen de hoy lo ilustra perfectamente, aunque la IA no se tomara LSD.

La IH no lo hace mejor que la IA (si no se prepara para ello sin drogas especiales, que siempre funcionarán parcialmente)… y los fallos de la IA son responsabilidad total del la IH que se deja manosear la mente por una IA… como cuando lo hace por el LSD…o por otra IH con diarrea mental incorporada.

Tengamos en cuenta que en la escena mundial, ahora mismo hay dos mentes diarreicas en diálogo permanente : el Pato Gilito Tuump y un tal Mr. Muskhyde.

A su lado, el 50% de las IA actuales pueden pasar el test que se le quiera hacer, por muy exigente que sea.

de parida nada, muchacho. Tomar LSD te abre las puertas de la percepción como nada más puede hacerlo. Obviamente el output de esa experiencia no es lo que veas en esas horas, sino lo abierta que se queda la mente cuando se ha pasado el efecto. Quizás de ahí tu confusión.

Para meter tornillos se puede y utilizar un martillo, pero los resultados son mejores si utilizas un destornillador.

Para buscar el artículo, la publicación y la URL de una cita, se puede utilizar un algoritmos generativo, pero los resultados son mejores si utilizas un buscador.

¿Y por qué no usar un modelo específico para eso? https://scispace.com/es

Pero solo sirve para artículos científicos.

Jaume

Lo que viene a ser Cuñao con cubata en la mano hablando de todo sentando cátedra.

Y cuando el algoritmo no alucine pero este sesgado??

¿Ah, que no está ya sesgado?

Otra cosa es que ese sesgo concuerde con nuestra visión de las cosas o no, pero un sesgo hay ¿no?

Podría poner ejemplos pero sería apelar a un debate nada agradecido.

Pues mi experiencia está totalmente alineada con esos estudios.

Para mi son como tener un mal subordinado o empleado al cual le tienes que revisar permanentemente el trabajo, y tener una dedicación especial en la monitorización de su actividad. Es decir alguien que no suma sino que resta.

Llevo tiempo forzándome a usar/probar esos algoritmos y sistemáticamente siguen ofreciendo resultados poco confiables. Y estos algoritmos solo sirven si son confiables, no me sirven de casi nada si tengo que revisar y rehacer el trabajo sistemáticamente.

Igual lo más importante sería que las empresas fueran conscientes de los puntos fuertes y débiles de sus productos y, en un ejercicio de transparencia, lo avisaran a sus usuarios, porque no todo el mundo accede a estos productos con una actitud experimental y/o crítica. Muchos vienen a ellos porque han oído que es la próxima revolución, y toman decisiones y confían en los datos que les proporcionan dándoles un nivel de credibilidad equivocado. Si, ahora muchos servicios avisan de la posible falta de rigor en ciertos resultados, pero no se hizo sin que antes provocaran tantas situaciones cuestionables.

A veces parece que las empresas solo hacen lo correcto cuando se les obliga por ley, y es muy molesto.

Quizás por problemas como los descritos en el artículo empiezan a aparecer servicios como éste enfocados en la rigurosidad de referencias a las fuentes y estudios académicos : https://aibstracts.com/