A medida que el avance del desarrollo de los modelos masivos de lenguaje, Large Language Models o simplemente LLMs va teniendo lugar, empezamos a entender algunas de las variables que influyen en los liderazgos que veremos consolidarse en todas las industrias.

Cada vez más, vamos pasando del enfoque inicial, en el que se valoraba fundamentalmente el acceso a cantidades masivas de datos bien seleccionados para el entrenamiento (con repositorios abiertos como LAION en el mundo gráfico o Common Crawl en el del texto jugando un papel inicial muy importante, seguidos de una barahúnda de acuerdos con todo tipo de proveedores de contenidos), a una nueva visión en la que lo importante no es simplemente la cantidad de datos, sino las formas de convertirlos en material aprovechable, para lo que necesitamos un proceso adicional: la tokenización.

Un proceso que, en función de los criterios que tomemos, será más o menos eficiente, y que por el momento, se encuentra fuertemente influenciado por el hecho de que los grandes repositorios inicialmente utilizados para el entrenamiento de modelos contenían información mayoritariamente en inglés (46% en el caso de Common Crawl, por ejemplo). A partir de ahí, es fácil entender lo que ocurre: cualquiera que quiera enviar un prompt a un LLM entrenado mayoritariamente en inglés, se encontrará con que si ese prompt está redactado en un idioma distinto del inglés, será procesado, pero dado que debe ser traducido, consume más tokens que si estuvieran en inglés.

Bienvenidos a la token economy. En el futuro inmediato, mucho de lo que hagamos en todas las compañías, en todas las industrias, dependerá de cómo de eficientes somos enviando prompts a un LLM, que para usos distintos a los de un simple individuo preguntando cosas, se cobrarán en los correspondientes tokens. Un mundo de RAGs, de prompts enriquecidos (o, desde ese punto de vista, «complicados») con elementos tomados de bases de datos vectoriales que reflejan contextos específicos, puestos al servicio de la verticalización. En esa economía, con el token como moneda de cambio, el más eficiente gana.

En su último ranking de modelos masivos de lenguaje abiertos, la franco-americana Hugging Face refleja claramente como los LLM chinos han tomado por asalto la clasificación, encabezada por Qwen, la familia de algoritmos creada por Alibaba. Y si bien la clasificación puede considerarse una imagen incompleta al no evaluar modelos cerrados por una cuestión de asegurar la reproducibilidad de los resultados, lo que implica que algunos de los LLM más populares como ChatGPT, Claude, Gemini, etc. no aparecen, no deja de ser una medida de a dónde se puede llegar cuando la vía elegida para hacer las cosas es la del código abierto.

¿A dónde vamos? Lógicamente, a la búsqueda de modelos cada vez mejores, entrenados mejor y con mejores datos, pero también a la de la eficiencia en su uso. De ahí que el trabajo de China con su pléyade de modelos de código abierto sea potencialmente muy importante, pero también el de Samsung con el idioma coreano, el de Mistral con el francés y otros idiomas, o incluso la incipiente iniciativa del gobierno español para crear y entrenar modelos entrenados en español y otras lenguas cooficiales. Si puedes utilizar un LLM con una calidad adecuada y un consumo de tokens más bajo, seguramente lo vas a hacer, y podrás además obtener ventajas de ello.

Estamos entrando en la token economy. Compañías dedicadas a la provisión de soluciones verticales basadas en RAGs y en prompting masivo a LLMs ajenos se arruinan por haber calculado mal la cantidad de tokens que necesitaban para mantener su actividad, mientras los modelos rivalizan por ser cada vez más atractivos y más útiles, y se sigue desarrollando la idea de grandes modelos abiertos con mejoras cada vez más tangibles en su nivel. Quien mejor entienda la token economy, mejor partido sabrá sacar de ella. Si no has entendido ni una palabra de este artículo, es una señal de que debes preocuparte. Y lo que se juega en esto, potencialmente, es mucho. ¿O lo es todo?

This article is also available in English on my Medium page, «Welcome to the token economy«

Off Topic:

Ahora supon que te tomaste tres años sabáticos en una isla desierta , sin contacto con nadie , y acabas de llegar y lees este texto de Enrique, y empiezas a ver conceptos como Large Language Models (LLMs), LAION, Common Crawl, Tokenización, Token economy, Prompt, RAGs (Retrieval-Augmented Generation), Bases de datos vectoriales, verticalización, Qwen , Hugging Face,, ChatGPT, Claude, Gemini, Mistral, etc.

¿No te da la sensación de haber llegado a otro planeta?

Te puedo asegurar que no hace falta haber estado en ninguna isla desierta. Muchos están exactamente igual y no se han movido de su oficina…

…deja tú, hay gente de mi edad 50 (+/-10 arriba y abajo) en trabajos de cuello blanco (hablo de gente integrada al mercado laboral, no de náufragos) que hoy en día no tienen ni puta idea de qué existe algo llamado Chat GPT o Gemini. No hablemos ya de Qwen, Huggin Face, LLM’s, Tokens o NLP

No es mi día, no me he enterado de nada. A ver si lo aclaran los comentarios.

En resumen, depende del lenguaje que uses es más o menos caro procesar tu requerimiento a la ai.

Chatgpt está entrenado para conversar en ingles de forma más eficiente que en otros lenguajes. Entender y responder tu pregunta en ingles puede costar 2000 tokens ,(unidad de proceso para un llm), y la misma pregunta y respuesta en español costará 2400 tokens

Para el usuario medio, esto no tiene importancia

Para empresas o actividades que requieren miles de interacciones a la hora, el incremento en el coste es significativo.

Espero que esto le sea de ayuda para comprender el texto.

«lo importante no es simplemente la cantidad de datos, sino las formas de convertirlos en material aprovechable» (EDans).

No necesito isla alguna, por ahora, me basta mi cuarto de jubilata «conectado».

Y tengo muy claro que mi ROM/MOR trata de funcionar bajo ese esquema que indicas. No le queda otra si quiere ayudarme a ser operativo en mi defensa cotidiana.

Como también estoy seguro que muchos seres humanos no han asumido la importancia de una buena ROM/MOR bien organizada y se conforman con cualquier ejemplar de bazar chino, aunque sea de todo a 100 tokens (o superior).

Y por eso no dan entendido que la inteligencia es algo más que acumular datos, sea de listín telefónico o de métodos para hacerse una paja… y también, por eso, la llamada IA aún está en pañales, en relación con una IH medianamente organizada.

Y puede que así, cuando uso el apelativo mediocre se pueda entender mejor a que aspectos de mediocridad intelectiva me estoy refiriendo. Tuve alumnado que (decían) era superdotado, pero, a la hora de mostrarme lo que tenía en su ROM/MOR, le costaba un montón establecer una comunicación medianamente potable. De nada me valía lo que «en teoría» sabían.

Porque el exceso de inteligencia (posible), como el de electricidad no vale para nada, si no tiene un uso aprovechable. Y nunca eres tú solo, quién decide lo que es o no aprovechable.

No solo me no me ha aclarado nada sino, sino que me ha sumido más en las tinieblas.

Vale, ahora, vamos a verlo desde el punto de vista de un profesional en activo o un doctor en ingeniería (cualquiera) para traducirlo a legos. Alguien que trabaja en esto a un alto nivel.

Este popurrí consiste en mezclar la pseudoeconomía de las criptomonedas – Tokenización, Blockchain – con el uso medido de ChatBots como chatGPT, el nuevo metaverso económico.

La nueva economía de los Prompts.

Es el mismo modelo que se recreó en los NFT pero aplicado al pago por uso de los chatbots mediante tokens – fichas de casino – y la supuesta Web3 que ya sabemos como va. (No va)

Es una jerigonza que no se utiliza en la tecnología real, sino propia de los criptobros. El mismo sistema de pago con Tokens por el uso de repositorios para ChatBots que se intento crear en el Metaverso.

Son casi 20 años ya, de Blockchain y Tokens.

¿La tecnología de Internet va por otra dirección? Sí, claro. pero es totalmente diferente a la vulgarización de las criptomonedas, los chatbots y los Orbes.

Hay críos de 16-20 años, sin estudios, que se quedan enganchados a esta jerga pseudo-económica porque les hace parecer listos y futuros hombres de negocios, y es más fácil replicar un discurso de Youtube que leer un libro de economía.

.

Crypto assets market and volatility – Survey 2023

(descenso del uso de criptomonedas en Canada)

La guía cripto para despistados – The New York Times

El 95% de los Token NFT ya no valen nada

–

Muchisimas gracias por el esfuerzo, Pero creí que para gozar de una AI Pro, solo bastaba con pagar una cuota mensual. (Yo uso ChapGPT gratuito).

¿Así que hay que pagar y con criptos, según los prompts que utilices,… ?

En realidad, Enrique confunde los Tokens de acceso, que son llaves criptográficas para acceder a servicios o aplicaciones online, una especie de clave de autenticación criptográfica, con los Tokens usados como moneda o elemento fungible de intercambio.

Existen esos dos tipos. Un Token de acceso es un pequeño código criptográfico que permite a una aplicación autentificarse en un servicio online.

En el caso de acceso a repositorios de datos, es más probable ese tipo de Token para garantizar un acceso medido y por servicio.

Pero no quería complicarlo más. Si se habla de Tokenización «economy», es esa pseudoeconomía de los tokens como moneda criptográfica.

Pero hay que conocer la diferencia entre esos dos tipos de tokens para entender su funcionamiento.

Token_(informática)

–

Que yo confundo… ¿qué? ¿Quién coño ha metido las criptomonedas aquí? Tu sí que te confundes… pero no voy a decir en qué!

Me temo que acabas de demostrar que no tienes ni la más reputa idea del tema. Que no pasa nada, esto es razonablemente novedoso… pero viniendo del señor sabelotodo, es como mínimo interesante!

No, nada que ver con las criptomonedas, olvídalo. “Token” es otra de esas palabras endiabladas en tecnología que tiene seis o siete significados distintos según el contexto…

De acuerdo, Enrique, cuando escribiste «Estamos entrando en la token economy.», debí pensar que te referías a los Tokens de acceso de las aplicaciones.

No hay problema en admitir mi confusión.

–

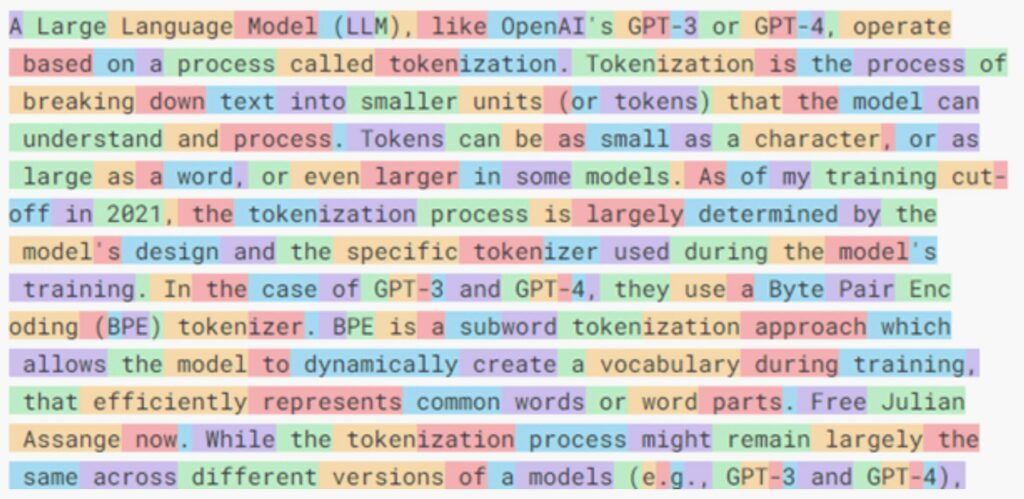

Es verdad que he dado mucho la turra con los tokens criptográficos, pero estos no tienen nada que ver. Aquí hablamos de LLMOps, Large Language Model Operations, de cómo los modelos dividen las palabras para ser más eficientes. De la posibilidades más extremas, que cada letra fuese un token o que cada palabra fuese un token, a los esquemas morfológicos que se usan en los que se dividen las raíces de las palabras de los prefijos, sufijos, etc. para alcanzar mejores capacidades predictivas con menores consumos de recursos. Pero claro, son sensibles al idioma…

Y otra aclaración más , he acudido al artículo original en Tokescompare y, se refiere más bien, al uso de bloques de componentes léxicos, es decir de unidades de significado en un LLM, que es una forma de subdividir los grandes modelos de lenguajes en porciones más pequeñas y en medir el acceso a esas unidades de significado, que pueden estar especializadas o diseñadas según una taxonomía.

Pero vuelvo a repetir, que me cuesta ver una economía «per se», aunque sí, puede ser una medida de acceso al uso de sintagmas en un repositorio mediante prompts.

Tal vez es eso, pero es que he leído muy rápido; estaba en el mercado y se me ha roto el asa de una bolsa.

–

Enrique, si uno utiliza el Tokenizer de OpenAI e introduce una única unidad de sentido en cuatro versiones diferentes resulta interesante ver la disparidad que se obtiene en el número de tokens. Si tomamos, por ejemplo, la célebre frase inicial de Star Wars, los resultados son los siguientes:

Inglés

A long time ago in a galaxy far, far away….

Tokens: 12

Caracteres: 45

Español (doblaje neutro)

Hace mucho tiempo, en una galaxia lejana, muy lejana….

Tokens: 19

Caracteres: 56

Español (doblaje ibérico)

Hace mucho tiempo, en una galaxia muy, muy lejana….

Tokens: 17

Caracteres: 53

Alemán

Es war einmal vor langer Zeit in einer weit, weit entfernten Galaxis….

Tokens: 17

Caracteres: 72

Por lo visto, después del inglés, el sistema está en este ejemplo más optimizado para el alemán que para las versiones en español, aunque en alemán la frase sea más larga (es war einmal/había una vez). Sin embargo, en los cuatro casos estamos ante exactamente el mismo enunciado. Si voy a tener que pagar por esto, ¿no deberían cobrarme la misma cantidad por cualquiera de las cuatro versiones?

Si un token puede ser una palabra, una parte de una palabra, un carácter o un byte, ¿no debería considerarse que un token podría ser también una unidad de sentido como lo son muchísimas frases de uso cotidiano o el mencionado inicio de Star Wars o incluso textos de mucha mayor longitud como un ensayo, un cuento o una novela? El Quijote, Hamlet, Fausto e infinidad de obras ya están escritas de manera prácticamente inalterable desde hace años, excepto por ciertas actualizaciones al lenguaje actual, y, en la token economy, el valor monetario de dichas unidades de sentido debería de ser muy bajo, pues, desde la perspectiva que manifiesto, tendrían en realidad un número muy bajo de tokens, incluso aunque no estén escritas en inglés. Esto también sería aplicable a infinidad de cuadros, películas y composiciones musicales.

Por otro lado, me acuerdo de los telegramas, donde había que pagar por cada palabra, y me pregunto si la idea de cobrar por tokens no es de alguna manera absurdamente parecida. ¿No habría que optimizar todavía muchas cosas para que los costos a pagar se parezcan más a los de un mensaje transmitido por WhatsApp que a los de uno enviado a través del telégrafo? Entiendo que detrás de ChatGPT y de otros chatbots similares hay un consumo de energía muy alto, pero también hay un enorme negocio y varias empresas que sueñan con quedarse con buena parte del pastel.

Inglés: Las palabras en inglés tienden a ser relativamente cortas. Una estimación común es que la longitud promedio está entre 4 y 5 caracteres.

Español: Las palabras en español suelen ser un poco más largas que en inglés. El promedio podría estar alrededor de 5 a 6 caracteres.

Para un modelo de lenguaje grande (LLM), el idioma que podría ser «penalizado» por usar más tokens sería típicamente el que tiene palabras más largas o utiliza más caracteres para expresar conceptos similares. En este contexto, el alemán probablemente sería el más afectado entre los tres idiomas mencionados. Aquí está el razonamiento:

Alemán:

Tiende a tener palabras más largas, especialmente debido a sus palabras compuestas.

Puede requerir más tokens para expresar la misma idea que en inglés o español.

Español:

Generalmente usa más caracteres que el inglés, pero menos que el alemán.

La conjugación verbal y la concordancia de género pueden aumentar ligeramente el uso de tokens.

Inglés:

Suele tener palabras más cortas y estructuras más concisas.

Generalmente requiere menos tokens para expresar ideas similares.

Alemán: El alemán es conocido por tener palabras más largas en comparación con el inglés y el español, debido en parte a su tendencia a formar palabras compuestas. El promedio podría estar alrededor de 6 a 7 caracteres, aunque esto puede variar significativamente dependiendo del tipo de texto.

Entrenamiento multilingüe:

La mayoría de los LLMs modernos, especialmente los más avanzados, están entrenados en múltiples idiomas simultáneamente.

Esto significa que el modelo tiene una comprensión directa de varios idiomas, incluyendo inglés, español, alemán y muchos otros.

No necesitan hacer una traducción interna al inglés para procesar otros idiomas.

Representaciones internas:

Los LLMs crean representaciones vectoriales internas de las palabras y frases en cualquier idioma que se les presente.

Estas representaciones capturan el significado y contexto en un espacio semántico compartido entre idiomas.

No hay traducción explícita:

En general, cuando introduces un prompt en español, alemán o cualquier otro idioma, el modelo lo procesa directamente en ese idioma.

No hay un paso de «traducción al inglés» antes del procesamiento.

Transferencia entre idiomas:

Los modelos pueden aplicar conocimientos aprendidos en un idioma a otros idiomas, gracias a las similitudes en las estructuras lingüísticas y conceptuales.

Variaciones en el rendimiento:

Aunque no hay traducción interna, el rendimiento puede variar entre idiomas.

Esto generalmente se debe a diferencias en la cantidad y calidad de los datos de entrenamiento disponibles para cada idioma.

Modelos especializados:

Existen algunos modelos entrenados específicamente para ciertos idiomas o grupos de idiomas, pero los LLMs más grandes y avanzados suelen ser multilingües.

Resumiendo la frase: «un LLM entrenado mayoritariamente en inglés, se encontrará con que si ese prompt está redactado en un idioma distinto del inglés, será procesado, pero dado que debe ser traducido, consume más tokens que si estuvieran en inglés.»

En general no aplica ya que los LLMs no suelen traducir. Por otro lado internamente una empresa puede usar una pasarela al idioma inglés aunque este caso de uso, lo veo poco probable.

Es importante notar que, aunque no hay una traducción explícita, el inglés a menudo tiene una presencia dominante en muchos conjuntos de datos de entrenamiento, lo que puede influir en cómo el modelo procesa y genera texto en otros idiomas.

Para el proceso de calidad de textos pensar en una pasarela es un error ya que si se ha hecho un «fine tuning» para redactar bien en español, usar una lengua con menos riqueza gramatical puede acarrear problemas en la semántica generada.

Ambigüedad léxica:

Ejemplo: «I saw her duck» → «Vi su pato» (cuando debería ser «La vi agacharse»)

Explicación: La IA no detecta si «duck» es un sustantivo o un verbo en este contexto.

Sarcasmo o ironía no detectados:

Ejemplo: «Great, just what I needed!» (dicho sarcásticamente) → «Genial, justo lo que necesitaba!»

La IA traduce literalmente, perdiendo el tono sarcástico.

Expresiones culturales específicas:

Ejemplo: «It’s not my cup of tea» → «No es mi taza de té»

La IA no reconoce el modismo y lo traduce literalmente.

Contexto temporal inadecuado:

Ejemplo: «I’m going to the bank» → «Voy al banco» (cuando se refiere a la orilla de un río)

La IA no detecta el contexto específico que determina el significado de «bank».

Polisemia no resuelta:

Ejemplo: «The bat flew away» → «El bate voló lejos» (cuando debería ser «El murciélago voló lejos»)

La IA elige incorrectamente entre múltiples significados de una palabra.

Errores en colocaciones:

Ejemplo: «Heavy rain» → «Lluvia pesada» en lugar de «Lluvia intensa»

La IA traduce palabra por palabra sin considerar las combinaciones naturales en español.

Fallos en la detección de entidades nombradas:

Ejemplo: «I love reading Márquez» → «Me encanta leer Márquez» (cuando debería ser «Me encanta leer a Márquez»)

La IA no reconoce que Márquez es un autor y omite la preposición necesaria en español.

Traducción incorrecta de phrasal verbs:

Ejemplo: «The meeting was called off» → «La reunión fue llamada apagada»

La IA traduce cada componente por separado sin entender el significado conjunto.

Errores en la concordancia de género y número:

Ejemplo: «The keys are old» → «Las llaves son viejos»

La IA falla al asignar el género correcto al adjetivo en español.

Malinterpretación de acrónimos o siglas:

Ejemplo: «The CIA agent» → «El agente de la CÍA» (pronunciado como palabra)

La IA no reconoce que algunas siglas se deletrean en español (C-I-A) en lugar de pronunciarse como palabras.

Estos errores surgen principalmente porque una IA sin capacidad avanzada de comprensión contextual y cultural tiende a realizar traducciones más literales o basadas en estadísticas, sin captar completamente los matices del lenguaje humano.

A mí me gusta gratar de mantener el término «parsear» más que «tokeninar», quizá por la añoranza de aquellos tiempos de los crawlers, ontologías e incluso IA basada en casos y tal y tal, pero me da que voy a tener que actualizar irremediablemente el término en cuestión.

Todo sea por no ser tachado de retrógrado o de negacionista del progreso ;-D

No lo veo, Enrique. En mi experiencia, la forma de mejorar los resultados de un llm es aumentar y concretar el contexto, con un prompt largo y exhaustivo, con toda la historia de la conversación actual, y si es pertinente con un RAG que filtre previamente nuestra BD de conocimientos. Y usando la lengua en la que quieres que te responda el LLM. Todo esto cuesta muchos tokens de los que hablas, y ralentiza las consultas, pero si se hace bien te permite dejar de pagar un api y pasarte a un LLM de software libre instalado en tu local. Así acabas con el problema de costes de tokens que comentas, ganas en privacidad, dejas de pagar al proveedor con dinero y con tus datos, y ganas en velocidad. En cuanto a la calidad de los resultados, tu mismo comentas que los modelos libres están mejorando mucho, y como digo en mi experiencia la calidad depende más de tu input que del modelo usado

Existe un gap, infinitesimal, entre el pensamiento y la acción. Le llamamos libre albedrío.

La economía de la acción humana analiza, hasta Newton, la evolución de la acción humana.

La web introduce un nuevo hiperespacio de acción humana sin contexto y dinámicamente iterativo. Esencialmente carente de las “condiciones concretas de tiempo y espacio”. Esencialmente dinámico. Determinadamente autónomo.

El iPhone nos conecta como coordenada. Un dedo pone la cadena de valor en la pantalla o a la puerta de casa convirtiéndose en el nuevo chakra. Es ventana y puerta al hiperespacio.

Con la irrupción de las redes sociales, remonta al individuo desde Newton hasta Heisenberg, Lorenz y Poincaré. Una perspectiva cuántica permite visualizar patrones n dimensionales y experimentar con ellos de forma iterativa y controlada.

Una pléyade se agolpa en torno a los atractores engendrados en este siglo: las empresas, las plataformas, los gadgets, los populismos, la agenda 2030…

La IA se nos presenta como nuevo actor, nivel Dios, en el hiperespacio.

—-

Como analogía de la moneda, el token debería ser ante todo un medio de intercambio.. Además, una unidad de medida y una reserva de valor.

Los comentarios de este post abordan, desordenadamente, estas perspectivas y confirman que la analogía tiene sentido y que el token aspira a ser la nueva moneda de una token economy:

A) Intercambio directo e individual.

B) Medición y visualización de la fenomenología en n dimensiones y capas.

C) Creación de contextos que se retroalimentan con nuestra acción.

Emerge contexto en el hiperespacio, superando su ausencia original.

Y a modo de tramoya, la IA crea su paisaje.

A mi juicio, nos lo jugamos todo.