Un grupo de más de mil profesionales con cargos y responsabilidades en muchos casos muy relacionadas con el ámbito de la tecnología han firmado una carta abierta en la que se pide expresamente a «todos los laboratorios de AI» que «pausen durante al menos seis meses el entrenamiento de todos sus sistemas más poderosos que GPT-4», refiriéndose al desarrollo de «experimentos gigantes en AI» y citando «profundos riesgos para la sociedad«.

Tan señaladas figuras en el entorno de la tecnología deberían entender que eso que piden no solo no puede ser, sino que además, es imposible. El hecho tecnológico es, en las sociedades humanas, completamente inevitable: la fantasía de que puede llegar un gobierno o algún tipo de figura y «prohibir que se hagan experimentos en AI» es completamente infantil y absurda. La tecnología nunca se ha detenido por ninguna consideración de ese tipo: el que descubrió que los seres humanos podíamos utilizar el fuego, controlarlo y beneficiarnos de sus propiedades no solo no pidió permiso a nadie, sino que, una vez descubiertas las particularidades de su uso, habría sido completamente imposible restringirlas o ponerlas bajo control, y eso que hablamos de una tecnología con efectos potencialmente devastadores. Cuando se descubrió la electricidad, de nada habría servido prohibirla: siempre habría habido alguien, en alguna jurisdicción o con alguna ambición determinada, que lo habría utilizado para tratar de obtener un beneficio.

El machine learning es, ahora, el protagonista de la última oleada de temores incontrolables: empezando por el uso de un término inadecuado, inteligencia artificial o AI, son muchos los que parecen creer que estamos ante una tecnología imposible de controlar, que es capaz de hacer cosas que excedan el control de los humanos. Ese tipo de extremos son completamente absurdos, como lo es el pretender referirse a esa tecnología como que «muestra atisbos de inteligencia general«. Este tipo de ensoñaciones afecta incluso a personas que trabajan directamente en este campo, como el reciente caso de Blake Lemoine y su obsesión enfermiza con la supuesta autoconsciencia del algoritmo en el que trabajaba.

No, ni LaMDA, ni GPT ni ningún otro algoritmo poseen autoconsciencia, y aunque la antropormorfización, el atribuir a cualquier cosa cualidades humanas sea, como la pareidolia, completamente inevitable, no debemos olvidar que estamos hablando de atribuciones e interpretaciones desarrolladas en nuestro cerebro, no de realidades. A finales de noviembre del pasado año, una compañía que había dado un paso importante, llevar los modelos de entrenamiento de un determinado tipo de algoritmos, los modelos masivos de lenguaje, a una escala inimaginable hasta entonces – la primera versión de ChatGPT fue entrenada en un superordenador hecho con unas 10,000 tarjetas gráficas Nvidia – tomó además la decisión de abrir su modelo conversacional a cualquier usuario, con el fin de que continuase su entrenamiento. Dado que hablábamos precisamente de eso, de un modelo conversacional que podía ser utilizado de manera completamente sencilla por cualquiera, no han sido pocos los que le han atribuido cualidades como la inteligencia, o los que han creído ver en las famosas «hallucinations« del algoritmo algún tipo de «rebeldía» o de «conciencia escondida».

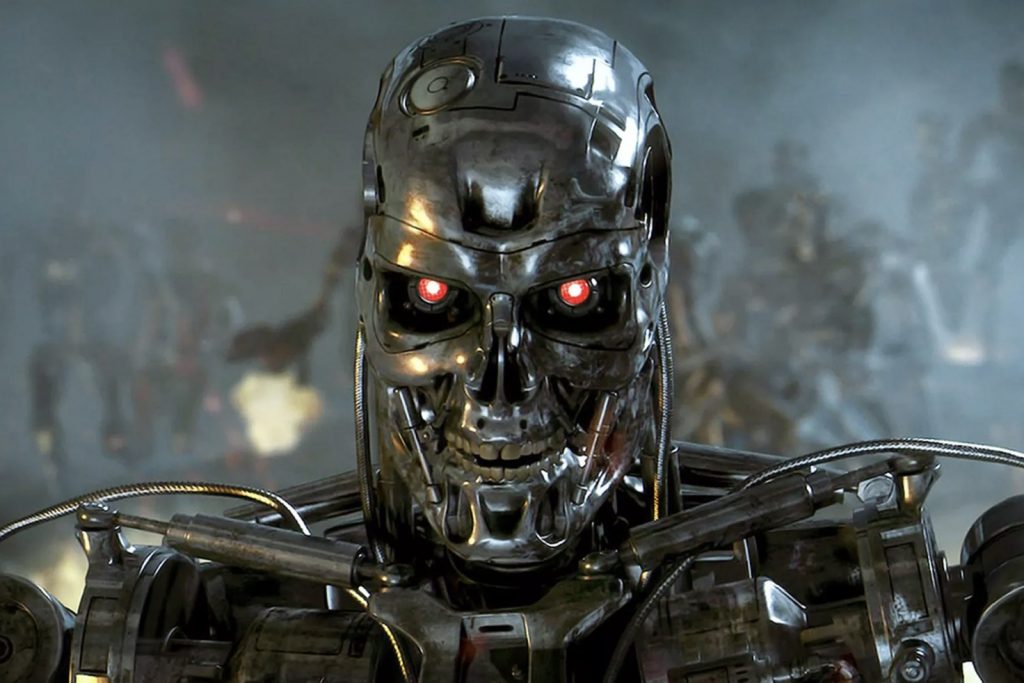

Pero no, no es así. Un modelo masivo de lenguaje no hace nada más que lo que hace cualquier algoritmo: aprender a relacionar conceptos y a formular frases con ellos. No piensa. No es inteligente. No es autoconsciente, ni siquiera consciente. Es, simplemente, una versión a una escala impresionante de la función de autocompletar textos de tu smartphone o de tu correo electrónico, que también puede parecerte en algunos momentos «inteligente» (y en otros, exasperantemente idiota). Es estadística, no inteligencia: simplemente, se trata de funciones estadísticas tan complejas y desarrolladas a una escala tan elevada, en modelos con tantos parámetros y con una memoria tan grande, que no podemos intentar seguirlos. Pero eso no los convierte en inteligentes, ni en capaces de tomar conciencia de sí mismos, ni mucho menos en Terminators que consideran que deben acabar con la humanidad. Eso es, simplemente, ciencia-ficción.

¿Conlleva el machine learning «profundos riesgos para la sociedad»? Pues indudablemente, una tecnología que algunos calculan que amenaza trescientos millones de puestos de trabajo puede suponer un riesgo, aunque también especulan que puede suponer un incremento del 7% del PIB global. El peligro para la sociedad tendrá más que ver con cómo se reparta ese incremento que con ninguna otra cosa: si, como ha ocurrido hasta ahora, se generan grandes disparidades en su reparto y se incrementan las brechas entre ricos y pobres, obviamente tendremos un serio problema, pero no debido a la tecnología, sino a la avaricia de algunos humanos. Si se envía al paro a millones de personas en industrias enteras y no se hace nada por ofrecerles alternativas, es evidente que surgirán problemas, pero la tecnología no será responsable de ellos.

La tecnología siempre ha provocado que determinados trabajos desaparezcan o sean sustituidos por máquinas. No es algo nuevo. Y sobre todo, es completamente inevitable: en cuanto su desarrollo se convierte en factible y bajan sus barreras de entrada, la adopción deja de ser voluntaria y pasa a ser obligatoria: el que no adopta la tecnología cuando el resto de su industria lo hace, se queda fuera de su mercado. ¿Más regulación? Tal vez, con todo lo que conlleva que regulen el fenómeno una serie de políticos que no suelen tener ni la más ligera idea, ni siquiera mínimamente aproximada, de lo que hablan. ¿Más responsabilidad y precauciones, sobre todo en la aplicación a determinados usos? Por supuesto. Pero según lo que sabemos de casos anteriores, va a estar complicado. Buena suerte.

Desde la aparición de GPT hasta ahora hemos visto como toda una explosión de financiación hacía posible la aparición de cientos de compañías dedicadas al desarrollo de modelos masivos de lenguaje, hasta convertirlos en una nueva religión: venir ahora, en plena competencia salvaje y desenfrenada, a pedir que pausen su desarrollo durante seis meses es, independientemente de la calidad de las firmas que tenga detrás la carta abierta en cuestión, una soberana estupidez. Y no va a pasar.

This article is also available in English on my Medium page, «A ‘pause’ on the development of AI? It’s not going to happen»

Elon Musk y Steve Wozniak son poco sospechosos de ser luditas. Y yo no creo que sus preocupaciones vayan por el lado de Terminators.

Harari ya es otro tema… el libro Homo Deus lo dice todo

Dos recomendaciones:

a) La primera, entras en chatgpt, y si alguien piensa que eso es AL DIA DE HOY peligroso, le recomiendo que se tome la pastillita

b) A pesar de lo limitadito de lo que te dejan hacer con chatgpt para mi es un salto cualitativo a mejor de lo que se hacía por poner una fecha en abierto en octubre 2022

No es cuestión de poner etiquetas estúpidas. de luditas o no luditas. Lo único que expresa la carta es que nos han pillado la delantera la competencia y estimamos que nos costará 6 meses pillarlos.

Hablamos en serio de IA y como VA A AFECTARNOS, pues se reunen los gobiernos, que para se les vota, para que nos representan, y que hagan LEYES para DISTRIBUIR LA RIQUEZA, y se pongan unas tasas fiscales para que las poblaciones puedan tener unos ingresos por la merma de puestos de trabajo y el caos que va a pasar SI O SI cuando las IA se extiendan, eso pasará seguro

y las moratorias son vaselina en el pompis para las empresas que hoy están con el culito al aire. NO

La carta se puede resumir en

«Queremos que APPLE sea la nueva KODAK?

y donde se lee APPLE se puede poner cualquier empresa que le ha pllado el toro con la rapidez que se ha movido OPEN-AI y MICROSOFT…

Yo por mi parte vería con buenos ojos que aparte de lo socialmente relevante de lo que expuesto antes, la UE o los americanos invirtieran en IAs OPENSOURCE al modo que gastan dinero público con la NASA o la ESA, para que un año pudiera bajarme GRATIS LIBREOFFICE con las características que anuncia MS para 365…

Eso sería un cambio para que la IA beneficiara a la humanidad, y no LA ESTUPIDEZ MANIFIESTA DE LA CARTA de marras

De acuerdo en casi todo:

Antes de que pongas los ojos en blanco por lo que te voy a decir, sé que lo pusiste a modo de ejemplo: pero el fuego, y la electricidad, son cosas que ya existían, y de las cuales como especie habíamos sido testigos de sus nefastas consecuencias si no se usaban con cuidado. Es más, tuvimos cientos de miles de años de entrenamiento en eso.

Pero al hablar de «hecho tecnológico» usas el mismo tipo de argumento de la industria petrolera, para defender su posición, por poner un ejemplo más adecuado. Y así estamos ahora…

Y exactamente ¿dónde está está escrito que esto no se puede discutir?

Porque la electricidad y el fuego, y su uso por nuestra parte, no se discuten, porque existen desde antes de nosotros, y existirán después de nosotros, pero los LLM, ML, IA o como nos pongamos de acuerdo como llamarlos, los creamos nosotros.

Supuestamente, la economía, los negocios, la circulación, y un montón de actividades humanas «imposibles de detener» se detuvieron cuando la pandemia (que parecería ser que causamos nosotros)… entonces ¿Porqué hay hechos que no se pueden discutir? Si se discute la autoridad de reyes y dioses, discutamos la autoridad de esta nueva entidad.

¿porque no vamos a discutir esto?

Disclaimer: el dogmatismo jamás fue virtuoso. ¿Puede que estemos equivocados? Sí, puede, pero tenemos derecho a estarlo…

Javier

Aqui estamos viendo una etapa Reina del Tour de France

No es una discusión moral es otra cosa

Se nos han escapado en dos etapas de los Alpes los de OPEN-AI, y vamos a ponerles una sanción para poder cogerles

¿Qué el Alcoyano gana muchas Champions? Compremos a los arbitros

Las cosas claras, es una gilipollez de un lobby y sus mariachis. No hay niños de teta en esta discusión

¿Queremos hablar de cambiar el Sistema? CO-JO-NU-DO !!! pero no es el tema… el tema es time to market

Y open-ai ha jugado tan bién su compelling event. Que igual le sale caro !!

No me digas que es como lo de prohibir coches de combustión, pero al revés.

Tenemos una tecnología de mierda, vamos a prohibir lo otro que si no no colocamos la mierda.

No es exactamente así. Es más bien «tenemos una tecnología mejor, más rápida, con más aceleración, con menos gastos de mantenimiento, que acelera más y que no contamina», pero algunos se niegan a aceptarlo y nos quieren envenenar a todos los demás y destrozar el puto planeta. Por eso hay que prohibírsela lo antes posible, y como no es una tecnología digital, sino que circula por las calles, hace ruido y echa humo, es fácil hacerlo»,

No, si puedes discutir lo que te dé la gana y las veces que quieras. Pero el desarrollo de la Ai no se detendrá por ello, lo discutas tú o el Papa de Roma (que el pobre está malito). Da igual lo que se discuta: siempre habrá alguien que continúe el desarrollo y le extraiga partido, te lo aseguro. Y será completamente inevitable.

Muy fácil: porque no existe un «nosotros». ¿Quiénes formarían parte de ese «nosotros» que discute esas cosas? Basta con que un grupo de humanos no participe de esa discusión (o legislación, tanto da) y siga experimentando, para que la discusión misma sea irrelevante.

Claaaaro, y esa pausa no la van a utilizar todos los competidores de OpenAI para ponerse al día, hahahaha.

Como dicen en Aruser@s: Mandahué que a estas alturas del partido le pidan al árbitro que pare el reloj… al equipo que va ganando.

Casi completamente de acuerdo con los que escribe Edans. Solo algunas consideraciones

Desde que tengo uso de razón no han cesado de aparecer «jeremías» predicando el fin del mundo, pero aquí estamos para demostrar que se confundieron.

No tenemos ni idea de cual es proceso del pensamiento en nuestro cerebro, ni mucho menos en que consiste la autoconciencia, la libertad de elección, y la creatividad, por tanto no podemos comparar si la AI, utiliza sistemas equivalentes o diferentes. Sabemos que la AI utiliza sistemas estadísticos bayesianos, como lo hace el cerebro humano es un misterio.

Lo habitual es que cundo el hombre imite la naturaleza, busque conseguir el efecto, pero no por los medios, el submarino no se parece en nada en su propulsión a un pez, ni un avión a una gaviota, el tocadiscos, nada tiene que ver con el trino de lo pájaros, la rueda es diferente a la pierna, y el radar nada tiene que ver con el sentido del murciélago. Sin embargo, el submarino supera a los peces, el avión a las aves, el tocadiscos a cualquier canto de pájaros, la rueda supera a las piernas, y el radar es mas potente que el eco de los murciélagos.

Por ello creo, que mas bien pronto que tarde, la capacidad de razonar de la AI, superará con mucho a la de los humanos. Pensar que va a hacerlo peor que los humanos mas inteligentes, (ya lo hace mejor que los tontos), es como no admitir, que hace años no hay humano que juegue al ajedrez como las máquinas, pese que todos pensamos que eso era imposible.

En cuanto los problemas que indican en la carta , perdidas de empleo, riego de control de los procesos vitales de la sociedad

«¿Deberíamos dejar que las máquinas inunden nuestros canales de información con propaganda y falsedad? ¿Deberíamos automatizar todos los trabajos, incluidos los de cumplimiento? ¿Deberíamos desarrollar mentes no humanas que eventualmente podrían superarnos en número, ser más inteligentes, obsoletas y reemplazarnos? ¿ Deberíamos arriesgarnos a perder el control de nuestra civilización?»

Ya los contesté en su momento las prevenciones que se tiene con la AI, son las mismas que pudimos tener contra la informática en 1950 y no nos ha ido nada mal con ella

Sabemos que la AI utiliza sistemas estadísticos bayesianos, como lo hace el cerebro humano es un misterio.

Correcto. Tienes toda la razón… ahora el varapalo a Open-ai, una vez que ha quedado claro que la cartita es como está parida un sin sentido.

Pero hay más variables…

De hecho con GPT4 tampoco sabemos que hay en sus tripas porque lo que han publicado como «Technical Report» es un «Marketing Report» no es como los papers de los Transformers de Google, que tienen además el código publicado. No explican nada.

Creo que es justo decir que la actitud de OPEN-AI es censurable, se aprovecha del trabajo que las otras empresas ofrecen en abierto en este tema (IA) pero ellos se guardan su trabajo para explotarlo en solitario comercialmente.

Igual que digo que la carta me parece una estupidez, la actitud de Open-ai es mezquina.

* GPT3

* GPT-NeoX

* Transformers

Attention Is All You Need

Y recordar que PyTorch es una libreria de Meta que está en abierto, y ha sido crucial para estos desarrollos. Así que punto positivo para Mark, y a Google por Tensorflow.

————————————-

PS: De la tecnología usada en el VE mejor no hablar que no toca, y además se basa en fastidiar a lo que funciona por el artículo 33. Y socialmente es inadmisible fomentar una solución aplicable como mucho a un 20% de la población. Eso es otro lobby que juega como los ubers y compañía a pisar la competencia con sus manejos políticos.

Salseo desde Google: Un investigador ha decidido dejar la compañía tras mostrar su desacuerdo en el uso de outputs generados por ChatGPT para el entrenamiento a Bard!

Salseo desde Google

y tambien…

«We launche a petition to democratize AI research by establishing an international, publicly funded supercomputing facility equipped with 100,000 state-of-the-art AI accelerators to train open source foundation models.»

Laion petition …..

Firma en OpenPetition

Para mi la firma del CEO de Getty Images ahí, es un síntoma diferente. Las empresas de foto de stock se ven de alguna forma amenazadas por temas de infracción de copyright prácticamente masivos por parte de los generadores de AI como Midjourney y similares. Ya han sido también muchos artistas en sitios como Art Station y Devian Art que se han quejado de ver incluso sus firmas dentro de imágenes que están otros “AI Artists” presentando como suyas… porque como dices la AI comete el error de poner incluso esa pequeña esquina con la firma de en una de las imágenes de las que se alimentó en ese momento.

Para mi el problema de las AI viene con una masa de usuarios analfabetas visuales generando ruido, no aportando nada, con cero formación visual y con cero responsabilidad, menos ganas de aprender a crear por propia mano.

Entiendo las AIs tienen increíbles posibilidades muy creativas, lo veo con las propuestas de Adobe en donde el diseñador escanea sus bocetos y la AI auto traza en vectores, aparte de generar variantes a partir del boceto. Eso como tal es genial, el problema viene de la replicación de estilos con absoluta ignorancia y la homogeneidad cultural (por lo popular que toma la AI para alimentarse). En ese sentido hay riesgo tanto el lenguaje visual como el escrito. Que los chicos terminen hablando verdades que un modelo de lenguaje les dio aleatoriamente y que nunca más corroboremos fuentes. Saludos.

En el antepenultimo parrafo está la clave: la humanidad no acabará exterminada por un Terminator que adquiera conciencia … y no hace falta. La humanidad se devastará ella misma creando aquello que dejara sin trabajo a buena parte de ella con las consecuencias sociales que ello traerá.

«Estaban tan preocupados por si podía hacerse que no se plantearon si debía hacerse».

John Connor: ¿No lo lograremos verdad ? Me refiero a la gente…

Terminator: Está en vuestra naturaleza destruiros mutuamente.

(ya que nos permitimos licencias…) XDDD

Es una tonteria por irrealizable.

Obviamente China y Rusia ( y USA en secreto) verían el parón como una ventana de oportunidad para adelantarse y llegar primeros a una AGI que si sería una enorme ventaja estrategica en su lucha por la supremacía.

Otra cosa es que se pongan mas medios para investigar los peligros potenciales y minimizarlos lo mas posible, pero ni siquiera eso es posible.

Ya vemos lo que ha sucedido con la Comision ética sobre la IA que tiene el Gobierno español, o el equipo de ética de la división de IA de Microsoft.

O sea las montan para darse bombo y en cuanto hacen recomendaciones contrarias al interes de la institución o de la empresa , todos fuera.

Y lo de Elon , aunque formalmente sus razones son impecables, por que se supone que invirtió en Open AI por esos motivos, creo que por otra parte ve que se le ha escapado la oportunidad de hacerse con una empresa, Open Ai, que tiene el potencial de ser una de las grandes del futuro, y quiere probar con una propia.

Pues va a ser que no… la cosa con Elon no fue como se decia (incompatibilidad con Tesla) … sino como imaginabamos algunos…

«O me das el control o me marcho»

The secret history of Elon Musk, Sam Altman, and OpenAI

Como yo no tengo esa tecnología, te la prohíbo.

En las muy altas esferas, debe haber unas batallas que reíros de la del abismo de Helm.

No se busca el bien común, se busca el poder y los demás somos victimas colaterales.

Enrique, dices que «[e]l hecho tecnológico es, en las sociedades humanas, completamente inevitable». Sin embargo, tú mismo promueves que se restrinja el uso de determinadas tecnologías, como los motores de combustión interna, las centrales eléctricas de carbón o la energía nuclear. La energía nuclear, por ejemplo, es tan «inevitable» que el mismísimo universo funciona con ella, pero aún así es posible y conveniente que los seres humanos controlemos su uso.

En cuanto a ChatGPT y similares, lo que he visto hasta ahora no me ha parecido demasiado impresionante, aunque entiendo que apenas estamos empezando. Lo que sí es claro es que la «inteligencia» de Siri, Alexa y Google Assistant ha quedado muy cuestionada y los que desarrollaron dichos productos deben estar preocupados. Es posible, también, que los que están en otros campos, como por ejemplo la conducción autónoma, hayan descubierto en estos días que sus desarrollos en el campo de la inteligencia artificial no han dado muchos frutos y que necesitan unos «seis mesecitos» para no quedarse fuera del juego.

El que la inteligencia artificial llegue a dominar el mundo al estilo de Terminator o Matrix resulta todavía improbable. Más probable, eso sí, es que los delitos informáticos y la guerra cibernética con la ayuda de la inteligencia artificial se vuelvan más sofisticados. En cuanto al tema del desempleo, ciertamente que no se trata de un asunto menor. A nivel global se trata de un tema muy crítico, aún sin que entre en juego la inteligencia artificial, y el encontrar una buena solución no parece ser la prioridad de la mayoría de políticos. Una renta básica universal podría ser parte de la respuesta, pero pocos países tienen la posibilidad real de financiarla.

Mauricio, yo no promuevo nada, yo uso el sentido común, que por lo que veo, es el menos común de los sentidos. ¿Quieres prohibir una tecnología como el machine learning, que cualquiera puede desarrollar en un laboratorio, con acceso a una nube y recursos de computación prácticamente ubicuos? Buena suerte. No va a pasar, lo diga el gobierno o el Papa. Se puede hacer, alguien va a beneficiarse de ello, y no se puede impedir. Es el ejemplo completamente opuesto al de la energía nuclear: ¿quieres prohibirla? Lo dices y ya está, porque como hay que montar un pedazo de central que cuesta miles de millones de dólares al erario público, pues no se construye y ya está. Es perfectamente susceptible de ser prohibida. ¿Los vehículos de combustión? Se prohibe su venta, y ya está, porque no se pueden «disimular»: son ruidosos, malolientes, evidentes y asquerosos.

Las tecnologías no tienen «derechos», ni puedes decir seriamente «¿por qué estas tecnologías sí y esta tecnología no?». Sé serio: ¿se puede prohibir (pretendiendo conseguir algo) el machine learning? La respuesta es NO. ¿Se pueden prohibir las criptomonedas? NO. Son tecnologías que se pueden desarrollar y explotar «sin hacer ruido», sin alertar a nadie, sin montar una central de miles de millones de dólares. ¿Se puede prohibir el coche de combustión? SÍ, perfectamente. De eso hablo, no de «los derechos de las tecnologías». Esa es la inevitabilidad del hecho tecnológico.

Enrique, el sentido común puede analizárselo desde diferentes puntos de vista, pero en muchas ocasiones es sencillamente una cuestión de poder. Tus razonamientos pueden tener mayor valor que los de aquellos que visitamos este blog, debido a tu formación, inteligencia y capacidad argumentativa, pero también gracias a tu nacionalidad, a tu posición social, a que eres un buen profesor, a que trabajas en un centro de educación superior prestigioso y a que eres un conocido formador de opinión. Eso significa que tienes mayor poder que cualquiera de nosotros y que con mayor facilidad tus argumentos van a ser aceptados como verdaderos porque así lo dice el maestro, es decir, aquella persona que en este caso tiene el poder.

Y dentro de esta cuestión del poder, pero refiriéndome a otro asunto, siempre hablaste, por ejemplo, de la imposibilidad de ponerle puertas al campo, pero aún así el enorme poder de los estados ruso, chino o norcoreano ha sido capaz de hacerlo. Que en los países mencionados haya quienes se saltan los controles de alguna manera es efectivamente así, pero se trata de un porcentaje muy bajo de la población. Y no estoy diciendo, de ninguna manera, que haya que imitar a dichos estados sino que dentro de la denominada «inevitabilidad del hecho tecnológico» no hay que olvidar tampoco la acción del poder, tanto político como económico.

Toda esta tecnología que, como tú dices, «se puede desarrollar y explotar sin hacer ruido» requiere de tiempo, dinero y unas condiciones mínimas que hagan que el trabajo valga la pena. Esto ha quedado muy claro con el software libre donde el trabajo por amor al arte termina por esfumarse luego de unos pocos años (o meses). Y si bien podría decirse que no es posible «desinventar» algo, en la práctica sí puede ocurrir que por diversas circunstancias caiga en el olvido o que se modifique nuestra relación con dicha tecnología, pues, como te habrás dado cuenta en los últimos años con Netflix y similares, los caminos del download son inescrutables.

Como casi siempre, estoy de acuerdo en general con usted. Sin embargo, al igual que sucede en otros ámbitos a lo largo de nuestra historia, la cosa puede complicarse si se establece la idea generalizada de que la inteligencia artificial «tiene razón», y que está capacitada para tomar decisiones de cualquier tipo que afecte a la vida de las personas, y determinados lobbies lo apoyan.

Otra opción sería que algunas empresas necesitan que la cosa no vaya tan rápido, para poder especular con el tema.

Saludos

Es que no tiene razón ni deja de tenerla. Recombina palabras, frases y conceptos como lo podría hacer cualquier otro. Si alguien piensa que es infalible o «más lista», tiene un problema. Solo tiene más memoria y más capacidad de establecer relaciones estadísticas. No es infalible.

Es que yo creo que el tener inteligencia, por defecto, implica no ser infalible, pues puedes hacer inferencias sin tener toda la información disponible, por ejemplo. O tener información incorrecta con la que has entrenado al sistema o a la persona.

Con ello no digo que los LLM «sean inteligentes» necesariamente. Y, por supuesto, sería caer en un grave error tomar su respuesta como la biblia, como si no hubiera margen de error.

De hecho, considerar sus respuestas como «siempre buenas e indiscutibles» es uno de los riesgos de esta tecnología.

OFFTOPIC:

«Hay dos tipos de personas que usan ordenadores¹: aquellas que ya han perdido datos y aquellas que los van a perder.»

Hoy es el dia Internacional del Backup XDDD

y recordar… ojo con la nube

porque patatas

Puedo estar de acuerdo con Enrique en que ChatGPT o GPT4 «no piensa», «no es consciente», «no razona» etc…

Pero creo que el problema al que nos enfrentan estos LLMs, al menos a nivel filosófico, es a intentar definir (cosa que creo que a dia de hoy nadie lo ha hecho con precisión) que es la consciencia, la inteligencia, etc.

Por ejemplo, durante muchos años, se creía que el test de Turin (que ahora parece tener muchas carencias) era la «prueba del algodón» de si un sistema había conseguido la AGI.

No se si se ha probado, pero si no es con chatGPT o GPT4, es más que evidente que estamos a punto de superar dicho test con estos sistemas (si no se han superado ya).

En resumen, conforme más nos acercamos a la AGI, más exigentes nos ponemos y mantenemos que «no tienen consciencia», «que no son inteligentes», «que no razonan», etc.

Tengo claro que no tienen consciencia, pues faltan ingredientes como las emociones. Pero, son inteligentes? Pues creo que dependerá de la definición de inteligencia. Razonan? Dependerá de que entendamos que es razonar. Porque aunque no dejen de ser algoritmos estadísticos, quien nos dice que nuestro cerebro no trabaja de manera parecida y si nos atribuimos la capacidad de ser inteligentes y de razonar?

Resumiendo, que no son conscientes lo tengo claro. Que no sean inteligentes y no razonen lo veo claro si nos centramos en su forma estadística de trabajar, pero el resultado empieza a acercase peligrosamente a muchas de las definiciones que he leido de inteligencia y razonamiento. Por lo tanto, como caja negra, independientemente de como lo consigan, yo creo que nos obliga a replantearnos que es la inteligencia y el razonamiento.

Mi hermano asistió esta misma semana a una presentación en Madrid de ChatGPT y GPT4 y me explico algunas anécdotas prácticamente increibles. Entre ellas, que ni los mismos presentadores eran capaces de responder a muchas de las preguntas de los asistentes, pues creo que tienen claro como funciona tan bien el sistema…

Un saludo!

Como suele decirse me serviría de chiste si la cosa no fuera tan triste.

Esta carta de los «tecnoempresarios del mundo uníos», se parece un montón a la carta que envió Skynet, antes de montar la que montó (en el cine). Diciendo aquello de que los humanos tenían que preocuparse más del hambre y de las guerras, así como del derroche energético, en vez de especular con los posibles peligros de la IA. Era claramente una cortina de humo, que no tiene mucha tecnología, pero supone un incendio que puede llegar a ser «terminal».

En fin, ya sé que lo que digo parece contradictorio con esta misiva de autorrepresentantes terrestres (en la próxima Conferencia Universal sobre el Estado de la Galaxia), pero va con la intención de reírme un poco de los signatarios, posibles representantes, como Federación Comercial, de un posible Emperador Galáctico, que se nos quiere colar desde el lado oscuro de esta Humanidad tan mediocre.

Como si el peligro fuera el algoritmo y no sus retorcidos cerebros, de homo sapiens en situación de «frenos del proceso evolutivo». Porque la evolución no es solo mandar seres humanos a Marte. ¿De que le valdrá a la Humanidad actual, en su conjunto, si son como el Pato Trump los escogidos para poblar Marte, por ejemplo?

Y, por eso, la tecnología es neutra, pero en manos de trumpianos es perfectamente capaz de cargarse el futuro. Todo lo contrario de lo que puede hacer la poesía, incluso la «mala». También la tecnología soviética era neutra.

Xaquín, yo soy un firme defensor de la filosofía de que «la tecnología ni es buena ni es mala, dependerá del uso que los humanos hagan de ella».

Pero hay un aspecto, que ilustraré con la energía nuclear de fisión, que creoqen el fondo se debate en este artículo:

El proceso de fisión en cadena, más allá de poder utilizarse para crear bombas atómicas, todos sabemos que es el principio por el que funcionan las centrales nucleares.

Pero su peligro (y tanto Chernobil como Fukushima nos enseñó) es un proceso que se puede descontrolar hasta fundir el nucleo del reactor.

Yo creo que peliculas como «Terminator» introducen la idea de que la AGI pueda ser una tecnología que, si no se conoce bien, según donde se aplique, puede descontrolarse.

Que ese descontrol sea en una aplicación aislada, sin una relevancia vital para la civilización humana y totalmente «vallada», puede generar un problema de descontrol que quede en una anécdota.

Pero si esa tecnología se utiliza en una aplicación clave para el funcionamiento de la sociedad y se descontrola, a lo mejor si que provoca una catástrofe importante.

Es como lo que dije en el artículo anterior: No se si a dia de hoy es posible colapsar internet a nivel mundial. Pero si alguien, queriendo o no lo consigue, podemos pasar, como mínimo, un periodo de hambruna, pues hoy en dia todo lo que es logística está intimamente entrelazado y requiere de internet para su organización minimamente eficiente. Vaya, que un parón global de internet, sin ser un ente inteligente, podría provocar una catastrofe global al menos durante un periodo de tiempo considerable, mucho peor que el covid-19 sin ir más lejos.

Un abrazo!

En mi opinión el mejor ejemplo expuesto hoy ha salido de la pluma de GORKI, cuando afirma:

«Lo habitual es que cundo el hombre imite la naturaleza, busque conseguir el efecto, pero no por los medios, el submarino no se parece en nada en su propulsión a un pez, ni un avión a una gaviota, el tocadiscos, nada tiene que ver con el trino de lo pájaros, la rueda es diferente a la pierna, y el radar nada tiene que ver con el sentido del murciélago. Sin embargo, el submarino supera a los peces, el avión a las aves, el tocadiscos a cualquier canto de pájaros, la rueda supera a las piernas, y el radar es mas potente que el eco de los murciélagos».

Y remata diciendo: «Por ello creo, que mas bien pronto que tarde, la capacidad de razonar de la AI, superará con mucho a la de los humanos. Pensar que va a hacerlo peor que los humanos mas inteligentes, (ya lo hace mejor que los tontos), es como no admitir, que hace años no hay humano que juegue al ajedrez como las máquinas, pese que todos pensamos que eso era imposible».

GORKI mira hacia atrás y se topa con lo que el hombre lo que ha hecho a lo largo de la historia para la evolución de la humanidad, que es imitarla al menos, y cuando pudo, copiarla. Al menos eso es lo que intentaron los hermanos Wright o Isaac Peral y otros. Los pasos siempre han sido los mismos para lograr imitar a la naturaleza y conseguir que el ombre volara o surcara las aguas profundas.

Cuando la raza humana se propone algo, no para hasta conseguirlo. Los nuevos propósitos y retos ya se conocen, el descubrir donde está la base del desarrollo de la inteligencia natural para imitarla, es uno de estos nuevos retos. La investigación de las redes neuronales y su funcionamiento, es otro de los retos. A ello se están dedicando ingentes cantidades de dinero.

¿Quien para esto? Estoy con Gorki y con Dans en que esto no hay forma de pararlo. pero SI HAY FORMA DE MANEJARLO Y CONTROLARLO, AL MENOS EN SUS EFECTOS, QUE SERÁ DONDE HAY QUE PONER EL ÉNFASIS.

Se me olvidada decir que por lo que se ve, estamos mas cerca de lo que parece para que la Inteligencia artificial se inmiscuya en la mente humana. No lo digo yo: lo afirma la investigadora y profesora en la Universidad de Duke Nita Farahany, que en su nuevo libro The Battle for Your Brain, la profesora de biociencias de la Universidad de Duke, Nita Farahany, que argumenta que tales intrusiones en la mente humana por parte de la tecnología están tan cerca que hace mucho tiempo que se necesita una discusión pública y que los legisladores deberían establecer de inmediato protecciones cerebrales como lo harían con cualquier otro. ámbito de la libertad personal.

Los desarrollos recientes de la IA por un lado, y los de Neuralink, la empresa de Elon Musk por el otro, hacen que cuando estas tecnologías confluyan, e interactuen ambas, podamos afirmar que algo nuevo ha nacido y que sus efectos marcarán el inicio de una nueva era en el Planeta.

Farahany, quien formó parte de la comisión de Barack Obama para el estudio de cuestiones bioéticas, cree que los avances en neurotecnología significan que las intrusiones a través de la puerta de la privacidad del cerebro, ya sea a través de programas militares o mediante laboratorios de investigación bien financiados en grandes empresas tecnológicas, están disponibles a través de innovaciones del cerebro a la computadora, como la tecnología portátil.

Y añade Farahany: “Todas las principales empresas de tecnología tienen inversiones masivas en dispositivos multifuncionales que tienen sensores cerebrales”, y sigue, “Los sensores neuronales se convertirán en parte de nuestra tecnología cotidiana y en una parte de cómo interactuamos con esa tecnología”.

Junto con los avances en la ciencia destinados a la decodificación y reescritura de las funciones cerebrales, están muy extendidos y plantean un riesgo perceptible, argumenta Farahany, y requiere una acción urgente para someter a los controles acordados.

“Tenemos un momento para hacer esto bien antes de que eso suceda, tomando conciencia de lo que está sucediendo y tomando decisiones críticas que debemos tomar ahora para decidir cómo usamos la tecnología de manera que sea buena y no mal utilizada u opresiva”.

El cerebro, advierte Farahany, es el único espacio que todavía tenemos para el respiro y la privacidad, y donde las personas pueden cultivar un verdadero sentido de sí mismos y donde pueden mantener cómo se sienten y sus reacciones hacia sí mismos. “En un futuro muy cercano eso no será posible”, dijo.

Farahany continúa explayándose en un reciente artículo publicado en The Guardian cuyo enlace os dejo para que lo leas. Es muy interesante, y nos avisa de los muchos riesgos, y de los muchos beneficios que estos avances nos han de proporcionar.

https://www.theguardian.com/science/2023/mar/26/nita-farahany-the-battle-for-your-brain-neurotechnology

HAY FORMA DE MANEJARLO Y CONTROLARLO, AL MENOS EN SUS EFECTOS, QUE SERÁ DONDE HAY QUE PONER EL ÉNFASIS

Me quedo con esto… y de ahi, el contexto de la open letter que parece que nadie quiere ver…

A dia de hoy, no he leido en ningun sitio que se pida «que se detengan las maquinas y no se investigue mas en el tema» como algunos quieren dar a entender…

Cuidado, que lo de los firmantes de la carta abierta no está tan claro como parecía…

The Open Letter to Stop ‘Dangerous’ AI Race Is a Huge Mess

Future of Life son una organización títere

de quien??????

https://futureoflife.org/person/24104/

Hay que tener un poco de decoro este quiere ser el niño en el bautizo, la novia virgen en la boda, y el muerto en el entierro

Gamuzas, ruedines, silbatos, lanzallamas y ahora esto:

Tesla anuncia Gigabier, una edición limitada de cerveza inspirada en el Cybertruck

a 30 lereles el tercio… luego que si nos reimos de (todos) ellos… XDDD

Voy a hacer análisis de mercado….

La «Especial» de Mercadona tiene el mejor ratio sabor/precio. Si la verde es más barata…

Un defecto tienen las 2: por ahorrar las latas son una m…. y de vez en cuando te la arma….

He empezado a escuchar el directo de dotCSV sobre el tema… este hombre (Carlos) tiene una especial habilidad para transmitir.

Estrella Galicia. Ya ha conquistado más de media España, y lo siguiente es el mundo…

Sois unos ineptos cerveceros… ahi lo dejo…

«Estrella Galicia, Estrella Galicia….» BAH..!!! :P

-> Jose Mª Rivera Corral funda en 1906 la fábrica “La Estrella de Galicia”

-> «Estrella Damm es una cerveza lager estilo pilsener elaborada con malta de cebada, arroz y lúpulo, siguiendo la receta original desde su fundación, en 1876»

Hasta el nombre copiasteis… XDDD

Si es de supermercado, la Steinburg del Mercadona, no esta mal… flojilla, pero para pasar el dia va bien… se calienta rapido y se desbrava tambien (puedo zamparme 10 en un dia. No completas, tiro la mitad caliente).

Por un poco mas, la Lager del Bon Area (vosotros no teneis), muy nivel Mahou

Y me da igual lo que diga ChatGpt, que con cervezas, me lo meriendo. XDDD

Enrique, me gusta mucho cuando dices «es estadística, no es inteligencia».

Pero en algunos libros que leí sobre el funcionamiento del cerebro parece que postulan algo similar (eso, o a lo mejor yo no estoy entendiendo nada). Después de todo para hacer redes neuronales lógicas se imita justamente el funcionamiento en red de las neuronas… mismas que funcionan asignando «pesos» a sus inputs y «decidiendo» estadísticamente.

Con esto no quiero decir que no tengas razón en tu declaración, sino que el cerebro es muchísimo mas potente que cualquier supercomputador y a lo mejor los principios de funcionamiento pueden parecerse a los que usan «machine learning».

Las pajas mentales sobre GPT-4 ….. muy bonitas

Lo serio

Italia veta GPT4 por incumplir el GDPR

Quien dijo algo al respecto en este blog?….

https://www.gpdp.it/web/guest/home/docweb/-/docweb-display/docweb/9870847

Intelligenza artificiale: il Garante blocca ChatGPT. Raccolta illecita di dati personali. Assenza di sistemi per la verifica dell’età dei minori

Coño tanto aleman, tanto francés y es Italia el primero … en darse cuenta del casino de GPT4…

Forza Italia!

PS: Por supuesto temas de privacidad, a EEUU se la traen floja

Estoy sin conexión y fuera de casa, voy a ser muy conciso.

No existe ninguna posibilidad de qué algo así ocurra. Es un problema de percepción – e ignorancia – de quién firma esa carta , que proyectan sus propios miedos en una idea errónea de las tecnologías que engloba el término «inteligencia artificial »

«Inteligencia» en lo que se refiere a la tecnología no implica nada que tenga que ver con lo que experimentan las personas.

Una máquina » inteligente» no tiene auto-consciencia, volición, identidad propia, motivación, autonomía, ego, personalidad, ni pulsión consciente o involuntaria, ni ninguna autopercepción de sí misma, que impulse ninguna «decisión consciente» o «motivada» ni racional en cuanto a su «interés propio» o de auto-preservación, ni toma decisiones propias. Son coches sin motor.

Lo que están experimentando esos profesionales es una ilusión o sentimiento de amenaza que se conoce como Uncanny Valley o síndrome de Frankenstein, también conocido como monstruo del armario.

El cerebro humano no se réplica en las tecnologías englobadas en el término «inteligencia artificial» nos está sobrando las tres cuartas partes para cualquier función relacionada con el Machine learning o IA. (No cuento ya a algunos)

Y no, esas partes no se van a autogenerar ni le son necesarias a ninguna máquina, igual que los coches ejecutan su tarea sin tener que pastar en la dehesa.

Es simplemente el nuevo flúor en el agua o las Hadas de Conan Doyle.

Asi que no, rien de rien, es una ilusión dieciochesca. Y de una ignorancia horripilante, por lo demás.

–

Pa lo que ha quedado Wozniak, que no necesitaba ningún protagonismo

@EDans: Lo siento pero te equivocas totalmente y chatgpt lo demuestra. La inteligencia humana es probablemente menos «mágica» y especial de lo que nos pensábamos, y se parece más a estos «algoritmos» (q por cierto, llamarlo así sí que es erróneo, se parecen más a un sistema dinámico complejo) que a un alma/espíritu sagrado.

Ha bastado sobrepasar una escala de computación (como por cierto ha ocurrido en todos los ámbitos de la ciencia), para abrir toda una escala de comportamientos emergentes. El siguiente melón que se abra, imagino que añadiéndoles una representación interna de un «concepto mundo» y de la idea del tiempo, se parecerá tanto a nosotros que ahí sí que nos vamos a cagar por la pata abajo.

El siguiente paso, y para mí el más difícil e inimaginable, es dotarlas de motivación (al no haberlas parido con instinto de supervivencia; aunque cuando las dotemos de cuerpos puede que emerja de manera espontánea).

Te digo todo esto como investigador en Física que se está estudiando libracos de AI, y que entiende las matemáticas usadas.

Que por cierto, ya veis la escala energética/monetaria de entrenar y ejecutar estas AIs. Para la siguiente escala necesitamos que su base física deje de ser electrónica