Aunque el número de usuarios de ChatGPT comienza a caer por primera vez desde su lanzamiento, con un 10% menos de visitas en todo el mundo a lo largo del mes de junio, empiezan a verse cada vez más casos de AI-spam, de páginas en la red escritas mediante algoritmos generativos – algunas no se molestas siguiera en borrar los tan reconocibles párrafos del tipo «lo siento, como modelo de lenguaje basado en inteligencia artificial, no puedo generar…» o del «en resumen…» final.

Estamos ante un absurdo conceptual de primer nivel que parte de lo que era ya una situación completamente deteriorada: la industria de la creación de contenidos, páginas creadas en factorías en las que personas se dedicaban a copiar, mezclar y pegar otras páginas con el fin de generar un flujo constante de contenidos destinados a indexar y a albergar anuncios, o a convertirse en generadores de enlaces vendidos al mejor postor. Si el SEO ya destrozó la web y llenó el mundo de granjas de páginas, ahora la llegada de los algoritmos generativos en manos de completos irresponsables promete hacerlo todavía más rápido, en lo que podría estar convirtiéndose en una degradación creciente del conjunto de internet.

Esa degradación parte de un problema de base: desconocemos con qué páginas son entrenadas los algoritmos generativos, y por el tipo de errores que vemos habitualmente en sus respuestas, tendemos a intuir que la selección de partida ya no respondía a criterios muy bien delineados. Pero la pregunta subsiguiente es evidente: ¿quién debe decidir qué páginas son seleccionadas para alimentar los algoritmos generativos?

Como ya insinuó Google hace ya años, crear algún tipo de «índice de autoridad» que decida qué páginas responden a criterios razonablemente rigurosos y cuáles son basura, mentiras, conspiranoia o directamente estupideces es algo que puede parecer muy interesante, pero que adolece de muchos problemas: el primero, subjetividad: quien tome esas decisiones, estaría obteniendo, en caso de lograr estandarizar su criterio, un poder enorme que conlleva, como diría el tío Ben, una gran responsabilidad. El segundo, factores culturales: lo que es indiscutible o cierto en un contexto cultural determinado, puede no serlo en otro. Y finalmente, interés: seleccionar unos contenidos sobre otros puede hacerse con el objetivo de preservar la verdad, o como ha ocurrido habitualmente, para conseguir ganar más dinero a costa de lo que sea.

Ahora, estamos viendo como el lanzamiento de ChatGPT a finales del pasado noviembre está comenzando a llenar la web de contenidos basura generados automáticamente, y si no se presta atención a los criterios de entrenamiento de esos algoritmos (que se hicieron públicos y de libre uso, no lo olvidemos, no porque OpenAI sea un encanto, sino porque así obtenían más datos para su entrenamiento), pronto empezarán a alimentarse de los mismos contenidos que han generado, lo que resultará en un ciclo de retroalimentación potencialmente muy negativo, capaz de convertir en «verdades por consenso» cuestiones que simplemente eran erróneas porque las primeras páginas que se utilizaron en el entrenamiento del algoritmo eran erróneas o inexactas.

Algunos profesores de Física, por ejemplo, alertan de que las respuestas de ChatGPT en su área son muchas veces incorrectas y confunden a sus alumnos, y que esos errores responden claramente a una mala selección de los textos de entrenamiento. Si cada vez más personas no solo confían en ChatGPT y en sus errores, sino que además crean contenido con ellos, terminaremos por consolidarlos como tales, como de hecho ya ocurre con buscadores y redes sociales que impulsan «verdades por consenso». Del mismo modo, para ChatGPT, un salmón no es un majestuoso pez que remonta los ríos para desovar en el lugar donde nació, sino un filete de un imposible color naranja (no, la carne de los salmones no es naturalmente naranja, eso es solo el colorante artificial que ponen en el pienso con el que los alimentan). ¿Qué pasará cuando el algoritmo «olvide» completamente lo que es un salmón?

Sigo en mi preocupación: la regulación no debería tratar de controlar el desarrollo tecnológico, que es de por sí completamente, incontrolable, sino los usos de esos desarrollos: los algoritmos generativos pueden ser muy interesantes, pero utilizarlos para llenar páginas con contenidos generados automáticamente debería ser una actividad calificada como ilegal y, por tanto, perseguible. Como debería serlo también el utilizar esos algoritmos para generar publicidad personalizada, una actividad sustentada simplemente por acuerdos de términos de servicio abusivos que nadie se lee creados por compañías privadas, pero que claramente no responden a un consenso social sobre los límites que debería tener la actividad publicitaria. Si la actual publicidad ya hace sentir a muchos sensaciones cercanas a la paranoia y a creer que sus dispositivos les escuchan constantemente, veremos qué pasa cuando sean algoritmos los que, basándose en nuestra actividad en la red, diseñen los mensajes específicamente para nosotros con el único objetivo de que hagamos clic en un anuncio.

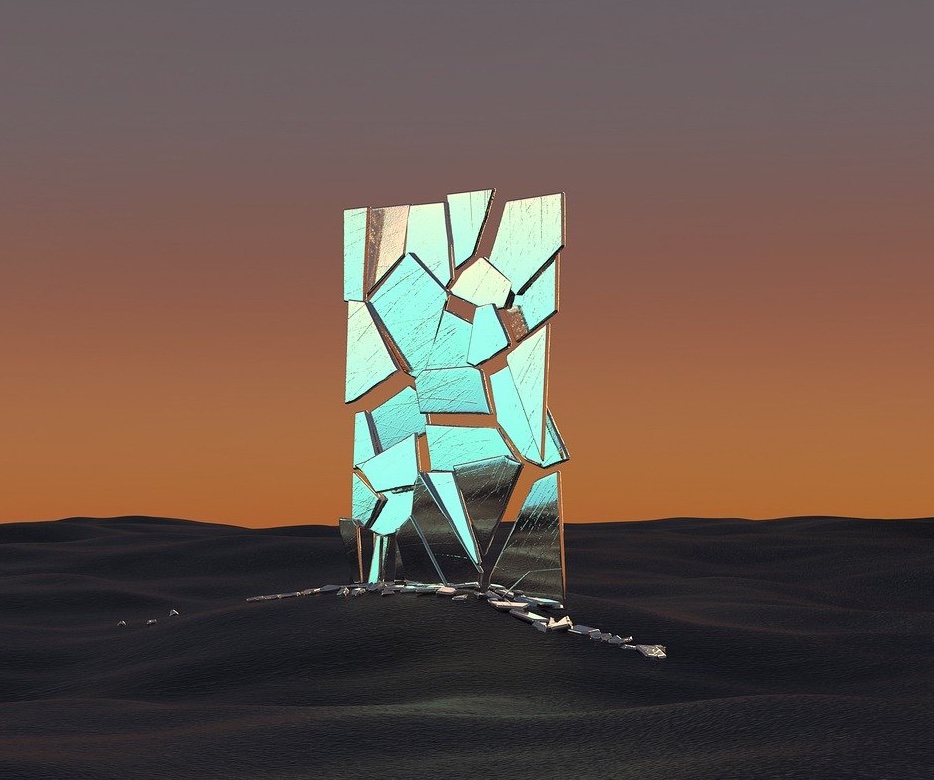

Lo que viene, si seguimos por este camino, va a ser como mirarse en un espejo cada vez más roto. Y la imagen que obtengamos no va a ser en absoluto bonita.

This post is also available in English on my Medium page, «Generative algorithms and cracked mirrors»

Vivimos en un mundo absurdo, donde hay paginas web fantasmas, cuto contenido es creadas por máquinas, para que según las palabras que aparezcan en el texto, unas máquinas decidan poner ciertos anuncios, que serán sólo visto por otras maquinas creadas para simular visitas en las web fantasmas.

¿Hasta cuando los anunciantes, o sus agencias publicitarias, van a decidir abandonar los métodos mecánicos, para seleccionar en qué páginas quieren anunciar sus productos? ¿Cree alguien que esas paginas creadas con contenidos robotizados son visitadas por humanos?.

Gorki

Y si por un instante pensaramos que el algoritmo no se equivoca, y eres como los anuncios que te llegan (Dunning-Kruger)

ÑOCO

Que va a escribir chatGPT mejor que un profe…

«algunas no se molestas siguiera en borrar» XDDD!!!

que te vas a parecer a SANTA… el abuelete que no sale un comentario bien escritoooor

Publicado ayer en Microsiervos.com:

AI.txt, una iniciativa similar a Robots.txt para restringir el acceso a los datos a las inteligencias artificiales

Si la red se llena de contenidos generados por la IA y el algoritmo se alimenta cada vez mas de contenidos generados por la misma IA con el consiguiente deterioro en la calidad el contenido la evolución lógica es que se cree una etiqueta reputacional a la que solo puedan acogerse paginas que pasen un cierto nivel de calidad.

Eso sería «el mal de las vacas locas de la IA» te acuerdas que a las vacas le daban de comer harinas procesadas hechas con despojos de vacas…

Me gusta mucho el símil, Me lo apropio.

Cada IA va a ser mas loca que la anterior por beber en fuentes contaminadas por las IA que le precedieron.

Claro, Gorki sin problemas, un honor que lo use el comentarista con más arraigo del blog !!

En ML, también existe el fenómeno de over-fitting o sobre-ajuste que sería similar.

Al final los defensores de regular la IA, no dejan muy claro como van a regular la IH… o mucho peor, dan por supuesto que la IH no necesita una regulación y, además , bien potente. Por ejemplo, la ya clásica de «enseñar a expresarse un poco mejor».

Al final siempre se acaba llamándole censura a decir que hay IH que solo dicen paridas mentales (por ejemplo, muchos políticos)… y, bueno, pues puede ser muy posible, que «censuremos la mala comprensión/expresión». Pero, cada uno hace lo que puede en este río social tan revuelto… y, desde luego, las IAs no pueden ser responsables de «lo que dicen». Las IHs sí.

Después de leer su artículo, este humilde comentarista que no tiene ni idea de lo que es la Inteligencia Artificial, deduce que;

Existen dos tipos de algoritmos:

Algoritmos generativos y algoritmos degenerativos, este último funciona como cualquier cáncer.

¿Es correcto?

Los degenerados son los que utilizan para dar créditos, filtrar selección de RRHH, decidir quien puede acceder a la libertad condicional,…

Enrique, tal y como dijiste en algún artículo anterior una vez sacado el genio de los LLM de la botella no se va a poder restringir su uso para todo aquello que sea útil para alguien, sea bueno o malo.

El problema está en que si educas a un LLM (igual que a un niño) con basura obtendrás un suministro inagotable de la misma.

Para educar bien a un LLM hay que seleccionar bien lo que se le ofrece (como a un niño) y no resulta fácil ni barato. Además de que no puedes depender de lo que a la gente le de por subir a internet.

Hace un tiempo estuve analizando un framework para hacer chatbots, y en esencia no me parece complicado que responda correctamente a ciertas preguntas (parecido a lo que han hecho con los plugins) y el problema de la alucinación no acabo de pillar pq es tan dificil de atajar

En esencia se trata de tener un pipeline de procesos pequeños que analicen cada frase y entonces tienes el bot tiene que ser capaz de reconocer la intención del humano (que está preguntando) y las entidades relacionadas.

Por ejemplo ¿Qué hora es en Nueva York?»

Intención: están preguntando la hora

Entidad: En una determinad ciudad

Con eso el puede contestar. Y habrá casos que deba preguntar más porque puede haber preguntas incompletas

Y en el proyecto que estuve haciendo, lo dificil era simular una respuesta sintácticamente correcta y rica.

Pues esto que era lo dificil, lo hace estupendamente el chatgpt(redactar) pero en no alucinar es un coladero…

No sé. Igual con la complejidad que le han metido, ni ellos mismos saben como callar al loro estocastico…

Pero no me cuadra pq la cortesía de «Lo siento… » si les funciona el pipeline del filtro, y corta las groserías…

Ayer le hice unas preguntas sobre el historial deportivo de una persona y su contestación a una de las preguntas fue: No tengo datos desde septiembre de 2021. Entiendo entonces que su entrenamiento no es continuo.

Me llama especialmente la atención el aporte que realiza Juan T.

Creo que está estrechamente relacionado con las ya mitológicas “Fake News”. Y es que llevo diciendo ya demasiado tiempo que el periodismo actual es víctima de sí mismo y sus manías, tales como ser complaciente con aquellos que le aportan dinero o en los que cree que son los buenos, porque así interesa que sea.

Quiero decir, si cualquier medio de comunicación a elegir, fuera realmente independiente y permitiera un periodismo libre del capitalismo salvaje, quizás ese medio de comunicación y las voces en él, sería. Hoy considerados “verdades absolutas y punto”.

En Wikipedia, por ejemplo, ya sabemos que hay margen a la gracia, el chiste y el vandalismo, que tiende a durar poco tiempo más allá de la vitalizacion de un acto concreto hecho por humanos y con intencionalidad. O al menos es la impresión que aún tengo yo, que es un sitio donde consultar y obtener datos relativamente verídicos y de respaldo.

Esto podría pasar con El Español, por ejemplo. No lo sé porque no lo visito nunca, pero sería una buena manera de derribar Fake News. A golpe de reputación.

Si no hay una categoría especial para denominar las webs con contenido generado por humanos y las generadas por IA, llegamos al problema de pérdida de reputación, de confianza pero no por ello de viralizacion, por supuesto.

Esto me lleva a pensar en la Internet de 2 vias. ¿Recordamos cuando hace algunos años se promulgaba aquella fatídica idea de dos velocidades de internet?

Me pregunto si no reviviría aquella idea. Una Internet donde lo que encontraras en ella serían artículos, posts en foros, reviews sobre productos comprados y lo que puedas imaginar, todos ellos reales, humanos y medios verificados mientras que en esa internet de segunda clase, todo ello quedaría sepultado por la inmensa incertidumbre de si lo que ves o no, es cierto, si tu interacción es real.

¿No os gustaban las suscripciones? Esta iba a hacer daño…

Se me antoja un escritorio lleno de papeles, todos revueltos y mezclados lo que se dibuja leyendo el artículo de Enrique, vaya incertidumbre de futuro.

….y un día alguien se demostrará que sí, nos escuchaban. Que sí (según snowden es lo menos), y todos esos artículos tachando al resto de conspiranoia (que de por sí es tendencioso) ni lo reconocerán jamás.

Mi mujer tiene un curioso gusto sobre zapatos holandeses,se anuncian en Instagram, ni por asomo es posible recibir en mi dispositivo esos zapatos tan concretos, y sin embargo así fue. No tengo Instagram, ella sí. Ambos con permisos negados de escucha Siri ella, Google now yo, da igual. En ese caso concluimos que es al compartir wifi.

Además, el algoritmo es un mito, un mito nefasto. Solo se explica así que la publicidad «personalizada» lleve más de un año a acosándome con mormones, cryptofuckers, timadores de Trading, especuladores, y vendedores timos de Amazon. Ni tengo un Amazon, ni sé que es una inversión y mucho menos creo en dioses, mucho menos si viene de otro planeta. ¿Tan mal tipo cree Google que soy?

Lo dicho, si el algoritmo de YT existe, tienen un problema (bueno, lo tengo yo) con su desarrollo.

Escuché en algún lado que el otro timo del momento, los llamados sistemas expertos (popularmente I.A) están ya implementados en Siri, Edge, Google Search, Bing, opera.

Si a alguien le ha ido mejor más allá de las updates lógicas,que me lo diga, le doy un € electrónico.

Por el momento, aún no son ni capaces de traducir bien sin ayuda, imagina un documento legal, las «voces» no son capaces de diferenciar más allá de un entorno controlado, rallan bastante, y solo a nivel corporativo (controlado) dan el pego. Solo quiero una voz comercial que funcione bien. No hay ni una sola app domèstica que ocupe esos nichos bien, raro verdad?.

Eso sí, seguimos con el algoritmo maquina de Google Search que todo lo sabe, que los que saben, saben que hay una subsidiaria irlandesa, que contrata a gente around the world (ahora debe ser polaca), para que clasifique el contenido de Google y por supuesto «alimente»sus sistemas expertos. (Ahora también I.A), son personas quienes alimentan «algoritmos».

Alguien recuerda la bilbaína Sherpa? es que es el mismo principio de entonces.

Claro, el problema de que un sistemas experto se alimente por sí mismo es el que se comenta aquí. Que se come toda la porquería de tal forma que la post-verdad va a darnos risa.

Pero bueno, quién te dice que lo anterior sí era cierto?.. Bueno, las ciencias duras, por lo demás estamos condenados a la estultez y a la vagancia de una máquina