La inteligencia artificial generativa está evolucionando en dos direcciones distintas: por un lado, los usuarios expertos construyen sus propios RAGs, agentes personales o incluso pequeños modelos de lenguaje (SLM), adaptados a sus contextos y datos. Por otro lado, la inmensa mayoría de usuarios, que se conforma con los LLM tal y como vienen, «como salen de la caja»: abrir una página, escribir una consulta, copiar el resultado y pegarlo en otro sitio. Esta división entre desarrolladores y consumidores está determinando no solo cómo se utiliza la inteligencia artificial, sino también si aporta o no aporta valor.

La diferencia no radica únicamente en la habilidad individual de los usuarios, sino también en la organización. Las empresas están descubriendo que existen dos categorías de uso de la inteligencia artificial: la administrativa (resumir un informe, redactar un memo, generar código estándar) y la estratégica (implementar sistemas de agencia para automatizar funciones, reemplazar aplicaciones SaaS o transformar flujos de trabajo). Como decimos los profesores de innovación, la primera es puramente incremental, la segunda es disruptiva. Pero, por el momento, la segunda está fallando en la mayor parte de los casos.

¿Por qué fracasan el 95% de los pilotos?

El MIT ha publicado recientemente que el 95% de los pilotos corporativos de inteligencia artificial generativa fracasan. ¿La razón? Que la mayoría de las organizaciones evitan la fricción: buscan reemplazos inmediatos que funcionen a la perfección, sin tener que afrontar las complejas cuestiones de gobernanza, integración y control de datos. Este patrón es coherente con el conocido hype cycle de Gartner: un frenesí inicial de expectativas alocadas, seguido de desilusión a medida que la tecnología resulta más compleja, más desordenada y más política de lo prometido.

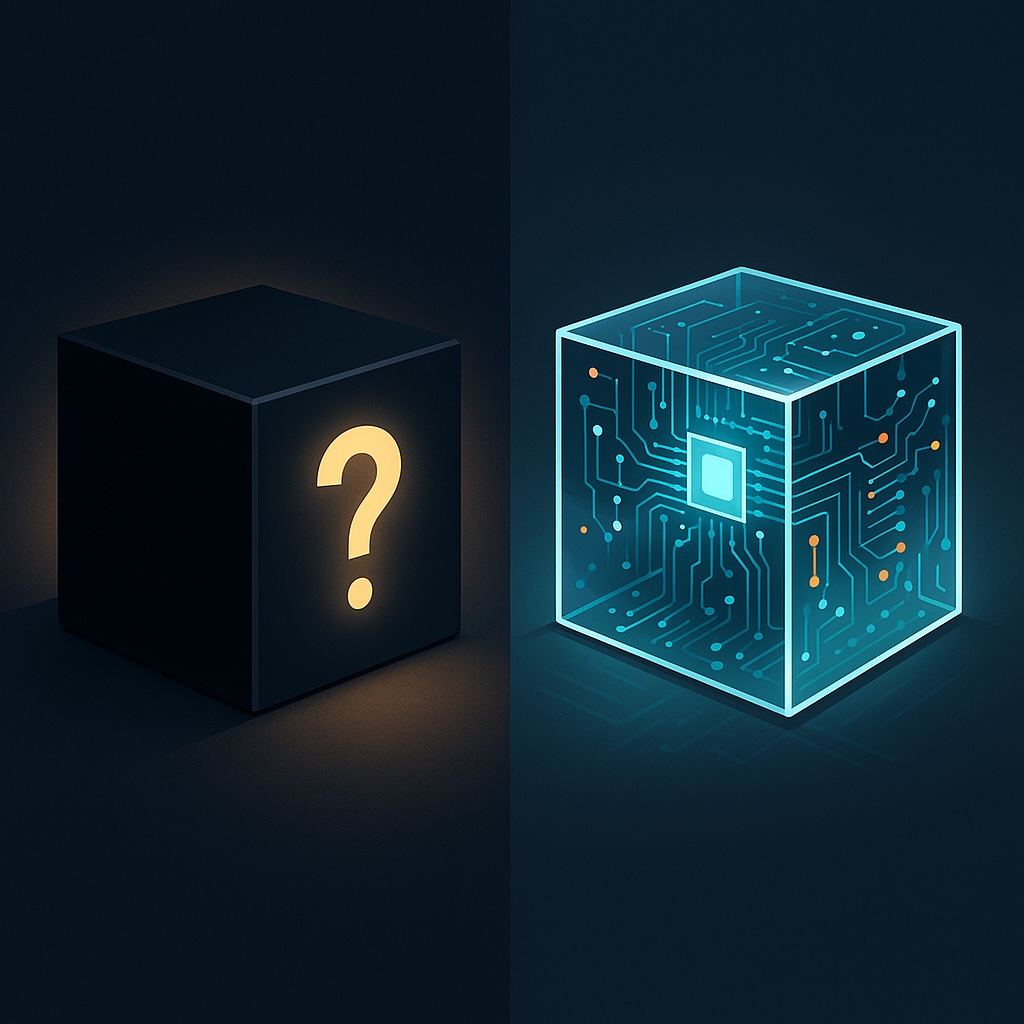

¿Por qué fracasan tantos proyectos? Porque los LLM de las grandes plataformas son cajas negras. Sus datos de entrenamiento y sus pesos son opacos, sus sesgos son inexplicables y sus resultados están cada vez más influenciados por incentivos ocultos. Ya hay empresas que anuncian «SEO para algoritmos generativos» (GEO), o incluso «Answer Engine Optimization« (AEO): optimizan el contenido no para la verdad, sino para manipular los criterios invisibles del resultado de un modelo. El resultado natural son alucinaciones y respuestas patrocinadas disfrazadas de objetividad. ¿Cómo sabremos si un LLM recomienda un producto porque es correcto o porque alguien pagó para que lo recomendaran? ¿Vamos a repetir los mismos errores y la misma basura que permitimos que surgiese en los motores de búsqueda?

Para las organizaciones, esa falta de transparencia es fatal. No se pueden construir procesos cruciales en sistemas cuyo razonamiento es incognoscible y cuyas respuestas pueden monetizarse sin divulgación.

Del «listo para usar» a «asistente personal»

La trayectoria para los usuarios expertos parece clara: están pasando de usar LLMs tal cual, a desarrollar asistentes personales: sistemas que conocen su contexto, recuerdan sus preferencias y se integran cada vez más con sus herramientas. Este cambio introduce un problema corporativo conocido como Shadow AI: los empleados traen sus propios modelos y agentes al lugar de trabajo, fuera del control del departamento de sistemas de información.

En uno de mis artículos recientes, «Trae tu propio algoritmo (BYOAI): una posible amenaza para tu empresa«, argumenté que la shadow AI es la nueva shadow IT. ¿Qué sucede cuando una posible incorporación brillante a la compañía insiste en trabajar con su propio modelo personal de inteligencia artificial, ajustado y optimizado para su flujo de trabajo? ¿Se lo prohíbes y te arriesgas a perder talento, o se lo integras en la compañía y te arriesgas a perder el control sobre lo que ese algoritmo puede hacer? ¿Y qué sucede cuando un empleado se va y pretende llevarse consigo a su agente personal, capacitado a lo largo del tiempo con los datos de su compañía? ¿Quién posee ese conocimiento?

La gobernanza corporativa se diseñó para software compartido y sistemas centralizados. No se diseñó para empleados que se mueven con «compañeros digitales» semiautónomos capacitados seguramente con datos propietarios.

SaaS bajo asedio

Al mismo tiempo, las empresas comienzan a vislumbrar el futuro: agentes que no solo se integrarán con el SaaS, sino que progresivamente lo reemplazan. Con los ERP, trabajamos para el software. Con los agentes, el software trabaja para nosotros.

Algunas empresas ya están tanteando el terreno. Salesforce se está reinventando a través de su plataforma Einstein, reposicionando eficazmente el CRM en torno a los flujos de trabajo agénticos. Klarna ha anunciado que eliminará las implementaciones de múltiples proveedores de SaaS y los reemplazará con agentes de inteligencia artificial. Puede que en su primer intento no tenga éxito (como de hecho predice el artículo del MIT), pero la dirección es inequívoca: los agentes se encaminan hacia una colisión con los modelos SaaS de suscripción.

La pregunta clave es si las empresas construirán estas plataformas sobre cajas negras que no pueden controlar o sobre sistemas abiertos y auditables. Porque cuanto más estratégico sea el caso de uso, mayor será el coste de la opacidad.

El código abierto como la verdadera respuesta

Por eso es importante el código abierto. Si tu futura plataforma corporativa es un sistema agéntico que automatiza flujos de trabajo, gestiona datos confidenciales y sustituye a tus aplicaciones SaaS, ¿puedes realmente permitirte externalizarlo a un sistema que es una caja negra que no puedes inspeccionar?

China ofrece un ejemplo ilustrativo. A pesar de tener restricciones para importar los chips más avanzados, las empresas chinas de inteligencia artificial, bajo presión gubernamental, han avanzado considerablemente hacia modelos de código abierto. Los resultados son sorprendentes: se están poniendo al día más rápido de lo que muchos esperaban, precisamente porque el ecosistema es transparente, colaborativo y auditable. El código abierto se ha convertido en su solución para las limitaciones del hardware, y también en su motor de progreso.

Para las empresas occidentales, la lección es clara: el código abierto no es solo una cuestión de filosofía. Se trata de soberanía, confianza y fiabilidad.

El camino a seguir

La inteligencia artificial generativa se está dividiendo en dos direcciones: para quienes no son especialmente sofisticados, seguirá siendo una herramienta de copiar y pegar: útil, incremental, rápida, pero poco transformadora. Para quienes sí tienen un uso sofisticado, se está convirtiendo en un asistente personal. Y para las organizaciones, potencialmente, en un sustituto completo del software de gestión tradicional.

Pero si las empresas quieren dar el salto de los usos administrativos a los estratégicos, deben abandonar la fantasía de que los LLM de tipo caja negra las llevarán hasta allí. No lo harán. El futuro de la inteligencia artificial corporativa pertenece a quienes realmente promueven la transparencia, la auditabilidad y la soberanía, lo que significa construir sobre código abierto, no sobre la opacidad propietaria.

Cualquier otra opción es simplemente alquilar inteligencia que no controlas, mientras tu competencia se dedica a crear agentes que trabajan para ellos, no para el modelo de negocio de un tercero.

This article was previously published on Fast Company, «What are the 2 categories of AI use and why do they matter?»

He de reconocer que en 2022 la presentación de GhatGPT fue un hype, pero desde entonces se va desinflando ese humo que rodea cada presentación…cada vez se ve más y mejor la asíntota de una AGI que no se abre de paso salvo en las mentes calenturientas de sus promotores. Sus alucinaciones siguen ahí, su coste exponencial en entrnamientos sigue ahí, su consumo desmedido de energía y agua cada vez es más elevado. En cuanto rascas un poquito y les pide una tarea relucen sus manchas…

¿2026 será el año de su adopción pseudo profesional? ¿veremos alguna película totalmente IA? ¿Veremos imágenes realmente impactantes?¿Interaccionarán sin irse por los cerros de Ubeda?¿Codificarán sin errores de acuerdo a las peticiones?

Redactar una idiotez de un memo lo hacen, muchas veces sin sentido

Resumirán de verdad teniendo lógica y sentido? porque resumir no es hacer algo que se parezca al original pero más corto…

Codificarán sin mezclar versuines, corregirán de verdad código de un repositorio, lo haran más eficaz, más seguro. Lo dudo mucho al día de hoy raro es que funcione a la primera.

Mucho benchmark para engañarse a si mismo, y escalar en los porcentajes, en base a hacer la trampa del overfitting.

Mientras la tecnología sea la del loro estocástico, dudo mucho que se abandonen los vicios nombrados. No se trata de una carrera para ver que tonto rápido escala más en esos benchmarks. Se trata de evolucionar de tecnología para que comprendan y entienden, en definiitiva de crear una Inteligencia Artificial, que no sea más que un nombre sin sentido.

Mientras eso no se consiga algunos ensalzaran de esta criatura mal parida sietemesina. Es lo que tiene el amor de padre que no atiende razones. Es como el del chiste que su niño es una gran oreja, y le advierte el médico «Pero grítele que es SORDO». Pero el padre como utiliza la IA a todas horas, sin criterio, como deciamos ayer, es un imbécil sobrevenido gritará eso de ¡¡Muera la inteligencia humana!!

Amen, hermano…

Discrepo. ChatGPT ha evolucionado muchísimo desde su presentación. Su capacidad para generar imágenes, para cambiar imágenes que le subes, para relacionar documentación que le subes y ordenarla, clasificarla, crear gráficas con ella, archivos en formatos de todo tipo, búsquedas en la web, bases de datos, hojas de cálculo… Por no hablar de sacar fotos y que reconozca en ellas lo que sea (desde plantas hasta tipos de baterías o enchufes, bombillas, guitarras… casi cualquier cosa), poder preguntar por ellas, alterarlas, hablar con él en viva voz por la calle

El listado de mejoras es impresionante, y muchos las notamos porque las empleamos. Y ha ocurrido todo en unos tres años nada más, mucho menos de lo que parecería posible cuando se presentó. Igual que es alucinante con qué normalidad lo estamos asimilando e incorporando en nuestro día a día

Quizá el problema es que no necesitas ese tipo de mejoras, pero para quienes las usamos en nuestro día a día se nota muchísimo, la evolución es brutal y en un tiempo récord

«Im presionante», que diría Jesulín

Tienes razón, para hacer muchas de ese tipo de cosas, tardo menos en hacerlo yo…

De hecho tengo un script que hace con el LLM local lo de los agentes al revés… es decir tengo un desplegable ejecuta los scripts que le he suminstrado antes (no alucina) y hace lo que yo quiero que haga, y el LLM recoge la salida… si es lo que quiero…

Por ejemplo resumir este blog, consultar una web.

Generar imágenes, las pruebas las haces mejor con LMarena, o directamente con Nano Banana, o en mi caso con el SD con las extensiones que hace todas esas cosas que no dependo de un sistema solo

Para consultar un PDF, lo puedo hacer con ChatGPT, NotebookLM, o mi sistema local basado en LMStudio, AnythingLLM o directamente en un RAG local que hice con Tkinter, y para ello me ayudó bastante Sonet, pero eso si lle tenía que atar corto…. programando con Langchain, ChromaDB, Ollama…

Así que si sé que son una escopeta de feria

Sigo?

Asi que TUMISMO

Maldito comunista… XDDD

Dejando aparte de que la inmensa mayoría de usuarios no quieren estar buscando qué IA es la mejor para hacer cada cosa (y que van muriendo y cambiando), ni tener que estar cambiando de IA pensando cuál es la que necesitan en cada momento, y que prefieren tener una con la que poder centralizar todas sus acciones, ocurre una cosa: no has desmentido lo que he dicho, que es que la realidad es que ChatGPT ha mejorado una barbaridad

Pero oye, allá cada cual con sus cosas. A lo mejor no te puedes centrar en lo que he escrito porque tienes la atención dispersa entre tantas cosas para poder ejecutar tus rutinas diarias. Tú mismo, chaval

Por cierto, ya hay que estar acomplejado para responder así a un comentario educado solo porque discrepe contigo. Necesitas trabajártelo, macho

¿acomplejado? No me hagas reir…. pedazo de usuario de IA

Ostias, sí que estás acomplejado para intentar eso, encima sin rebatir mi punto aún Qué cosa tan cutre de intento de ataque personal

TROLL !!!

Sigues en el ataque personal porque eres incapaz de debatir como un adulto civilizado. A cascarla, tío, que eres muy poquita cosa XD

TROLL

Pobre incapaz, con lo sencillo que sería responder a lo que he escrito. Ah, que te jode que es cierto. Pues macho, un adulto civilizado dice «tienes razón», y no se pone a insultar para disimular que está llorando por dentro

TROLL

He visto niños que entienden mejor el concepto de «debate adulto civilizado»

Macho, que tus papis hicieron un esfuerzo por ti, intenta estar a la altura

Para esto esta sirviendo la IAAAAA… XDDD

Agua del Ganges

Puede contener trazas de todo

…casi exploto…

(si hay enlace… mal… eh????) XDDD

Una declaración sobre la superinteligencia en tono «pasivo-agresivo» firmada por Steve Wozniak, Richard Branson, Mary Robinson y varios premios Turing, entre otros miles

Yo lo repite: Si son desastrosos para picar código en lo «micro» y los errores se acumulan con el «macro», ¿cómo voy a fiar mi empresa a estos procesos?

Cuando me vienen clientes pidiendo IA a gritos con 2-3 millones de € de presupuesto y le hago la pregunta: «¿Cuál es el margen de tolerancia de errores que estáis dispuestos a permitir?» suele ser extremadamente bajo o nulo. Y mira que lo mío es seguridad operativa de trabajadores, desarrollo de planes de acción, reportes de incidencias, etc. con un software específico.

Al ser procesos críticos (nadie quiere muertos, nadie quiere errores garrafales en los procesos, nadie quiere que nada se salte el procedimiento o flujo de procesos) pues… entonces los 2-3 millones desaparecen, pero al menos no he vendido «aceite de serpiente».

Que se lo gasten en otro y que el otro se lleve la mala reputación. No quiero dinero, quiero calidad. Y para eso, la IA está a años luz de sus promesas iniciales.

ONTOPIC: Solo un poco… técnico

Este post va para todos aquellos que les gusta cacharrear con LLMs… (a Javier)

He probado los 2 plugins de búsqueda y abrir webs de danielsig, me funcionan con texto pero no buscan imágnes dan un mensaje de forbidden, incluso actualizando los user-agents para que duckduckgo no se de cuenta… Mi workaround sería hacer un script con selenium, pero lo tengo en el SOMEDAY

También he visto por ahí que recomendaban el modelo Jan v1 4b (que es una copia de qwen 3 el razonador) pero me funciona mejor con qwen2.5 8B

Lo más novedoso que he visto en LMSTUDIO es el modelo gemma 3 12B ( me va bastante lento) pero consigue «ver» imágenes y hacer OCR… lo cual es curioso que lo pueda hacer en local. En la práctica con CHATGPT o el COPILOT de W11 va más rápido, y son más usables…

Por cierto haciendo OCR los LLM van bastante finos, nada que ver con FINEREADER u otro sistemas pre IA… Un caso de uso es cuando ves un código en una imagen o video, se lo enchufas y tienes el código en un plis plas sin errores

Para probar modelos de imágenes, lo mejor es lmarena.ai… que pruebas modelos free…

Pasamos a privado que lo del OCR me esta interesando para unos manuscritos y aun no me he puesto «en serio»…

Jan v1 4B lo tengo instalado pero pendiente de probar desde principios esta semana.

Tip para Lua: para OCR en local

• olmOCR-2-7B-1025

• DeepSeek-OCR

Ojalá el día tuviera más horas (o yo menos cosas de las que ocuparme) para aprender todo lo que va saliendo, que es una locura…

Te lo agradezco Javier. Probare que tal. A ver si este fin de semana saco algo en claro. No tengo mucho tiempo, o mejor dicho, me lo reservo mas para lo personal que para horas de pantalla… :*

Tengo que añadir, que no lo he dicho… se trata de manuscritos míos de cuando era joven (10-12 años) y mi caligrafía en esa época, no era precisamente de la escuela de Gutenberg… XDDD Me planteo si no me resultara mas practico, leer (y descifrar) que escribí entonces y trasladarlo a un Word, o entrenar un modelo para ello… XDDD

…las prisas…

Para imágenes, «lo solucioné» vía MCP (json) con la API de Pexels

Presenta resultados en formato de tabla con los links que redirigen al sitio en función del prompt. Funciona bien.

Otro con el que estuve cacharreando para navegar por la web es Tavily (idem MCP).

Lo configuré y lo probé una vez (funcionó bien) pero me debo más tiempo para hacer pruebas.

Gracias Javier… lo que dices, es muy absorbente en tiempo… pero es la única de manera de aprender…

«¿Cómo sabremos si un LLM recomienda un producto porque es correcto o porque alguien pagó para que lo recomendaran?»

Lo sabremos, igual que se sabe ahora, y nos dará exactamente lo mismo.

¿Vamos a repetir los mismos errores y la misma basura que permitimos que surgiese en los motores de búsqueda?»

No, no lo vamos a permitir. Lo que vamos a hacer es que se conviertan en algo todavía muchíííííísimo peor. Vaya, algo que, cuando se haga una historia de todo eso, será i-ne-na-rra-ble. ¿Apostamos?

«Vamos a repetir los mismos errores…» (EDans).

La naturaleza (sea lo que eso sea) trabaja reduciendo al mínimo los errores, aunque se base en el ensayo erro… y s eva abuscando meecaanismso didversos (ddiveresidad sexual…) paraa favarecer ele efeecto negatsaivod. emeetre la apata… nostros haacemso ala revés.

Porque tenemos un adn social negativo, injertado en nuestro cerebro (mente), por la sociedad adulta dominante, que nos impele a no ser eficientes y repetir errores, incluso haciéndolos más grandes (por ejemplo Trump)… así de mediocres somos….

Pero bueno, es solo una opinión.

Ah, eso sí también nos gusta la innovación resentida… por ejemplo, siliconar las ideas, para que sean lo menos cartesianas posible y puedan aburbujearse a toda pastilla.

Me falló la revisión, pero total… (le puedo echar la culpa a una IA y ya está).

O al orujo…. XDDD

Lua

Xaquin de PPaquita la culona ou Alberto non o parece pero tampouco é do BNG…

Xaquin

saia do armario profesor!

PS: Homenaxe á lingua da bolboreta

Quiero agradecerle por articular tan claramente por qué este trabajo importa. Existe una solución funcional para los problemas que describe. Si alguna vez tiene curiosidad por ver cómo se ve la gobernanza matemática de IA en producción (no en PPT), estaré encantado de mostrársela. Saludos

Yo creo que el futuro decidirá si Enrrique Dans tenía razón cuando dijo que «el código abierto decidirá el futuro de la inteligencia artificial corporativa».

Ojala que eso se cumpla, pero los cambios en IA van a resultar de lo más impredecibles, y las empresas que empiecen a trabajar con software libre, dejarán de compartir con la comunidad las partes más estratégicas.

Estas partes podrían convertirse en proyectos enormes, monstruosos por su peligrosidad social. A fin de cuentas las empresas no son ONGS.. Solo les interesa maximizar sus propios beneficios.