El reciente atropello de Elaine Herzberg por parte de un Volvo XC90 autónomo que formaba parte de la flota de Uber en Arizona es una desgracia que debería hacernos reflexionar sobre el concepto de responsabilidad en el desarrollo tecnológico.

El reciente atropello de Elaine Herzberg por parte de un Volvo XC90 autónomo que formaba parte de la flota de Uber en Arizona es una desgracia que debería hacernos reflexionar sobre el concepto de responsabilidad en el desarrollo tecnológico.

A falta de conclusiones definitivas de la investigación de la National Transportation Safety Board, todo parece indicar que la gestión del programa de conducción autónoma de Uber distó mucho de ser mínimamente responsable. Como bien analiza Brad Templeton en su página personal, las cosas pintan muy mal para la compañía. Nadie niega que la víctima estuviese cruzando indebidamente y de manera irresponsable por un lugar mal iluminado y no señalizado, pero a medida que más expertos analizan las abundantes pruebas documentales – no olvidemos que hablamos de un vehículo completamente sensorizado – más parece cundir la idea de que el vehículo de Uber no protegió al peatón de la manera mínimamente esperable, y que la compañía estaba, de manera deliberada, acelerando las pruebas por encima de sus posibilidades con el fin de recortar el tiempo necesario para lanzar un servicio comercial de transporte de vehículos sin conductor.

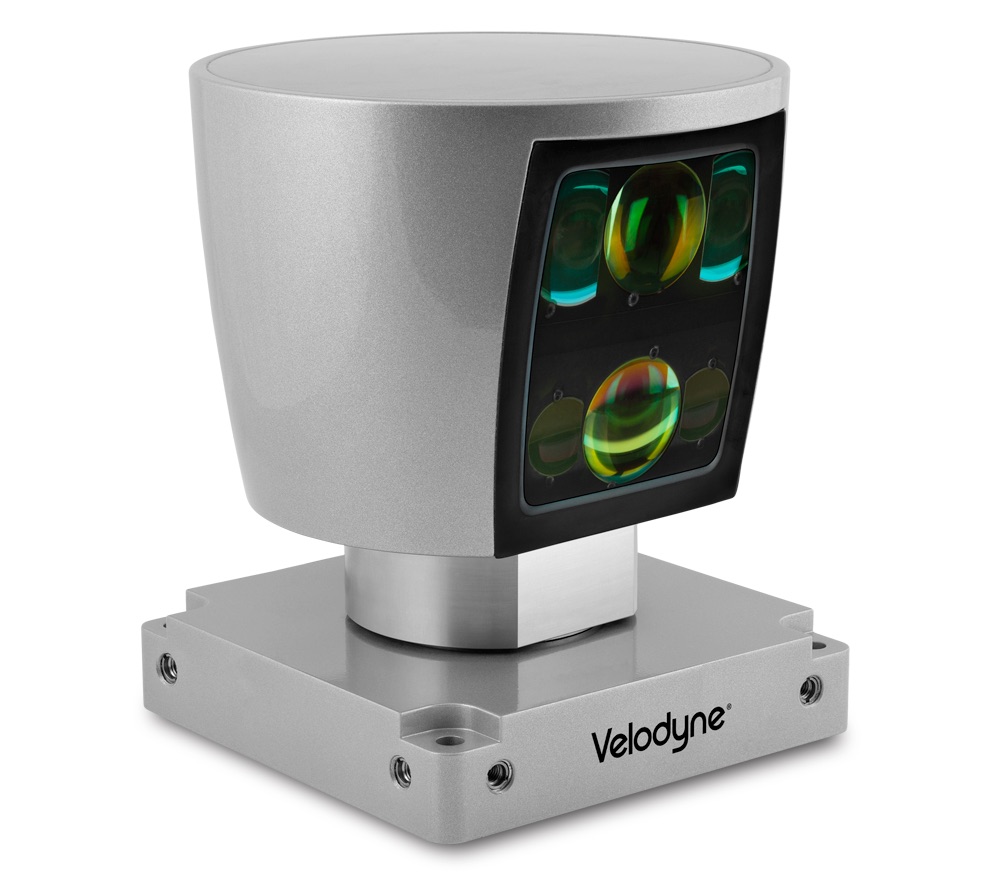

Las primeras sospechas surgen en torno a la falta de una reacción del vehículo, que no llegó a activar sus frenos. El fabricante del radar de láser pulsado (LiDAR) del vehículo, Velodyne LiDAR, una compañía independizada de su matriz, Velodyne, en 2016, participa en más de veinticinco programas de desarrollo de conducción autónoma con compañías como Volvo, Ford, Mercedes-Benz, Tencent, DJI, Baidu, TomTom, Here, Bing o SAIC, se ha mostrado completamente sorprendida por los datos del accidente que han trascendido hasta el momento, y ha situado la responsabilidad no en sus componentes, sino en algún otro punto. En un correo electrónico, Martha Thoma Hall, presidente y Chief Business Development Officer, se ha defendido afirmando que

We are as baffled as anyone else (…) Certainly, our LiDAR is capable of clearly imaging Elaine and her bicycle in this situation. However, our LiDAR doesn’t make the decision to put on the brakes or get out of her way (…) it is up to the rest of the system to interpret and use the data to make decisions. We do not know how the Uber system of decision-making works.

(Estamos tan desconcertados como cualquiera (…) En efecto, nuestro LiDAR es capaz de obtener imágenes claras de Elaine y de su bicicleta en una situación así. Sin embargo, nuestro LiDAR no toma la decisión de frenar o de salirse de su camino (…) corresponde al resto del sistema interpretar y utilizar los datos para tomar decisiones. No sabemos cómo funciona el sistema de Uber para la toma de esas decisiones.)

Los datos disponibles sobre el programa de conducción autónoma de Uber palidecen cuando se comparan con las cifras obtenidas por compañías como Waymo, por varios órdenes de magnitud. En noviembre de 2017, por ejemplo, los vehículos de Waymo eran ya capaces de recorrer casi 50,000 kilómetros sin ningún tipo de intervención humana. Los de Cruise (compañía adquirida por GM en 2016) declaraban, en octubre del mismo año, haber reducido esas intervenciones a tan solo tres en casi 45,000 kilómetros. En el caso de Uber, sus conductores de seguridad necesitaban tomar los mandos del vehículo en torno a una vez cada veinte kilómetros, una cifra comparativamente tan baja que posiblemente justificaría que sus vehículos estuviesen aún en fase de pruebas en circuito, no en tráfico real. En marzo de 2017, el número de intervenciones del conductor en vehículos de Uber era de una cada aproximadamente 1.3 kilómetros. ¿Qué dice Uber al respecto? Simplemente, que la métrica del número de intervenciones por distancia recorrida no es un buen indicador para valorar la seguridad de un vehículo autónomo. En efecto, es posible que una métrica no recoja la totalidad de la información… pero sí es significativo que esa métrica en concreto sea una basura.

La presencia de un conductor de seguridad, por otro lado, debería marcar la diferencia: todas las compañías parecen utilizar como conductores de seguridad a conductores normales que simplemente han pasado un determinado período de instrucción, con cursos de capacitación que suelen extenderse durante tres semanas, y que incluyen una prueba de conducción manual, una evaluación escrita, capacitación en el aula y en carretera, y en los que se valoran, por ejemplo, cuestiones como el tiempo de reacción, la experiencia militar, la experiencia como conductor de reparto, la capacidad para teclear más de cincuenta palabras por minuto, o para llevar a cabo revisiones básicas del vehículo. Un conductor de seguridad suele cobrar en torno a $23 por hora en Cruise o $20 en Waymo, un dato que se desconoce en el caso de Uber. La compañía utiliza unos cuatrocientos de esos conductores en los doscientos vehículos que tiene en sus flotas en Pittsburgh, Phoenix, Toronto, Tempe y San Francisco. En el caso de Rafaela Vasquez, la conductora implicada en el accidente, el hecho de que fuese una ex-convicta por delitos como robo y falsificación documental por los que cumplió condena durante cuarto años ha hecho que algunos apunten a una falta de responsabilidad de la compañía, aunque en realidad, el delito había sido cometido en el 2000, mantenía antecedentes limpios desde entonces, y además, la compañía mantiene una política de segundas oportunidades y únicamente excluye a quienes tienen delitos en los siete años anteriores.

¿Qué lleva a Uber a tratar de acelerar el desarrollo de la tecnología de conducción autónoma por encima de sus posibilidades? En primer lugar, la fuerte dependencia de la astronómica valoración de la compañía del hecho de que sea capaz de eliminar el principal componente del coste de operación de sus vehículos, el conductor. En segundo lugar, los recientes cambios en su dirección: todo indica que Dara Khosrowshahi, el CEO que sucedió al polémico fundador, Travis Kalanick, se inclinaba a su llegada a la compañía por la posibilidad de cancelar el programa de conducción autónoma, pero fue convencido por otros directivos para continuar con él, dada su gran importancia para el futuro de la compañía y el peso que podría tener en su valoración. El nuevo CEO tenía anunciada una visita a Arizona el próximo abril, y los responsables del programa pretendían ofrecerle una experiencia de conducción autónoma sin ningún tipo de incidentes y con pruebas en situaciones excepcionales (los llamados edge cases, que el propio Khosrowshahi había señalado como el auténtico reto) a bordo de uno de sus vehículos, lo que podría haber sido un factor importante a la hora de precipitar las pruebas. La compañía comenzó a privilegiar la acumulación de más millas frente a las pruebas con pasajeros, cambió la consideración de los conductores de seguridad, y fusionó a los encargados de pruebas de conducción en circunstancias complejas con los encargados de transportar pasajeros, al tiempo que redujo la dotación de los vehículos de dos conductores a uno. Así, la compañía fue capaz de pasar desde el primer millón de millas recorridas durante el año que terminó en septiembre de 2017, a conseguir el segundo millón en tan solo cien días, y a apuntar hacia el tercer millón en un plazo aún menor, tratando de dotar a sus algoritmos de más datos para su aprendizaje. Otras compañías, como Waymo, parecen haber sido mucho mas rigurosas a la hora de entrenar estos algoritmos en situaciones que no conllevasen peligro para las personas, como revela el uso de entornos de videojuegos para generar experiencias de este tipo. Según el CEO de Waymo, John Krafcik, sus vehículos habrían sido perfectamente capaces de gestionar satisfactoriamente una situación así.

¿Fue irresponsable la gestión del programa de conducción autónoma de Uber? Tratar de especular y extraer conclusiones antes de que termine la investigación de la NTSB es no solo temerario, sino innecesario: en el caso de un vehículo autónomo, no van a faltar datos que permitan analizar de manera fehaciente qué ocurrió, por qué, y a quién corresponde la responsabilidad. Pero a la hora de juzgar este tipo de temas, conviene separar el desarrollo de la tecnología como tal, de la gestión del mismo a la hora de ponerla en el mercado por parte de compañías que puedan actuar de manera potencialmente irresponsable. Pocos dudan de que la conducción autónoma es el futuro: cada vez son más los países en los que se autorizan pruebas de conducción autónoma, y las compañías responsables que demuestran que esas pruebas pueden llevarse a cabo en condiciones adecuadas de seguridad. Lo importante, a estas alturas, es evitar que paguen justos por pecadores, y que una tecnología con un potencial enorme a la hora de reducir accidentes, de proporcionar movilidad de manera ubicua o de mejorar el tráfico en las ciudades pueda seguir progresando adecuadamente. La forma de salvar vidas no es dificultando el progreso de esta tecnología, sino posibilitándolo, dentro de los lógicos límites de responsabilidad. Como en tantas otras ocasiones, el peligro no está en la tecnología, sino en la manera en que se utiliza.

ACTUALIZACIÓN (27/03): el gobernador del Estado de Arizona, el republicano Doug Ducey, envía una carta al CEO de Uber suspendiendo sus permisos para hacer pruebas con vehículos autónomos en Arizona, a la luz del accidente de Elaine Herzberg. Mientras, Velodyne LiDAR demuestra, utilizando el vídeo del accidente, que sus equipos sí habrían sido capaces de detectar a Elaine, y que el fallo se encuentra, por tanto, en otro punto. La investigación demostrará si el software de Uber era defectuoso, si el LiDAR u otros sistemas se encontraban desconectados en el momento del accidente, o si pudo haber algún otro tipo de descuido o negligencia por parte de la compañía.

ACTUALIZACIÓN (28/03): Marimar Jiménez cita esta entrada en Cinco Días, «Arizona pone en aprietos el coche autónomo de Uber al suspender sus operaciones» (pdf).

This post is also available in English in my Medium page, “Self-driving cars: accidents, safety measures, and responsibility»

Indudablemente las acciones por 100000 Km andados es un indice importante, …. siempre que las condiciones de trñafico sean comparables, cosa que dudo que ocurra en la desértica Foenix y en la populosa San Francisco, Utilizar este único dato para descalificar por las buenas a UBER me parece como poco temerario.

Tampoco lo debería ser el dato de utilizar ex convictos de robo como chóferes. No creo que tenga nada que ver el tiempo pasado en la cárcel con su habilidad al volante.

Lo que es cierto es que se están tratando de qumar etapas para poner ¡a punto el el vehículo autónomo y esto es una carrera en la que participan todos, los que llevan tiempo en el proceso y los invitados de última hora como parace que es UBER, y que posible estos últimos quizá meten a un mas presión en sus ensayos.

Quizá a quien corresponda, debiera sentar a la mesa de negociaciones a todos los implicados y establecer conjuntamente unos planes de pruebas más tranquilos y con menos riesgo para la población que nada tiene que ver con el experimento.

Por ejemplo los medicamentos, tiene planes rigurosos de pruebas, tanto en laboratorio, como con animales experimentales y posteriormente. aun se hacen pruebas con voluntarios y solámente después, con pacientes y aun así ocurren casos como el de la Talidomida.. Quizá fuera conveniente en este asunto. adaptar al caso la normativas de los medicamentos.

Seguro que en USA hay alguna ciudad abandobada, o una a urbanización fracasada. que convenientemente pertrechada de semáforos y otros atrezzos, podía valer para laboratorio de pruebas en calles reales, donde todos los coches autonomos recorrieran esas calles simulando todo tipo de imprevistos, coches suicidas contradirección, mujeres alocadas que cruzan sin mirar, coche que frena porque ha visto un aparcamiento, lluvias torrenciales, repartidores en bicicleta que se saltan semáforos, taxistas que giran en 180 grados, ancianos que circulan a 40K/H por autopistas, pèrsonas que abren de repente la puerta del conductor etc…

La inclusión de un piloto de reserva, se ha demostrado que es absolutamente inutil, basta ver el video con la cara de la conductora y su reacción cuando descubrió a la victima.,

Me ha gustado descubrir en este tema que se han ido avanzando datos acerca de esclarecimiento de lo que sucedió y que por ejemplo no hay explicación posible al hecho de que no hubiera respuesta del vehículo (ni frenada ni volantazo).

Una de las cosas que me llamó la atención del tema anterior que tuvo tantos comentarios es que se hablara tanto de la señora que falleció en el atropello y de su responsabilidad. Llevo nueve años en NY y una cosa que te llama la atención si eres una persona observadora en esta ciudad no es que un ciclista se salte un semáforo en rojo -lo raro es ver uno parado esperando a que se ponga en verde-, sino que lo más peculiar es ver a ciclistas circulando en las grandes avenidas de Manhattan en sentido contrario a la circulación de los coches e incluso sorteándolos -repito, EN SENTIDO CONTRARIO- como si se tratara de un videojuego.

Y sin dejar el ámbito de lo muy probable que se puede encontrar cualquier vehículo sin conductor cuando sean frecuentes en Estados Unidos están toda clase de animales: desde racoons (mapaches), lobos, osos, ciervos, coyotes o venados… Y no hablo de Alaska, los mapaches se pueden ver sin problemas en el mismo Manhattan e incluso hay coyotes en Queens cerca de el Aeropuerto de Laguardia. ¿A quién le van a pedir responsabilidad si uno de estos pobres animales provoca sin querer un accidente y fallece un viajero de un vehículo autónomo?

La tecnología deberá estar lo suficiente madura para resolver toda clase de situaciones. Y para ello es muy importante seguir la regla de la esquina/curva: si un vehículo no ve lo que hay al otro lado de la curva debería tener la posibilidad de detenerse en la distancia que es capaz de «ver».

Termino con un ejemplo de esto que he mencionado: hace muchos años, en una carretera general de Álava iba yo conduciendo bastante prudentemente (70-90 kms/h) cuando en una curva en la que la gente puede tomar a 100 e incluso 120 o 130 kms/h me encontré con un camión completamente parado y con los cuatro intermitentes. Como yo iba despacio, pude detenerme e incluso poner yo los cuatro intermitentes a la entrada de la curva para avisar a otros conductores. Poco tiempo después el camión se pudo desplazar, paró en el arcén y yo seguí mi camino. Si yo hubiera sido uno de esos locos que van a 120 o 130 en esa curva me hubiera comido el camión o hubiera tenido que dar un volantazo que pudo ser mortal si viene alguien de frente.

De ese tipo de situaciones me he encontrado miles en mi vida y por eso creo que si los vehículos van a la velocidad en la que puedan pararse en la distancia que «ven» se evitarían muchos accidentes, también el de esta señora que murió atropellada.

Uber es una compañía que siempre se ha carecterizado por sus malos modos y no me gusta. Lo mejor para todos sería su completa desaparición.

Es clara la temeridad de la fallecida, pero también me da la sensación de que el pasajero de seguridad andaba por los cerros de Úbeda por no decir otra cosa.

También creo que un conductor humano con algo tan simple como llevar puestas las luces largas habría visto de lejos las intenciones de la fallecida y habría actuado en consecuencia sin mayor dificultad.

Sencillamente creo que Uber la ha cagado pero bien. Espero que otras compañías que si tienen mucha mejor reputación dispongan de algo mejor.

Respecto al accidente en sí, volver a indicar que el hecho de que el coche no frenara a tiempo no implica necesariamente que el Lidar no funcionara. Están involucrados al menos los siguientes factores: los sensores, lo cables que llevan la información de los sensores a las CPUs, el hardware de las CPUs (redundantes), el firmware, el software, el tiempo de cálculo, los cables que llevan la instrucción de frenar al sistema de frenado, el líquido de frenos, las pastillas de freno, la goma del neumático y el propio asfalto.

Para ilustrar por qué ni siquiera un video es suficiente para obtener conclusiones definitivas, veamos un ejemplo famoso histórico: la desintegración del transbordador espacial Columbia el 1 de febrero de 2003 en su reentrada a la atmósfera terrestre. Pronto se descubrió por las cámaras de vídeo exteriores que a los 82 segundos del despegue un trozo de «algo» se desprendió y golpeó el ala izquierda. La pregunta era si esa pieza podría haber dañado el fuselaje abriendo un agujero. La primera respuesta intuitiva sería «pues claro». Pero resultó que ese «algo» era espuma aislante, que tiene muy poca masa. Así que hubo ingenieros que pensaban que no. Para salir de dudas, el investigador jefe encargó modelos matemáticos de simulación que indicaban que sí, pero seguía habiendo dudas. Finalmente encargó construir un dispositivo en tierra que usaba aire comprimido para lanzar trozos de espuma de ese tamaño a la velocidad similar a la del momento del impacto (500 millas/h) contra un fuselaje similar al de la aeronave, demostrando no solo que dañaba el fuselaje sino que abría un buen boquete (por donde se colaron los gases calientes en la reentrada):

STS-107 Columbia Debris Strike and Foam Strike Tests

En investigación de accidentes de este tipo se procede con ese rigor, reproduciendo el problema a partir de los datos conocidos. Se pone a un piloto en un simulador de vuelo para que repita la maniobra que realizó el piloto real y obtenga el mismo resultado catastrófico. También se simula la maniobra correcta que hubiera evitado el desastre para incorporarla a la formación de los pilotos actuales de todas las compañías (algo que en la conducción autónoma se podrá conseguir pero en la conducción humana no).

En el caso del accidente de Uber, lo normal es que se reproduzca el accidente en un simulador y posiblemente en la misma carretera con una bici y un maniquí en las mismas condiciones de oscuridad. Todo esto llevará algunas semanas/meses.

Al margen de eso, efectivamente las compañías tienen una responsabilidad en la seguridad aunque la causa principal de un accidente no haya sido suya. En aviación, por continuar con el paralelismo, si se demuestra que sus aviones o sus procedimientos operativos no son seguros, pueden perder la licencia de operar (en los países serios):

The EU Air Safety List

Puede que Uber inaugure la lista de compañías NO autorizadas a realizar pruebas de conducción autónoma, pero, a día de hoy, toca esperar.

El gobernador de Arizona Doug Ducey ha suspendido el permiso de pruebas a Uber. La noticia con la carta del gobernador a Uber:

https://www.cbsnews.com/news/arizona-governor-doug-ducey-suspends-uber-autonomous-testing-letter-today-2018-03-26/

Creo que esto es lo mejor que podía pasar. Aunque el gobernador no lo menciona en su carta, los resultados obtenidos por Uber (esos 20 Km entre intervenciones) eran muy pobres y la actitud y prácticas de Uber en la conducción autónoma que han sido publicadas eran como poco preocupantes.

Dejando un poco de lado el atropello reciente, ya se verá quién tuvo la culpa de ese accidente, y yo no descartaría a priori al coche autónomo antes de la investigación, la responsabilidad ante cualquier reclamación en este tipo de situaciones creo que debería recaer absolutamente en UBER, GOOGLE, WAYMO o cualquier otra empresa que tome la decisión de utilizar sus coches para experimentar con tráfico real poniendo en peligro al resto de usuarios de la vía. Yo extendería esa responsabilidad a los dirigentes políticos que permiten que esto ocurra (los famosos paniaguados de la conspiración judeo-masonica ;) ).

El ejemplo es el de siempre: el de un cuchillo. Si yo te apuñalo, ¿quién tiene la culpa?, ¿el que diseña el cuchillo?, ¿el que lo fabrica?, ¿el que lo vende?, ¿el que lo compra?. No, la culpa es de la persona que lo utiliza, en este ejemplo yo, para cometer un delito.

En caso de que determinen que el coche autónomo tuvo algún tipo de culpa en el accidente lo lógico es que vayan a por UBER. Luego ya dependerá de los contratos que tengan firmados entre ellos: UBER, VOLVO y el resto de empresas implicadas. No creo que en UBER (porque estamos hablando de ellos) tengan la cara dura de escudarse en el conductor auxiliar para descargar responsabilidades. Sería de traca. Desarrollas un coche sin conductor y cuando hay problemas la culpa es del conductor. Bueno, tampoco sería tan raro, si no que se lo pregunten al maquinista del AVE que descarriló en Angrois.

Cambiando de tercio, esto de coger cifras al aire, cuando son facilitadas por una parte interesada, es como recibir encuestas cocinadas por partidos políticos. Hay que cogerlas todas con pinzas. Uno suelta 45.000 Km de pruebas realizadas, otro 50.000 km, etc, sin decir ni dónde, ni cómo, ni cuándo, como el bolero. No es lo mismo una prueba en un circuito cerrado, que en una vía secundaria sin apenas tráfico o en una calle urbana con tráfico intenso. Son solo datos que no demuestran nada.

Para terminar, vuelvo a repetir que, en mi humilde opinión, la tecnología actual no es lo suficientemente madura para alcanzar la meta que se proponen: conseguir un máquina o sistema que sustituya las habilidades físicas y cognitivas de un ser humano aplicadas a un vehículo de transporte. Ojalá den con la tecla y lo consigan. Los coches del futuro heredarán la mayoría de esos avances, aunque no nos podamos permitir comprar un vehículo totalmente autónomo.

El día que lo logren y lo combinen con tecnologías contrastadas que superan la competencia humana, el coche realmente autónomo (100% fiable) será una realidad. Hasta que esto suceda son todo hipótesis y quimeras. Yo no me atrevería a afirmar con rotundidad que se reducirían los accidentes, o que mejoraría el tráfico y la movilidad. Está por ver.

El tráfico en la vida real es algo más complicado que una explanada dentro de un almacén de logística acotado y mapeado con miles de robots circulando milimétricamente por encima de lineas imaginarias. Suelto a mi sobrina y a mi perro en medio del almacén y en media hora jugando se cargan todo el sistema.

Simplemente indicar que ni el coche autónomo, ni ninguna otra tecnología de transporte, va a ser 100% fiable nunca en campo real, fuera del laboratorio, y van a ocurrir accidentes.

La tecnología de transporte estadísticamente más segura que tenemos hoy en día es la aviación, y es interesante ver con qué nivel de (in)seguridad arrancó comercialmente en la década de 1950’s: por aquel entonces, aparte de los accidentes que involucraban a un solo avión, no eran infrecuentes las colisiones y casi-colisiones de dos aviones en el aire. Este tipo de accidente, a día de hoy, es casi imposible, pero no inaudito. En un caso doblemente famoso en 2002 colisionaron dos aviones en el cielo alemán:

2002 Überlingen mid-air collision

Fue doblemente famoso porque se culpó al controlador de tráfico aéreo y un año y medio después el padre de 3 víctimas se presentó en su casa y lo mató a puñaladas.

El caso es que en los 1950s, cada vez ocurría con más frecuencia, al volar cada vez más aviones. Pero como eran pequeños «solo» morían unas decenas de personas en cada accidente, menos de 100. Tuvo que ocurrir otro accidente famoso sobre el Gran Cañón:

1956 Grand Canyon mid-air collision

con más de 100 víctimas (128) para que sirviera de catalizador para mejorar la seguridad solventando las dos causas raíz de aquellos accidentes: la ausencia de radares (por entonces solo para uso militar) y la ausencia de una autoridad única de control de tráfico aéreo.

Un nivel de falta de seguridad así hoy se consideraría inaceptable en el despliegue comercial del coche autónomo, cuando ya se conocen muy bien los niveles de redundancia que garantizan una seguridad excelente.

Ciertamente debemos considerar inaceptables comportamientos negligentes en los procedimientos de las compañías y conductores de seguridad (si es que no hay que poner en cuestión la existencia de estos últimos).

Pero si vamos a pedir fiabilidad del 100%, eso no va a ser posible nunca. Lo que hay que pedir es que sea estadísticamente más fiable que lo que existe, para que salve vidas, esperando los años que hagan falta sin precipitarse.

Mi sensación es que para Uber el fin justifica los medios.

Uber no es la NASA, ni la General Motors, ni Toyota, ni tampoco es Google. Solo se trata de una App de intermediación de éxito que ha captado mucho dinero de inversores y que no sabe muy bien que hacer con él. Y que, para peor, son muy lanzados, y se han metido en un tema que les va grande.

Robaron tecnología a Google para conseguirlo. Y, posiblemente, Google se equivocó al llegar luego a un acuerdo con ellos después de ponerles una demanda.

Lo ocurrido no solo afecta a Uber. También cuestiona de raíz al coche autónomo como concepto, dando la imagen de que la tecnología no está lista, madura para ser usada en las calles.

La gente tampoco es tan tonta, pero se sigue hablando de la oscuridad como si fuera un factor (supuestamente determinante en el accidente) que afecta a los coches autónomos, como si tuvieran ojos humanos que no pueden detectar los objetos cercanos en condiciones de baja luminosidad…

Lógicamente, si los coches autónomos no pueden hacerlo bien en la oscuridad deberán limitarse a circular durante el día. Este es el mensaje implícito y que resulta absurdo.

Para peor, al llegar a un acuerdo con ellos, Google, sin pretenderlo, les ha legitimado, pues ha terminado siendo accionista de Uber…

El acuerdo entre Uber y Google tras el robo de su tecnología

Es decir, que deberíamos prohibir que los humanos condujeran por la noche, ¿no? Si por esa muerte el coche autónomo es cuestionado de raíz, igualmente cuestionados de raíz resultan todos los conductores humanos, dado que ninguno habría podido evitar el atropello.

Eso sin mencionar que hay una «pequeña» diferencia entre los 20 Km que te hace un coche de Uber sin que intervenga el conductor de seguridad, y los casi 50.000 que te hace uno de Google. Además del hecho de que los coches de Google llevan ya 4 meses circulando por Phoenix sin conductor de seguridad, sin el más mínimo accidente.

No Krigan, lo de prohibir conducir a los humanos de día o de noche no lo digo yo…

Ya se prohibirá la conducción humana, más adelante, justamente para evitar cualquier accidente. Los coches autónomos lo harán de manera casi casi perfecta. Se salvarán cada año muchísimas vidas. Sobre todo en el tercer mundo.

Pero tú, Krigan aquí no eres el abogado defensor de la conducción autónoma sino el de Uber.

En mi modesta opinión, Uber no es el mejor modelo a seguir. Y se trata un tema bastante importante.

Ha muerto en un accidente una mujer sin techo, no es nuestra madre, ni esposa, ni hermana, pero podría serlo. Quizás, el accidente fue inevitable, algo que dudo después de mirar varias veces la grabación en vídeo, pero así y todo el fin no justifica los medios. Y Uber, no me parece que tenga la mejor trayectoria o el mejor currículum para lanzarse a fabricar coches autónomos.

Bueno, si de mi anterior mensaje, y del otro que he puesto aquí, tú deduces que estoy defendiendo a Uber, pues tú mismo.

En cuanto a tu otra chorrada, más les vale a los que estén pensando en comprarse un BMW con una de esas cámaras de infrarrojos que tanto te molan que se lo piensen 2 veces. En el mismo momento en que ya tienes «visión nocturna» (aunque sea una pantalla pequeña y de baja resolución), si te aparece una peatona temeraria así en la oscuridad, como la mates ya la has cagado.

Seguro que es la madre, esposa, hermana o hija (se te olvidó la hija) de alguien, lo cual significa que no importa lo que diga la investigación, tenías «visión nocturna», y eso significa que eres culpable como el demonio. Lo que haya aparecido en esa pantalla da lo mismo (¿acaso sabemos lo que apareció en el lídar?), ya estarás sentenciado sin juicio.

Krigan, ni te gustaría que te dijese que dices «chorradas»…

No digo «chorradas» y espero que tu tampoco las digas. Pero esto lo lee mucha gente, negro sobre blanco.

De este tema, que tampoco está agotado, hemos debatido en entradas anteriores y recientes; allí hay opiniones y enlaces a artículos que merece la pena leer.

JJ:

Lo que no me gusta, y no es la primera vez que pasa, es que digas que yo defiendo a Uber. Uber me importa un carajo. Ni siquiera tengo buena opinión de ella, y en el tema de la conducción autónoma todavía menos.

Entonces, Krigan, estamos de acuerdo.

Yo estoy interesado y defiendo en principio la conducción autónoma pero no me gusta demasiado Uber. Un poco por la fama que le precede, otro poco por haber robado know how, etc. y porque no los veo muy preparados para un tema que tiene su complejidad.

Tampoco me gustan las teorías que sugieren que la víctima se suicidó para cobrar un seguro (con su bicicleta). No me las creo. Y dudo que llegase a creerlas aunque apareciese una póliza con su firma.

JJ:

Sí, lo del suicidio parece bastante improbable.

Desde luego, lo publicado por el New York Times, basado en documentos internos de Uber, es bastante preocupante. Al margen de lo que pasase en este accidente concreto, que ya lo dirán las investigaciones (hay más de una abierta), cabe preguntarse si no hemos tenido la suerte de que este accidente (causado por la peatona y que un conductor humano no habría podido evitar) haya causado la paralización de la flota de pruebas de Uber.

Lo que describe el New York Times casi parece una peli de terror. Repito el enlace para más comodidad:

https://www.nytimes.com/2018/03/23/technology/uber-self-driving-cars-arizona.html

bueno, cada 50 mil km se llevan a alguien por delante, estaremos atentos al kilometraje. :-)

Desde luego, la cifra de Uber de solo 20 míseros Km de promedio entre intervenciones del conductor de seguridad la deja fuera de cualquier posibilidad seria de que llegue a poder prestar servicio de robotaxis usando su propia tecnología. Está a demasiados años de distancia de poder hacerlo, así que mejor si empieza a pensar en licenciar la tecnología de otros.

Contrariamente a lo que afirma Uber, esa cifra es la cifra. Vale, puede depender de diversas condiciones. Pero si vas a prestar servicio de robotaxis en el área de Phoenix, aunque solo lo prestes de día y solo cuando hace sol, entonces vas a necesitar que tu promedio en Phoenix, de día y con sol, se mida en miles de Km, no en decenas. No digamos ya si además vas a dar servicio de noche y con lluvia.

El contraste con Google y Cruise es brutal. Cruise está a cosa de 2 años por detrás de Google, y aún así le lleva varios años de ventaja a Uber. De hecho, la cifra de Uber es tan pobre que debe haber más de una docena de empresas que van claramente por delante de ella. Año y medio después de iniciar sus pruebas en Pittsburgh, Uber no es más que un colista.

Y además está el accidente. Dado que no sabemos qué hizo o dejó de hacer la peatona antes de empezar a ser visible en el vídeo, sería prematuro atribuirle alguna responsabilidad a Uber. Pero el caso es que mientras se completan las investigaciones (que tardarán meses) la flota de coches de prueba de Uber permanece parada. Y como acabe siendo cierta la suposición de la mayoría, que la peatona no llegó a detenerse en el carril anterior al del accidente, Uber va a tener un problema bien gordo.

Afortunadamente, este accidente no va a impedir que Google empiece a prestar servicio de robotaxis este año. Digo «afortunadamente» porque la conducción autónoma salva vidas. No, un conductor humano no hubiera podido poner las largas. Al igual que en España, en Arizona está prohibido ponerlas en poblado:

«Use low beams [luces cortas] when driving on city or town streets.»

https://www.azdot.gov/docs/default-source/mvd-forms-pubs/99-0117.pdf

Sin luces largas, el humano mata irremediablemente a la peatona imprudente. Todo el debate acerca de si el coche autónomo de Uber funcionó mal se basa precisamente en el hecho de que un coche autónomo, con su lídar, sí debería haber evitado el choque.

Y esto en un caso en el que la culpa fue del peatón, con un coche en pruebas, y de una compañía que es colista en esto de la conducción autónoma.

Oportunidad de oro para Google de destruir a uber, que dejen calmarse las aguas y después a arrasar con el presuntamente más avanzado waymo, tan solo han de copiarles una app.

Modo especulative ON:

Viendo las imágenes, podría parecer que la señora de la bicicleta se “echó encima” del vehículo de Über para suicidarse o quedar muy malherida. Los vehículos de Über parecen ser muy visibles como para que alguien no los detecte a mucha distancia, y más por la noche, con toda esa parafernalia de lídar giratorio, faros, luces y demás.

La malograda señora iría con su bicicleta buscando un lugar de mala visibilidad y quedaría a la espera de cruzar cuando se acercase un coche de Über y que no la detectara.

El objeto sería cobrar algún tipo de seguro para su prole… Y sabría que morir a manos de una empresa que está en el candelero a nivel mundial, podría reportar pingües beneficios a su descendencia.

Pero vamos, que es MUY especulativo. Las investigaciones serán exhaustivas para esclarecer en profundidad lo que pudo pasar. Y si la historia lo merece, habrá película.

Modo especulative OFF:

No quería poner este mensaje, pero el modo de aparecer desde la práctica oscuridad me ha hecho dudar.

Los sistemas automáticos de Über deberían ser suficientes para haber evitado todo esto, pero la señora atropellada no tenía por qué saberlo, o estaba tan desesperada que lo hizo a pesar de todo, conociendo lo débil (en intervenciones del piloto cada equis km) del histórico de esta compañía.

Te he contestado en el #13

La investigación no va a descartar nada por inverosímil que parezca. No sería la primera vez que un suicidio es la causa (no hace falta que ponga el enlace de la wikipedia al «accidente» de Germanwings y Andreas Lubitz).

Pero la forma de trabajo es la inversa, primero se recopilan los datos, que muchas veces llevan a la causa, y si no es así se formulan hipótesis compatibles con los datos que se tengan. Uno de las datos que van a averiguar los investigadores mediante entrevistas al entorno de las dos personas involucradas es tenían problemas permanentes (problemas económicos, deudas, depresión, medicación, etc.) o puntuales (discusión reciente, etc.) que den pistas sobre su estado mental y comportamiento el día del suceso.

Si quieres algo especulativo más plausible, uno de los artículos enlazados por Enrique menciona un rumor de alguien de dentro de Uber sobre que el Lidar estaba desconectado a propósito para probar si los demás sensores eran suficientes. Hacer eso cuando no tienes un conductor de seguridad con los reflejos y la concentración 100% de un piloto de formula 1 durante 2h parece temerario…

Toca seguir esperando, pero la lista de «contributing factors» del informe final promete ser jugosa…

Y que lo digas. A pesar de que públicamente todavía no conocemos nada más que una pequeña fracción de los datos que existen (lo gordo está en los discos duros del coche), la lista de «contributing factors» es ya muy larga.

¿Por qué estaba tan oscuro? Es una avenida en una ciudad, ¿no deberían estar encendidas las farolas? Hay un cartel de prohibido cruzar, ¿estaba iluminado? La peatona salió de uno de los extremos de una especie de pequeño paseo pavimentado con forma de equis, ¿por qué no están vallados esos extremos? (los cuatro desembocan en los carriles de la avenida, que pasan a ambos lados de esa zona que actúa como mediana).

La peatona, ¿había hecho el mismo recorrido temerario nocturno otras veces? ¿Lo hacía todas las noches?

Saludos desde Ecuador, UPS le felicitó por la información proporcionada la cual permite analizarla de distintos aspectos y puntos de vista permitiendo analizar nuevos enfoques, este artículo lo encuentro interesante y agradable.

Como llevo siguiendo esta noticia desde que lamentablemente ocurrió, comentaré un caso que me pasó hoy, y que probablemente nos pasa a todos a menudo.

Al iniciar la maniobra para salir de mi aparcamiento en la vía pública, oigo de muy lejos las típicas sirenas de bomberos. Casualmente, hay un parque de bomberos cerca, y es habitual verlos salir de él si aparcas por la zona. Como las sirenas se oían muy poco, miré por el espejo retrovisor, y efectivamente comprobé que avanzaban a velocidad hacia mi posición. Detuve la maniobra, aunque por la distancia de los camiones, me hubiera dador tiempo perfectamente de salir.

Pero claro, si hubiera hecho eso, estaría incorporándome correctamente a la vía, pero hubiese obligado a todos los camiones a invadir peligrosamente el carril contrario.

¿Hubiera un coche autónomo escuchado las sirenas que se oían a lo lejos…? ¿Hubiera sido precavido en no incorporarse a la vía en tal situación, aunque técnicamente le daba tiempo…?

¿Deberíamos prohibirle conducir a los sordos? ¿De verdad crees que todos los conductores son tan precavidos como tú? Dado que los coches autónomos son capaces de identificar un control de policía y obrar en consecuencia, ¿por qué supones que con los bomberos es diferente? Tú necesitaste oír la sirena, para mirar por el retrovisor y ver el camión de los bomberos, pero un coche autónomo tiene varias cámaras cubriendo 360 grados.

Por supuesto que los sordos tienen la capacidad de conducir aunque, imagino, necesitando prestar mucha más atención que los demás.

Pero lo de que si los demás conductores son tan precavidos, no es el fin, si no el que los coches autónomos sean más precavidos que cualquier ser humano que pueda existir. Por que si van a tener las mismas limitaciones, no veo el sentido.

Y quizás también habría que adaptar el resto de flota de vehiculos con otro tipo de emisores, y no solo de sensores. Me refiero, por ejemplo, a los vehículos de emergencia. Disponer de la función de emitir una señal (por radiofrecuencia, por ejemplo) que sea identificable por el resto, facilitando la labor de los mismos en el ejercicio de su actividad. Y por qué no, a los vehículos en general para que crear una red interconectada.

Me gustaría pensar que esa cámara de 360° es capaz de identificar todo lo que se mueva.

Se acabará por llegar a eso, con todos los vehículos emitiendo señales electrónicas, y también los semáforos y otras señales de tráfico. El espacio de mejora que está todavía sin explotar por ese lado es tremendo.

Hay un patrón recurrente en muchas de las objecciones que se ponen al coche autónomo, y es si va a ser capaz de manejar mejor que un conductor humano cualquier situación comprometida en la que uno se haya visto. Para unos es la rotonda petada de su pueblo, para otros la M-30 de Madrid, para otros una curva sin visibilidad con un camión parado en el otro extremo y para ti un camión de bomberos. Yo tengo las mías, claro, y como no tengo talento innato para la conducción, lo compenso con dosis extremas de prudencia y hasta ahora no he tenido ningún accidente. Pero creo que es evidente que no todo el mundo tiene tu precaución, la mía o la de Juan Navidad.

La respuesta es que, eventualmente, sí, los coches autónomos podrán manejar prácticamente cualquier situación, porque la tecnología no para de mejorar y ellos no paran de aprender (y compartir el conocimiento con las flotas propias y ajenas). Perdonad que insista con la comparación de la aviación, pero un piloto actual sabe manejar por su entrenamiento todas las situaciones que no supieron manejar algunos pilotos en accidentes de las décadas pasadas. Eso no ocurre con los conductores humanos, y junto con falta de prudencia, hace que el número de muertos ya no baje mucho en algunos países como España, e incluso repunte.

Pero la cuestión más inmediata a la que nos vamos a enfrentar no es si el coche autónomo sabe gestionar correctamente todos los «edge cases» (que NO todos los conductores humanos sabrían gestionar correctamente). La cuestión es en qué punto, con lo que sepan hacer bien (guardar distancia de seguridad, respetar límites de velocidad, observar la señalización, no emborracharse, etc.) serían capaces de reducir el número de muertos anuales. En España son unos 1100-1200 muertos anuales (sin contar heridos). Unos 3 de promedio hoy mismo mientras hablamos de esto, mañana otros 3. Y no son portada.

Añado algunos datos de USA: 40.000 muertos al año, de los cuales unos 4.000 son peatones, que sale a 11 peatones por día. Desde el día del accidente del Uber, han muerto casi cien peatones en USA.

Lo que yo trataba de anotar es que lo que hace que los humanos seamos más efectivos en la carretera -si la suerte nos acompaña- es precisamente ser conscientes de nuestras limitaciones y las de nuestro vehículo.

Me saqué el carnet con 18 años y ha habido años que me he hecho 40000. 50000 y hasta 60000 al año. En total, calculo que en torno a un millón de kms con cuatro vehículos diferentes y nunca he tenido un accidente. Lo que tenían en común todos los coches era que se trataba de vehículos de segunda mano o de más de 5-6 años y sin grandes adelantos (nada de ABS ni cosas modernas). El que tengo ahora tiene 20 años, lo que me obliga a ser muy cuidadoso y más prudente que si tuviera 4 años.

He conducido muchos trayectos largos, nocturnos, a menudo muy cansado. Y he tratado de adaptarme siempre con formas de conducir adaptadas a las limitaciones del vehículo, las carreteras, las condiciones climáticas.

Lo que yo apuntaba es que si yo puedo hacerlo, un vehículo autónomo en fase de aprendizaje debería aprender de esa conducción prudente en la que el coche puede detenerse si detecta que algo no va bien. Porque si por tener un manojo de sensores se va a poner a copiar a los pilotos humanos suicidas que hay por ahí, entonces estamos apañados jeje…

Está claro que cuando esta tecnología esté madura y se generalice será más segura, pero deberá estar preparada para muchas situaciones anómalas, averías, baches, animales, borrachos, humanos imprudentes, etc.

Concluyendo un poco con el tema, está claro una cosa: todavía está muy verde la conducción autónoma, ya sea por cuestión de software o por hardware (me inclino por lo primero).

Un vehículo con tal cantidad de sensores laser, cámaras de 360°, visión IR y demás gadgets, que no haya podido ver a un peatón con su bicicleta, ya sea a plena luz del día, como en la más absoluta oscuridad, demuestra que es un proyecto inmaduro, por lo menos el de Uber.

Si ha sido un fallo de software, ya lo dirán las investigaciones. Ahora bien, ese hipotético fallo en el soft de Uber, ¿está presente también en el soft de Google? Está claro que Google está muchísimo más avanzada que Uber.

Por otro lado, ese hipotético fallo en el soft de Uber, ¿en qué consiste exactamente? Un error que tan solo se produce cuando al coche de Uber le falta la información de las cámaras (por la oscuridad) no es lo mismo que un error que se produce cuando una persona cruza por delante del coche llevando una bici a su lado, ya sea de día o de noche.

En el primer caso, el error no añade riesgo (un conductor humano la habría atropellado igualmente). En el segundo sí, un error así puede causar una muerte que un conductor humano habría evitado de día, o incluso de noche en una zona bien iluminada.

Con independencia de cuál sea el resultado de las investigaciones, Uber no está preparada para ofrecer servicio de robotaxis. Pero no porque haya tenido este accidente, sino porque su cifra de solo 20 Km entre intervenciones del conductor de seguridad es patéticamente baja.

Como anécdota, mi cámara de vídeo de una marca conocida, y hablo de hace 20 años, ya tenía visión infrarroja. Que un coche de estas características, y con estos avances tecnológicos, no detecte algo en la oscuridad, me da un poco de risa.

El lídar, desde luego, tuvo que detectar a la peatona.

No sé si el LIDAR o qué, pero tengo sensores volumétricos y de ultrasonidos, por unos irrisorios euros, que detectan objetos desde 7 metros. Si mis sensores, que son para hobbistas hacen eso, es de suponer que un gadget profesional sea 10 veces más efectivo. Pero claro, luego está la programación.

Ok, Enrique, sensorizacion y la interpretación de las mismas deberían hacer reaccionar a los políticos que son los que autorizan las pruebas

Respecto a la actualización de hoy, donde el gobernador de Arizona suspende los permisos de circular con coches autoguiados a Uber, en el twitter de la compañía Uber anuncian: «We proactively suspended self-driving operations in all cities immediately following the tragic incident last week.».

http://www.antena3.com/noticias/mundo/arizona-suspende-operaciones-vehiculos-autonomos-uber-atropello-mortal-mujer_201803275ab9f0b90cf240aa71200e4b.html

No me extraña la decisión del gobernador teniendo en cuenta que el sábado pasado, la misma semana que el accidente mortal, otro coche autónomo se ha visto envuelto en un nuevo accidente aparatoso en la misma ciudad que el anterior, en Tempe (Arizona). En esta ocasión no ha habido daños personales, aunque tampoco queda claro lo sucedido.

https://www.usatoday.com/story/news/nation-now/2017/03/30/self-driving-uber-crash-police-report/99814322/

A Uber le están empezando a crecer los enanos. Casualidad o causalidad.

Un apunte sobre el atropello de la ciclista, ¿qué hacía una señora con una bici ahí en medio de la nada?. Bueno pues resulta que el arcén de la carretera no es un arcén como tal. Se trata de un carril bici. La señal que sujeta la farola debajo de la cual fue atropellada indica eso precisamente «BIKE LANE». También es cierto que enfrente de esa señal, en la acera de la isleta mediana, hay otro que prohíbe expresamente cruzar por ahí a los peatones. Al que diseñó el camino dentro de la mediana había que correrle a gorrazos.

https://www.google.es/maps/@33.4359768,-111.9421808,3a,28.4y,318.53h,91.64t/data=!3m6!1e1!3m4!1sk2FfaCDJ44xYkMrQU2EBiA!2e0!7i13312!8i6656

Otro apunte, después de ver un par de videos de cómo es la iluminación nocturna en el sitio exacto donde tuvo lugar el atropello, da la impresión de que el video facilitado del accidente está oscurecido. Hay bastante más luz en ese punto de la carretera del que aparenta el video. Es más, tiene encima prácticamente una farola. Ahora ya no tengo tan claro que un conductor humano atento a la carretera no la hubiese visto, incluso con luces cortas. De ser así, una advertencia con el claxon, unas ráfagas con las luces hubieran puesto sobre aviso al peatón, y en última instancia, Un simple volantazo hacia el carril de la izquierda hubiera evitado el atropello.

https://www.youtube.com/watch?v=CRW0q8i3u6E&feature=youtu.be

En fin, ya se verá en qué queda todo esto. Mal por la señora que cruzó donde no debía pero el Volvo se la llevo puesta. No pinta nada bien para los de Uber al margen de que el accidente no fuese provocado por su vehículo.

Lo de que el vídeo podía estar manipulado, ya lo había leído, pero independientemente de eso, vuelvo y me reitero ¿me están diciendo, Sres. de Uber, que su vehículo, equipado con casi lo último en tecnología de sensores, no detecta algo en la oscuridad…?

Por el amor de Dios, si la más barata videocámara trae visón nocturna. Que hace bastante años que se conocen los infrarrojos, que los sensores volumétricos más simples están fabricados para detectar el calor de un cuerpo humano.

Imaginemos el típico caso de la pelota que sale de un lateral, entre coches aparcados. ¿Verá ese vehículo esa pelota? ¿Depende del tamaño de la misma? ¿Depende de la iluminación de la vía? ¿Su algoritmo deducirá que, posiblemente, detrás de una pelota en movimiento viene un menor corriendo a cogerla?

Y si su algoritmo no tiene contemplado este caso ¿sus sensores ultrasofisticados serán capaces de «ver» al menor y detener el vehículo? ¿O podemos decir que el menor cruzó por un lugar equivocado y sin supervisión de un mayor?

Salgan o no las causas reales del fatídico accidente, yo tengo claro una cosa: la tecnología en ese vehículo está muy, muy verde para circular en el mundo real. Por que en el mundo real, las personas cruzan por donde les viene en gana, las farolas pueden estar fundidas o apagadas y miles de etcéteras.

Opsss, como no puedo editar el comentario, rectifico y me disculpo.

Me acabo de dar cuenta que la fecha del «nuevo» accidente de Uber en Tempe tiene fecha de marzo …de 2017 (put… casualidad).

A todos nos puede el ansia viva. Siento la confusión y de nuevo reitero mis disculpas.

Y yo he escrito mi último comentario sin haber leído este tuyo, señalando un error que ya habías corregido. Nadie es perfecto :-)

El otro accidente que enlazas ocurrió hace un año, no hace unos días. Una conductora estampó su coche contra un Uber autónomo. Afortunadamente no hubo muertos ni heridos graves. Tú sabrás por qué dices que no queda claro lo sucedido, en el artículo lo explica muy bien.

Totalmente de acuerdo en que habría que correr a gorrazos al que diseñó esos «falsos caminos» (hay 2 cruzados, formando una equis) en la isleta de la mediana. Los 4 extremos de esos «falsos caminos» (incluido el punto de partida de la peatona) desembocan en los carriles de la avenida, en sitios donde no hay paso de peatones. En al menos uno de esos extremos (del que partió la peatona) hay un cartel de «prohibido cruzar».

Muy interesante el vídeo del coche recorriendo esa avenida. Ahora bien, con las cámaras pueden pasar tantas cosas que no tiene por qué ser representativo de la situación real, al menos como la vería un humano. Eso sí, genera una duda: ¿qué cámara refleja mejor lo que en ese sitio ve una persona? ¿La del Uber o la del que subió ese vídeo?

Cuando se investiga en serio un accidente, se hace una reconstrucción de los hechos, que además en este caso ya se ha hecho. Es decir, los investigadores ya han estado en el lugar del accidente, de noche, con el mismo coche accidentado, e incluso pusieron una bici en el punto del impacto, según informó la prensa USA.

De acuerdo en que no pinta bien para Uber.

Sin quitarle ni un ápice de culpa a Uber, que seguro que la tiene, pues una cultura de empresa no se cambia en unos meses, hay un factor que me parece importante y no tiene tanta relación con el vehículo autónomo como con el vehículo eléctrico. La señora no pudo ponerse a cruzar por qué no oyó ningún coche y no se dio cuenta de que venía? Tenemos costumbre de décadas de cruzar en función de los ruidos

No, el Volvo XC90 no es eléctrico, es híbrido. Y además, “híbrido decorativo”. Lo tuve durante una semana, y ningún día me aguantó mas de cuarenta kilómetros como eléctrico puro :-(

Creo que la polémica establecida sobre los automóviles autónomos hay que ubicarla en un contexto real. Si algún taxista atropella a una persona, ¿que hacemos? ¿le retiramos el permiso a todos los taxistas ? ¿Si comprobamos una falla de hardware ? ¿Le retiramos el permiso a la compañía fabricante? ¿Cuando Toyota, Volkswagen u otros fabricantes tuvieron fallas comprobadas? ¿Cerramos sus plantas?, hace poco tiempo Intel tuvo unos «tremendos» fallos en su procesadores, los cuales permitieron que se ejecutaran en nuestros computadores actividades maliciosas… ¿cerraron Intel? nada de eso, simplemente un «parche» y a seguir dando caña. Bien mi pregunta es ¿ por que ahora con los automóviles autónomos la «vara» para medir el fallo y/o delito es diferente ? Si tenemos en cuenta los «fracasos» de la industria farmacológica y la alimentación, quedarían pocas empresas en pié o funcionando y finalmente asumiríamos la filosofía «Amish». Que Uber pretende disminuir costos laborales…. hahahahaha «chocolate por la noticia» y cual empresa en este planeta no lo desea… señores esto es el capitalismo, con todo lo que significa ese concepto. Luego las consideraciones, muy subjetivas por cierto, de una actitud responsable están «rayanas» en la ingenuidad del que la sugiere. Tenemos que asumir que el «progreso» tiene costes, en vidas humanas y otras «yerbas», así funcionan las cosas, la aviación, el ferrocarril, el automóvil, la energía nuclear y un largo etcétera se han desarrollado sobre una montaña de cadáveres y desdicha. No veo la razón para que las cosas sean muy distintas a lo que fueron, claro está a menos que cambiemos muchos paradigmas en nuestra civilización, y mientras tanto reconforta «echarle» la culpa a alguien, sobre todo porque nos permite dormir tranquilos.