Durante muchos años, la relación de los usuarios con sus dispositivos ha sido marcadamente unidireccional: nos proporcionaban información, y nosotros, por lo general, la leíamos, veíamos o escuchábamos. Que el dispositivo fuese el que «leía» a su usuario era excepcional: mi Fitbit, por ejemplo, puede leer mi pulso – mi Apple Watch también, aunque solo cuando se lo pido específicamente – pero se limita a almacenar el dato, no reacciona como tal a su lectura, no toma decisiones basadas en ello, salvo en algunas situaciones limitadas. En las reglas de la interacción entre dispositivos y usuarios, el sesgo ha estado, hasta ahora, marcadamente claro: el que manda, el que lee, el que toma decisiones con la información es el usuario, el dispositivo se limita a ofrecerla.

Durante muchos años, la relación de los usuarios con sus dispositivos ha sido marcadamente unidireccional: nos proporcionaban información, y nosotros, por lo general, la leíamos, veíamos o escuchábamos. Que el dispositivo fuese el que «leía» a su usuario era excepcional: mi Fitbit, por ejemplo, puede leer mi pulso – mi Apple Watch también, aunque solo cuando se lo pido específicamente – pero se limita a almacenar el dato, no reacciona como tal a su lectura, no toma decisiones basadas en ello, salvo en algunas situaciones limitadas. En las reglas de la interacción entre dispositivos y usuarios, el sesgo ha estado, hasta ahora, marcadamente claro: el que manda, el que lee, el que toma decisiones con la información es el usuario, el dispositivo se limita a ofrecerla.

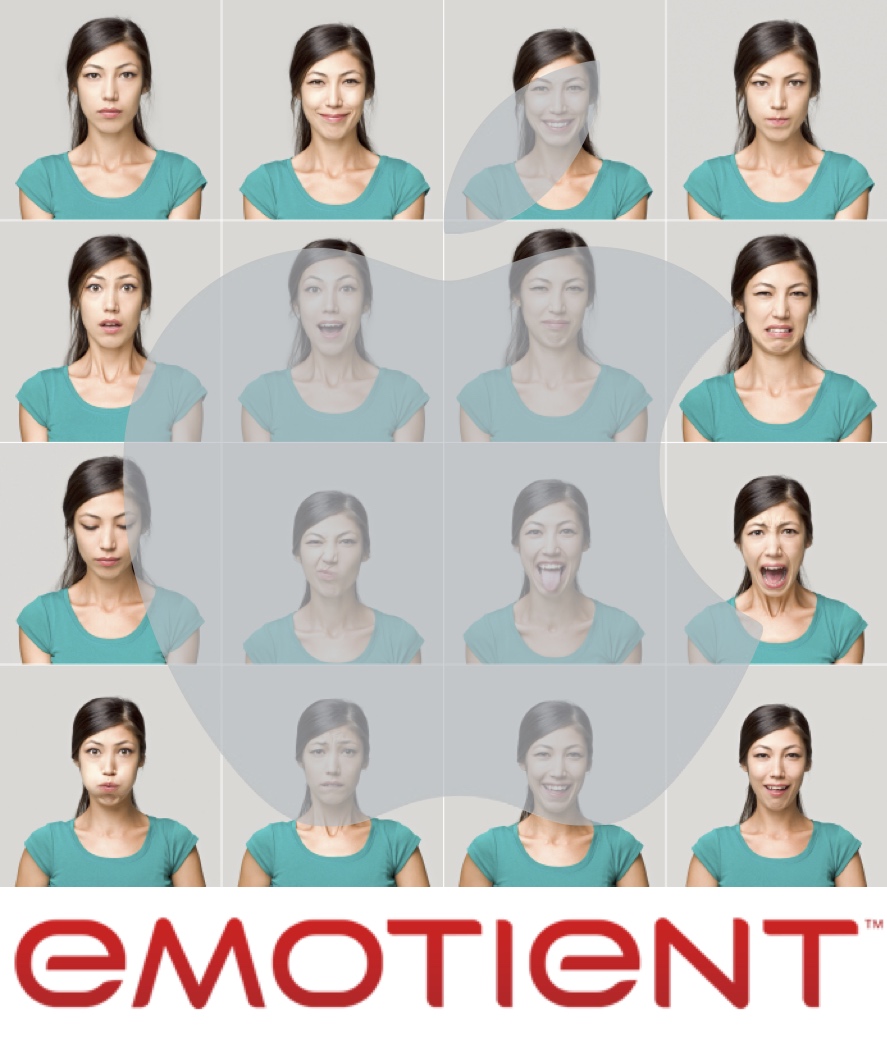

Una reciente adquisición de Apple, anunciada ayer, podría apuntar a cambios en ese sentido. La empresa es Emotient, una compañía dedicada a la lectura de las expresiones faciales y su conversión en información. Aunque la compañía, en los días previos al anuncio, ha remodelado su página web y eliminado la información referente a sus productos que tenía en el mercado, sabemos que se dedicaba, por ejemplo, a tratar de averiguar reacciones de usuarios ante anuncios de publicidad, para interpretar reacciones de dolor en pacientes incapaces de expresarse, y para monitorizar expresiones de clientes ante estanterías o escaparates. Información tomada de Archive.org permite ver cuestiones interesantes como indicadores de atención, de engagement o de sentimientos, tests A/B para campañas y anuncios, predicción de viralidad, análisis predictivo de lealtad de clientes, y otros conceptos tradicionalmente encuadrados dentro del llamado neuromarketing.

Aunque el importe de la operación no ha sido revelado, la compañía había captado previamente ocho millones de dólares, los seis últimos en una ronda de inversión en marzo de 2014. Apple no ha dado ninguna información sobre lo que pretende hacer con la compañía, pero todo indica que la adquisición se encuadra en un conjunto de adquisiciones relacionadas y recientes como Perceptio (sistemas de reconocimiento de imágenes utilizando deep learning) en octubre del pasado año; o Faceshift, una startup suiza con base en Zurich que trabaja con la animación de avatares (su software fue utilizado, entre otras cosas, en la última entrega de Star Wars), pero que también tiene posibilidades para avatares conversacionales en tiempo real para FaceTime, para la biometría relacionada con el desbloqueo de dispositivos, o para la autorización de pagos mediante reconocimiento facial.

El análisis de las compañías en función de sus adquisiciones es una ciencia compleja y sometido a interpretaciones de todo tipo. Pero que Apple adquiera una serie de compañías relacionadas con la lectura de las expresiones y emociones faciales solo puede indicar que nos dirigimos hacia un mundo en el que estaremos rodeados de dispositivos que no simplemente accionamos y leemos, sino que nos leen a nosotros, y pueden llegar a actuar en función de nuestras expresiones faciales. Desde reconocernos con mayor fidelidad y certeza, hasta especificar el tipo de información que nos ofrecen. En cualquier caso, una exploración interesante que tiene que ver con el desarrollo de inteligencia «al otro lado» de los principios de la interacción entre hombres y máquinas, la human-computer interaction o HCI. ¿Podemos pensar en una Siri que en lugar de quedarse quietecita esperando nuestro próximo comando de voz, analiza nuestra expresión con respecto a la información que nos ha brindado y trata de actuar en consecuencia? Lo que podamos tardar en ver desarrollos relacionados con este tema en productos de la compañía es toda una incógnita, pero sin duda, apunta en esa dirección.

This article is also available in English in my Medium page, “The age of the face-reading device is coming«

«Faceshift, una startup suiza basada en Zurich…» Cuidado con el traductor automático. ¿No sería mejor «situada en Zurich» o «localizada en Zurich»?

Un posible ámbito de aplicación, relacionado también con las apuestas de las compañías tecnológicas en el ámbito de la automoción, sería la percepción de las emociones de los conductores (sueño, alcohol, etc.) de cara a evitar posibles accidentes.

¿Traductor automático? El único que uso es el que hay en mi cabeza, pero en realidad es que traducir, no traduzco nada… simplemente leo y escribo. El día que vengas a esta página a leer noticias traducidas, te equivocarás: si no creo que puedo añadir valor a la simple traducción, no escribo sobre ese tema.

Buen punto el de los coches…

Mis disculpas entonces!! :-)

Me toca escribir frecuentemente en inglés (mal inglés) y al final acabo «castellanizando» palabras.

Una sugerencia, Enrique: me encantaría que los blogs y los periódicos on-line tuvieran un apartado específico para notificar erratas ortográficas, sugerencias de traducciones y similares, separado del hilo de comentarios.

Mejoraría la calidad de la conversación.

A ver, lo suyo es que ante una errata, typo o sugerencia de uso del lenguaje en una página que te gusta, se ponga un comentario en moderación notificándolo y se advierta al propietario de la página de que no es necesaria su publicación, o se envíe un correo electrónico. Pero yo, que soy generalmente el beneficiado de esas sugerencias, no voy a ser el que coarte la libertad de los que me las hacen para que las hagan por el canal que estimen oportuno… :-)

Eye-Tracking Car Tech.

https://translate.google.es/#en/es/Eye%20Tracking%20Car%20Tech

;)

Siempre he sido de la opinión de que no existe adicción a los dispositivos sino a la información que estos nos proporcionan. ¿Tendré un nuevo whatsapp sin leer? ¿Qué tiempo hará mañana? ¿A qué temperatura está mi dormitorio? ¿A que valor se encuentra determinada acción? ¿Qué tal anda mi pulso o mi nivel de azucar?.

¿Realmente es importante saber eso a cada instante?

Creo que la tecnología, gracias a nuevos «servicios» que se están empezando a perfeccionar (tales como learning machine, etc), debe centrarse en informar e interactuar con el usuario cuando realmente sea importante. Aquí entran en juego también tecnologías, que últimamente están proliferando, más ligada al mundo físico, como los wearables, internet of things, … y ¿por qué no? algo tan comunicativo como puede ser el rostro de una persona. En función de la información generada por todas estas tecnologías y en función de las necesidades de cada persona, se tomen decisiones que faciliten/mejoren nuestras vidas. (Las tecnologías de la información y la comunicación no son ninguna panacea ni fórmula mágica, pero pueden mejorar la vida de todos los habitantes del planeta, Kofi Annan).

¡Cada día pienso que esa apuesta de 30 millones de dólares por IFTTT es ganadora!

https://www.enriquedans.com/2014/08/que-puede-hacer-ifttt-con-treinta-millones-de-dolares.html

¡Un saludo y gracias!

Creo que el avance en este campo va a ser, como no puede ser de otro modo, espectacular.

Hace tiempo que monitorizo varios parámetros de mí día a día: sueño, pulsaciones, comida, ejercicio,

… Y además lo he hecho con 4 dispositivos distintos y a día de hoy con dos a la vez (Fit Bit Charge HR y Gear con App dedicada para pulso + health de Samsung). Básicamente yo me cuantifico (más o menos automatizado) pero ninguno me ofrece por ahora lo que yo busco: predicción. Si he pasado una época en la que he tenido mucho trabajo, viajes, he dormido poco y siento ansiedad, veo mis pulsaciones base y han subido un 5-10%. Y por que si ve que las pulsaciones van subiendo, no duermo y hago poco ejercicio no me avisa de que mi nivel de stress y ansiedad seguramente sea elevado? O si ve que hago una vida sana y me suben me alerta que quizás debiese hacerme una revisión médica?

Efectivamente, es que tu no deberías de estar teniendo que mirar como andan tus pulsaciones, debería ser el aparato el que te avisara, seguro que se puede programar de alguna manera.

De todas maneras, cuando hablamos de datos o información «vital», entiendo que las marcas andarán con cuidado a la hora de alertar/asesorar a los usuarios… pueden meterse en problemas.

En mi caso, hace un par de años empecé a «jugar» con la domótica lowcost en casa. Tengo integrados sensores de temperatura, luces y enchufes inalámbricos, alguna cámara de seguridad, … después de un año me he dado cuenta que lo realmente importante no es saber la temperatura del salón, ni ver la imagen de la cámara de seguridad, ni encender desde el móvil la luz de la entrada. Lo que realmente me ha mejorado la calidad de vida y mi bolsillo, es que mi móvil me avisa si hay movimiento en la cámara cuando no estoy en casa o si estoy consumiendo mucha energía, la luz de la entrada se enciende sola si estoy en casa y se ha puesto el sol, y la estufa del cuarto de mi hija se enciende y apaga sola en función de que estemos en casa y de la temperatura de su cuarto. En fin, ya no tengo que estar pendiente del móvil. Solo lo hago cuando realmente es necesario.

¡Un saludo!

Si tenemos en cuenta el salto cualitativo que hemos experimentado en los últimos años en el campo del procesado digital de imágenes -gracias principalmente al avance en técnicas de deep learning-, y en el análisis y procesado de grandes cantidades de datos no estructurados, es fácil intuir que en los próximos años todas estas innovaciones las veremos en forma de app en nuestros móviles, que a falta de una cámara tienen dos :)

La verdad es que las posibilidades que se abren con estas tecnologías son verdaderamente emocionantes.

Me va a encantar asistir a charlas sobre la «usabilidad» del humano desde el punto de vista del dispositivo… XD

Muchas gracias por el post. Al leerlo me vino a la mente, lo que se nos corrió a mi amigo Felipe García @Knowdler y a mi, cuando visitamos #Ficod14.

Vimos las pantallas transparentes interactivas de @virtualware, a través de las cuales se pueden poner contenidos virtuales y reales. Y pensamos que podríamos poner un sistema que vaya registrando y analizando las expresiones faciales de los usuarios que están viendo la pantalla que es como una vitrina. De esta forma se podría medir la efectividad de una campaña publicitaria o simplemente el testear un producto antes de desarrollarlo.

Y ahora después de 2 años veo muchas más posibilidades… porque los dispositivos nos pueden leer y actuar en tiempo real.

Un saludo.

Es cierto que por un lado asusta, ver hasta qué punto podemos llegar.

Pero yo creo que el uso de tecnologías para reconocer nuestros gustos y necesidades es positivo. Ya estamos sobresaturados de publicidad, y seguiremos recibiendo impactos publicitarios. La diferencia está en que sean de interés o no.

Yo sinceramente prefiero ver publicidad hiper-segmentada, que me ofrezca cosas que realmente me pueden interesar, a ser spameado constantemente por anuncios en los que no tengo el menor interés.