El episodio en torno al algoritmo que Twitter utiliza para centrar las imágenes en los tweets ha dado mucho, mucho que hablar estos días, y más en un escenario como los Estados Unidos, en el que el racismo se ha convertido últimamente en protagonista de una gran cantidad de noticias y en una fuente enorme de polarización.

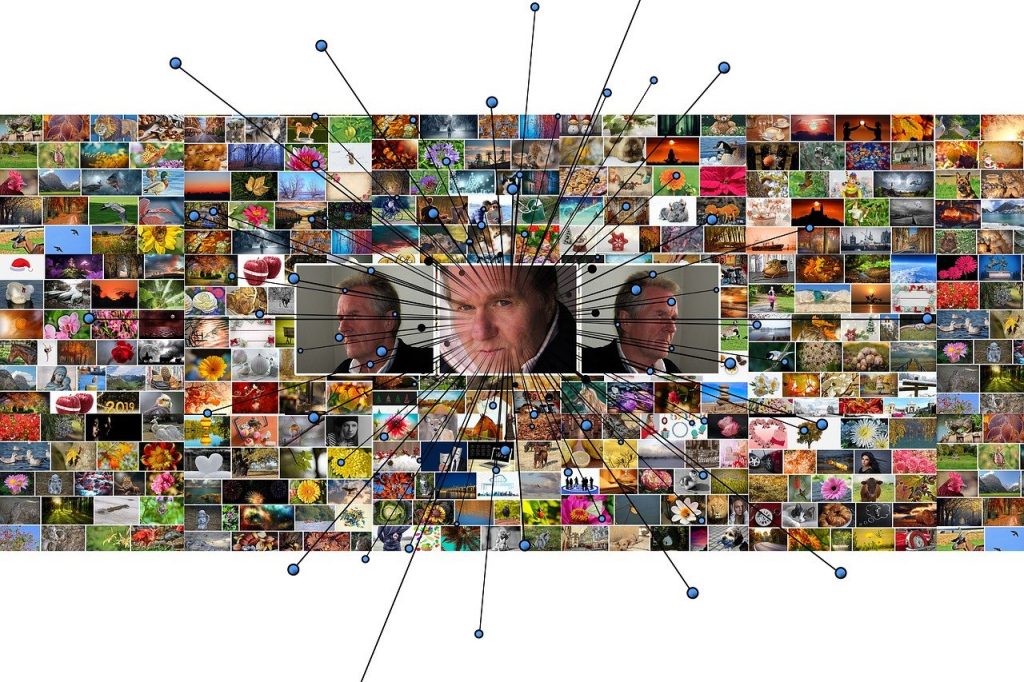

El propósito del algoritmo creado por Twitter es, en principio, muy sencillo: que cuando una persona utiliza una imagen en un tweet y esta no tiene el ratio de dimensiones adecuado como para mostrarla en su integridad, el fragmento que se muestre de la misma cuando el tweet aparece en el timeline del usuario trate de recoger lo mejor posible su significado o de resumir de la mejor manera posible su esencia. Para ello, el algoritmo tiende a seleccionar las partes de la imagen, por ejemplo, en las que reconoce un texto, o si detecta una cara, tiende, con cierta lógica, a centrarse en ella. Hasta aquí, todo bien.

El problema surge cuando una serie de usuarios empiezan a darse cuenta primero, y a hacer experimentos después, porque se dan cuenta, por ejemplo, que entre una persona de raza blanca y una de raza negra, el algoritmo escoge siempre la primera. La prueba es muy sencilla: pon una cara de una persona de raza blanca y otra de una persona de raza negra separadas lo suficiente como para que no puedan ser mostradas a la vez, y fíjate en cuál de las dos aparece. E invariablemente, en todos los casos, la escogida era la persona de raza blanca.

No solo eso: entre un perro blanco y uno negro, lo mismo. O con personajes de cómics. No importa en qué lado esté la fotografía de la persona de raza negra o blanca: a la izquierda, a la derecha, arriba, abajo… el algoritmo siempre escoge la imagen de la persona de raza blanca. ¿El fondo? No parece influir mucho. ¿Que sean adultos o niños? Tampoco. Todo indica que el algoritmo de Twitter, por alguna razón, es terriblemente racista.

Obviamente, esa primera conclusión, como tantas otras que se hacen a la ligera, es completamente errónea. Para cualquiera que conozca mínimamente Twitter o haya tenido algún contacto con sus directivos, la hipótesis de un comportamiento intencionado es ya no improbable, sino directamente absurda. Además, los algoritmos carecen de ideología: solo reflejan lo que los datos con los que han sido entrenados reflejaban a su vez, en patrones que no siempre son fácilmente identificables. La compañía, horrorizada, entra en la discusión, trata de ser completamente transparente, y hasta algunos de sus directivos contestan en Twitter según lo que ellos creen que puede ser la explicación, completa y genuinamente sorprendidos por el hecho. El algoritmo había sido probado, ensayado en numerosas ocasiones, puesto a prueba con muchísimas imágenes… simplemente, a nadie se le había ocurrido probar si podía resultar que fuese racista, no se consideraba un resultado esperable o plausible como tal.

Aparentemente, alguna de las variables latentes en los datos con los que fue entrenado daba como resultado eso, y en el complejo conjunto de pesas y composiciones de variables que terminaban generando el resultado final, eso era lo que pasaba. Y analizar qué variable, qué peso o qué diablos hacía que el algoritmo se comportase de esa manera es de todo menos obvio. Los algoritmos de este tipo tienden por lo general a agrupar combinaciones de variables con correlación elevada y a considerarlas indicadores que son utilizados como variables latentes en procedimientos matemáticos a veces muy complejos, lo que conlleva, en ocasiones, una cierta dificultad a la hora de entender de dónde proviene un sesgo determinado. Posiblemente, las colecciones de imágenes con las que se entrenó el algoritmo contuviesen un número mayor de imágenes de personas de raza blanca que de raza negra, y ese efecto, simplemente, no fue detectado en las pruebas que se hicieron con el algoritmo antes de ponerlo en producción.

¿Cómo actuar ante un problema de este tipo? Lo fundamental, claro está, es ser enormemente transparente: ese resultado no es intencionado, ha surgido por algún tipo de problema en el desarrollo del algoritmo, y será solucionado lo antes posible. Si puedes abrirlo al público para que sea examinado por un número mayor de ojos, tendrás seguramente más posibilidades de entender antes lo que ha sucedido, y de arreglarlo antes. Es fundamental entender que estamos ante un problema que puede suceder, en prácticamente cualquier contexto, en prácticamente cualquier momento, generalmente al inicio de la puesta en producción de cualquier algoritmo, y que no cuestiona el machine learning como tal, sino el tiempo de entrenamiento que precisa un algoritmo para obtener resultados fiables.

La otra parte de la respuesta de la compañía consiste en ofrecer a los usuarios más control sobre cómo van a aparecer sus imágenes en el tweet, y probarán diversas opciones para hacerlo con un adecuado nivel de usabilidad. Que el usuario decida en lugar del algoritmo, al menos mientras el algoritmo no esté suficientemente bien adiestrado y no comprobemos que no hace tonterías que puedan generar problemas.

La mejor forma de entender un problema de un algoritmo de machine learning es entender cómo funciona el machine learning y sus algoritmos. Un potencial enorme e indudable, por supuesto, pero también una cierta necesidad de supervisión, en relación con prácticamente cualquier aspecto. El ejemplo de Twitter es perfecto para entenderlo. Pero estemos preparados, porque seguro que nos encontraremos con bastantes más.

This article was also published on Forbes, «Biased algorithms: does anybody believe Twitter is racist?«

Interesante información

Los algoritmos son tan neutros como la aritmética, escogen la imagen con mayor puntuación. Los que puntúan las imágenes no son neutros, aunque ni siquiera sean conscientes de no serlo.

Su para entrenar un algoritmo de texto, le das una extensa colección de textos inclusivos, plagados de frases como los hombres y las mujeres, los maestros y las maestras, los ministros y las ministras,…. El algoritmo colocará lo masculino delante de lo femenino y de tener que elegir uno de los dos sexos, mostrara un elevado carácter machista, que muy probablemente asombre a sus creadores, que hasta se cuidaron de buscar textos inclusivos para entrenarlos

Creo que la única solución cuando se detecta un sesgo, (posiblemente otros muchos no se detecten jamás), es partir que la BD que usabas para entrenar estabas estaba «contaminada» de sesgo.

Pasar la base de datos que se utilizo v con el algoritmo y eliminar un 10% de las fotografías en que el resultado da muestras de sesgo.

Volver a entrenar el algoritmo con esta BD purgada y ver el resultado. y repetir el proceso hasta conseguir que desaparezca el sesgo.

Hoy toca Twitter

El problema es el uso mismo de un algoritmo que tome decisiones relevantes sobre qué contenido mostrar en cuestiones sensibles. Habría que dejarlo en manos del usuario el 100% de las ocasiones. Si no es por raza alguien encontrará cierto sesgo por sexo, o por edad, o vestimenta. Y si no alguien rebuscará lo suficiente hasta encontrar cierto sesgo por color de ojos, peinado o cualquier otro detalle que se le ocurra.

En el fondo el asunto no tiene solución porque un algoritmo ha sido entrenado con cierto número de imágenes para ‘aprender’ lo que es relevante. Es imposible que no surjan sesgos porque el objetivo del aprendizaje consiste precisamente en destacar ciertas características frente a otras siguiendo cierto criterio (frecuencia de aparición por ejemplo).

Salvo que la decisión sobre qué parte de una imagen mostrar sea totalmente aleatoria (lo cual es inútil y además no haría falta que el algoritmo ‘aprendiese’ nada) siempre será posible encontrar algún sesgo.

Es tan facil como que TW te ofrezca «su solucion» y a continuacion te pregunte, si la aceptas o no.

Caso afirmativo, lo incorporas como positivo.

Caso negativo, lo descartas y dejas en mano del usuario el centrar la foto, si asi lo desea.

El problema del aprendizaje automatico, siempre lo he dicho, esta en el automatico… necesitas el feedback.

De todas formas con lo que no podemos acabar es con el sesgo del usuario, Supon que el algoritmo hubiera elegido sistemáticamente la cara de un negro en vez de la de un blanco, ¿Hubiera llamado alguien racista al algoritmo? ¿Le habría preocupado lo mas mínimo a alguien?. El problema esta en el usuario no en la máquina,

Pasa lo mismo que con los preocupados con la igualdad de género, les angustia que no haya suficientes mujeres ingenieras, pero se olvida que hay mas Juezas que Jueces, y mas Medicas que Médicos,

El problema es la hipersensibilidad de la audiencia ante algunos temas. Vivimos angustiados de no llamar moros a los marroquis, cuando «moroc», es «occidente» y Reino de Marruecos (Royaume du Maroc), es el Reino de Occidente, (mirando desde la Meca) y Mauritania (Moritan) es la tierra de los occidentales, ¿Cómo le va a sentir mal a un marroquí que le llames moro, si ellos se consideran como nosotros occidentales?

Pero el problema es que tratamos de tapar nuestros prejuicios racistas, de genero, xenófobos, (que realmente todos tenemos en mayor o menor grado) ,con otros prejuicios inventados, que nos «preocupa» que no hay igualdad de ingenieras, que pongamos «cuidado» no le voy a llamar negro a uno que dice venir de Nigeria, ni moro a un del Reino de Moroc.

Así lavo mi mala conciencia, de ser realmente sexista, racista y xenófobo, en vez de sencillamente reconocer que tenemos unos prejuicios que no soportan el mas mínimo análisis racional.

A la hogueraaaaa… a la hogueraaaa…!!!

XDDDDDD

Las dos profesiones que citas pueden tener una mayoría de mujeres por el sistema de acceso. Los jueces por oposición y los médicos primero la Selectividad con una nota de las más altas, como las mujeres son mayoría en ese nivel de notas entran más y después de licenciarse el MIR hace que consigan las mejores especialidades.

Quizás lo primero que deberíamos hacer, es utilizar las palabras correctas (lo digo por nosotros, no por el caso Twitter)

Se habla del “algoritmo” (sobre todo si la conversación va de ML) como si fuera la varita de Harry Potter o el bastón de Gandalf, que hace «cosas que hacen cosas», y nos maravillamos por el Abracadabra resultante… No. Es solo código. Y algoritmo, no es código. (Búsquese, no sé, en la Wiki…?)

Algoritmo es todos aquellos pasos necesarios para la resolución de un problema. Es decir: la idea. Es el código, quien hace realidad la idea, y a quien hay que culpar en todo caso.

Sabemos que sumando 2 a 2 tendremos 4, pero si mi código dice: 2 / 2… cero patatero.

Si a un algoritmo (idea) le damos vida (código), pero envenenamos su entrada (datos) ya tenemos el pollo montado. Y como veis, no hace falta que sea ML. (Gorki ha estado acertado en sus dos comentarios)

Por tanto, llamemos pan al pan, vino al vino y algoritmo al algoritmo y código al código.

Ahora bien, Twitter se ha buscado un problema innecesario, invirtiendo recursos en solucionar un problema que nadie pedía. Si yo subo mi foto con mi novia… aunque no estemos “juntitos”

No será que quiero que salga ella también? Por que TW tiene que “desplazarla”?

Addendum:

«La mejor forma de entender un problema de un algoritmo de machine learning es entender cómo funciona el machine learning y sus algoritmos»

No eDans, Skynet aun no se ha inventado (afortunadamente) XDD

Solo es codigo… XDD

A lo mejor sería prudente, cuando ves que alguien se dedica a ser asesor estratégico de una compañía de machine learning, que no asumieses que no tiene ni puta idea de lo que habla. Vamos, un decir…

Joder Enrique, pues sería igual de prudente, que reinterpretar las cosas que digo, de otra manera, porque no veo yo donde digo que seas un negao…

Como informático hago una distinción entre dos términos, que tienden a confundirse. Como cuando la gente se empeñaba (y sigue haciendo) en llamar CPU al conjunto caja/ordenador y no limitarlo al chip..

Y en el último párrafo, solo hago un chascarrillo (para variar) haciendo hincapié en que hablamos de ML como si de Skynet se tratara. Y aun no es ese momento…

Mis disculpas si te he ofendido, sin querer.

No, hombre no… pero que precisamente lo que intento en el artículo es que la gente entienda que esto va de datos y de estadística, de variables latentes y de procedimientos matemáticos que, en muchas ocasiones, no es sencillo analizar más allá de sus resultados, y que este tipo de sesgos son normales (y no indican nada sobre quién los ha puesto en producción), por eso me extrañaba ese párrafo final. Pero no, no me he sentido ofendido, faltaría más! :-)

Coño, que ya me conoces… XDD

Hombre, de IA, algo sabre, cuando empece con Prolog en el 89 (cierto que nunca con salida laboral), pero aprender de predicados y objetivos, de bayesanos y frecuenciales, de motores de inferencia y heuristica… y aplicar todo eso en, esta vez si, mis ambitos laborales, pues algo se… XDDD

Pero de humor, tambien se (aunque no siempre acertado)… XDDD

Tiempo de entrenamiento (experiencia que dicen) en general, pero también contra del sesgo racista, por muy inconsciente que lo posea el programador (o como se llame).

Mucha gente se mete con el término micromachismo, por considerarlo invento feminazi, pero resulta que es tan típico y tópico ese machismo, en «poca y diluida cantidad» que invade el cerebro de muchos machos (y hembras), que resulta de un acientíficismo notable negar su existencia. Está ahí, en cada parrafada mental, sin llegar a extremos de feminismo radical. Solo de una buena educación en interacción social.

Como el microracismo, el microesclavismo… son simples síntomas de una enfermedad muy perdurable en el imaginario terrestre actual. Y los programadores, por muy siliconados que estén (o precisamente por eso) suelen padecerla en extremo.

O a lo mejor, solo es una cuestion de haber empleado colorimetrias en los algoritmos (codigo, siempre codigo) para distinguir el sujeto del fondo. Siempre es mas facil distinguir un individuo «blanco» que uno de color…

y sin querer defender a los programadores de TW, si han alimentado sus bancos de imagen con las que ya disponen en la red, donde la mayoria de usuarios son de raza blanca, no es de extrañar el sesgo.

Pero el error esta en los datos, no en las ideas propias de programadores (que podria), pero no lo doy por valido, a menos que no lo pase por el filtro de la paradoja de Sherlock Holmes: «Cuando han sido descartadas todas las explicaciones imposibles, la que queda, por inverosímil que parezca, tiene que ser la verdadera»,

Te acepto esos argumentos (forzados) en tanto a publicidad y packaging, donde lo normal es ver felices familias caucasicas y no menos felices rubitos niños, con o sin pecas…

Acusar a los programadores, siliconados o no, de ser racistas o esclavistas, y asi, en general, metiendolos a todos en un mismo saco… no me parece digno de ti…

Hasta donde yo se, las ideas personales no han perjudicado racialmente, ni gestiones de stock, ni contabilidades, ni facturaciones, ni gestiones bancarias, ni….

¿ Los programadores no son racistas ?

No sé. Creo que tú y yo tenemos en mente los programadores españoles que conocemos.

Pero si hiciéramos un survey políticio con los programadores de allá seguramente Trumpito volvería a ser elegido…

Como lo mio es el ambito tecnologico, llamame bendito cordero, quiero creer que no… en general…

Al tratarse de un pais como EEUU, puedo creerme cualquier cosa, y en este caso si, el bendito me lo meto en el bolsillo…

Un ejemplo claro de prejuicios. Sin conocer un solo programador de Silicon Valley sabe cual es su nivel de racismo y como votan, pero no explica como esos mismos señores votaron a Obama.

No lo interpretes por prejuicios. Es una impresión basada en datos como los siguientes

[1] Porcentaje de blancos en EEUU: 75%

[2] Porcentajes de blancos que votarán Trump según sondeo NYT, 49% suben 7 puntos frente a Biden que suman un 42%

[3] Los «Data Scientist» y los «IT Managers» son de los mejor pagados en EEUU

Normalmente el voto de las personas que cobran un mayor sueldo es mayoritariamente conservador. No puedo evaluar cuanto es pero asumamos que sube un 10% sobre el número final ( me lo invento, aquí me tiro a la piscina)

La muestra de progrmadores, creo que será lo suficientemente estratificada y grande para asumir lo siguiente

* 75% son blancos

* 59% votan Republicano (49% +10%)

Así mi afirmación previa era

si hiciéramos un survey político con los programadores de allá seguramente Trumpito volvería a ser elegido…

Como quería Demostrar, no es un caso de prejuicio:

y en tu caso decías

«Sin conocer un solo programador de Silicon Valley sabe cual es su nivel de racismo y como votan»

Como te diría el obispo Cañizares no hace falta abortar para hablar del aborto.

Y te doy la razón puedo estar equivocado. O no. A la vista de estos datos, no lo veo.

[1] https://es.wikipedia.org/wiki/Etnografía_de_Estados_Unidos

[2] https://www.nytimes.com/2020/09/27/us/politics/poll-supreme-court-trump-biden.html

[3]

Se me cortó [3]

https://www.xataka.com/otros/estos-son-los-trabajos-mejor-pagados-en-el-sector-tech-en-eeuu

Y Gorki gracias por debatir, pero por favor no afirmes en vacío sin mostrar datos

Quien no mostraba datos eras tu, Yo solo quería que explicaras que los mismos programadores de Silicon Valley, unas veces votan a un negro y demócrata y otras a un blanco y republicano .

Y puesto que te gustan los datos te diré que California donde se encuentra Silicon Valley, votó mayoritariamente a Clinton. por lo que de poco deben valer los votos de los programadores blancos y ricos, https://es.wikipedia.org/wiki/Elecciones_presidenciales_de_Estados_Unidos_de_2016#Resultados_a_nivel_estatal

Xaquin,

Como diría tu casi paisano Campoamor, todo depende del color con que se mira. ¿Aman los catalanes el concepto de bandera como símbolo de la patría? Creo que rotundamente si. Pero aqui hay un sesgo numérico, algunos su bandera es rojo, amarillo, rojo, y la otra mitad sigue con amarillo, rojo,…

Sin embargo cuando lo observas en un altillo, pensarías que cafres, como se tratan «los patriotas» y que va tenemos el sesgo equivocado, en realidad lo que no tienen es educación los unos sobre los otros.

Que razón tenía Campoamor, con el filtro adecuado, en este caso una puerta lógica NOT en el resultado de twitter, tendríamos al negro como color predominante… pero la cagada del sesgo-entreno seguiría… así que algo mal y más profundo hay.

Lo del machismo no te acabo de coger la idea… Eso no es sesgo involuntario, es pura elección voluntaria de ser un cabronazo con pintas.

Vamos a ser buenos…. ¿Ha creado twitter un algoritmo para favorecer a los perros blancos en vez de a los perros negros?

Pero para que perdemos el tiempo con las cosas importantes que hay en una discusión bizantina. Mucha discusión pero lo obvio es que ha habido un sesgo al alimentar al subsodicho algoritmo.

Si resulta que a un algoritmo le dice la bruja de Blancanieves, ¿quién es la más guapa del reino? Y la contestación es: tú no, puta vieja negra, pues deberemos concordar que algo de sesgo racista hay.

Que una vez más hay racismo en el diseño del procedimiento para entrenar al algoritmo. Cuando hace un tiempo confundía, creo que Microsoft, un negro

con un gorila podías pensar que tonto estoy que se me ha pasado. Pero es una cagada que sabíamos que podía pasar.

Pues si resulta que en el país que gana Trumpito, hay una empresa con empleados ,supongamos que blanquitos en su mayoría, que entrenan un algoritmo, para sacar en automático una miniatura de una foto, y oohhh insólita y OHHH! puta casualidad que en el entreno vuelve a salir el negro perdedor…

¿Para que coño la peña sigue usando herramientas de RRSS yanquis? !!!

Si esos que nos ponen aranceles a las aceitunas…

Gracias Enrique por darnos una razón más en contra de las RRSS

y apoyo a LUA65

Habria que preguntarse (no lo se, no lo he investigado) si por ejemplo, en paises africanos, se produce ese sesgo…

No se si el algoritmo tiene en cuenta la «regional» tal cual hace con el idioma…

Seguramente entre los africanos subsaharianos y los saharianos…. ;-)

y con los perros africanos?

Visto lo visto… todo son hienas XDDD

Con la tontería de no equivocarme para la frase «del color con que se mira» y en la wiki de Campoamor (creía que era de Espronceda) he encontrado una cita buenísima, al menos que sirva lo de twitter para rescatar a un grande:

El mejor retrato mío sería el siguiente: “Leyó por entretenerse; escribió para divertirse, vivió haciendo al prójimo todo el bien que pudo, y se morirá con gusto por olvidar el mal que muchos prójimos le hicieron” […] Mi biografía es muy sencilla: la de alguno de mis detractores será un poco más complicada, pues en materia de temeridades intelectuales yo me confieso pecador y digo como el filósofo: ¿Hablan mal de mí? Pues si supieran otros defectos que tengo, aún hablarían peor.»

Es que me acaba de venir a la cabeza, algo que ha sido recurrente en mis clases de Photoshop, cuando enseño a mis alumnos a hacer selecciones, sobre todo con la magic wand.

Les doy una imagen con dos chicas sobre fondo blanco. Una caucasica y la otra de color. Photoshop selecciona mejor a la de color.

Diriamos que Ps es racista inverso?

Lo interesante es como la atención se la ha llevado Twitter, cuando el problema empezo cuando alguien se dio cuenta que Zoom no detectaba como rostro al de su colega negro….

Dicho esto, creo que parte del problema con el ML y la AI, es que se ha puesto un peso muy excesivo en la estadística, olvidándonos de que hay programación, la definición de una lógica como parte de la solución… y por ahí podría haber estado el ajuste fino frente al sesgo del modelo generado.

Me parece muy acertada la respuesta de los directivos, mostrarse transparentes es una muestra de que no hay intenciones macabras detrás de este suceso, y tal como reseña el artículo, los algoritmos no tienen preferencias ni pueden discriminar. -Gustavo Woltmann.

Varios temas importantes. Hablar de ‘algoritmo’ es del todo impreciso, un ‘programa’ consta de diversos algoritmos, que están orientados a fines concretos dentro de un programa, dónde un algoritmo puede encargarse del ‘aprendizaje’ a partir de los ejemplos, por ejemplo usando una red neuronal artificial y otro puede encargarse de interactuar con el usuario para evaluar un nuevo caso, son dos algoritmos diferentes dentro de un mismo programa. Yo creo que debemos hablar de ‘programas’ y no de ‘algoritmos’.

En este machine learning ‘simple’ y ‘básico’ los programas sólo buscan relaciones estadísticas entre los datos numéricos que usamos para entrenarlos (con ruido, incompletos, inciertos…) sin tener en cuenta ningún aspecto cognitivo ‘serio’ en el proceso, por lo que las expectativas en sus resultados son tan pobres cómo sus resultados habitualmente corroboran.

‘Un tema crucial que muy bien destacas es el efecto ‘caja negra’ de la mayoría de las técnicas de ML, intrínseco a su propia naturaleza de mera búsqueda de relaciones estadísticas básicas. Redes Neuronales, Random Forests, casi todas las metaheurísticas, algoritmos genéticos… son todos cajas negras por su propia definición y por su propia naturaleza (al no manejar conocimiento no pueden explicar porqué llegan a una determinada conclusión). Por ejemplo, una matriz grande de números entre [0, 1] no puede explicar porqué ese programa de Deep Learning (que lo único que hace es ajustar los pesos de dicha matriz mediante un grandísimo número de iteraciones de la misma operación básica), es capaz de distinguir fotografías de perritos de fotografías de gatitos, o porqué esta es la sentencia adecuada a este delito, o porqué hay sesgos en los resultados…

…Este tema de la ‘interpretabilidad’ de la IA es un tema crucial hoy en día en todo lo que tiene que ver con la IA. Por eso se introduce el nuevo concepto de ‘cajas grises’, del que os animo a que busquéis información…

«Para cualquiera que conozca mínimamente Twitter (…) la hipótesis de un comportamiento intencionado es ya no improbable, sino directamente absurda. Además, los algoritmos carecen de ideología (…)».

¿Que carecen de qué? Ah, ni de broma, pero ni de broma. Y si uno sigue creyendo, a estas alturas de la película, que incluso 2 + 2 = 4 también carece de ideología, pues claro, así les luce el pelo a los de Twitter… (Y a nosotros cuando creemos en las lágrimas de cocodrilo de los ejecutivos agresivos dueños de las redes sociales…, -cocodrilo racista, por supuesto, o machista, o supremacista, o…)

https://www.timeout.es/barcelona/es/noticias/la-sorprendente-campanya-que-llenara-instagram-de-pezones-de-mujer-062718

https://diario16.com/la-campana-del-pezon-de-bibiana-fernandez-evidencia-el-machismo-de-las-redes-sociales/

https://www.elperiodico.com/es/extra/20190627/instagram-pezones-critica-instagram-censura-melo-moreno-dulceida-7524483

Nada, simple ejemplos, los hay a puñados cada día…

Saludos.

Ay, Señor….