Un interesantísimo articulo en The New York Times, «Biased algorithms are easier to fix than biased people«, invita a reflexionar sobre el concepto del sesgo y la discriminación, muy de moda al hilo de noticias de algoritmos que contenían sesgos y provocaban desde problemas a la hora de contratar mujeres, a discriminación en apps de citas, determinar el riesgo en perfiles criminales, en el cuidado de la salud o en la administración de publicidad.

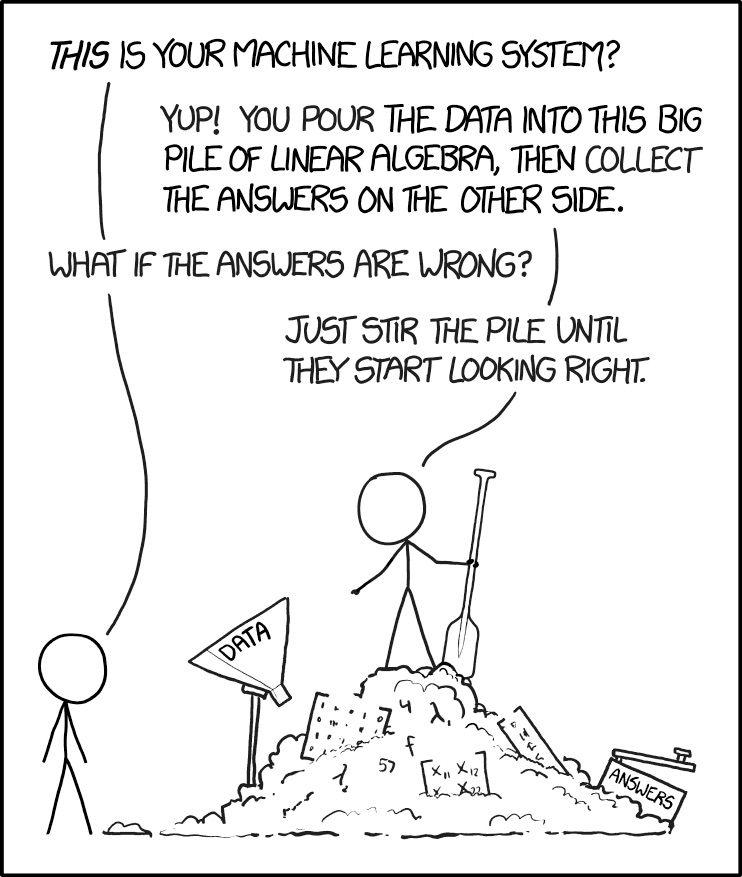

Un algoritmo, por el hecho de serlo, no asegura la inexistencia de sesgos. De hecho, un algoritmo obtiene sesgos de los datos que utilizamos para entrenarlo, que pueden perfectamente contener sesgos implícitos de diversos tipos, fácilmente apreciables o no por una supervisión humana. Los sesgos en los datos que alimentan los algoritmos son, sin embargo, relativamente fáciles de comprobar mediante técnicas matemáticas adecuadas, que de hecho son muy similares a las que se han utilizado toda la vida para determinar o corregir el sesgo muestral, y pueden por tanto corregirse de manera relativamente sencilla.

Los sesgos en las personas también existen, de hecho en algunos temas son tristemente muy habituales: no es difícil encontrar personas que introducen elementos de discriminación de diversos tipos en su toma de decisiones. La diferencia con los sesgos de los algoritmos de machine learning es que, aunque su existencia puede igualmente determinarse mediante los correspondientes análisis matemáticos, su corrección posterior es, sin embargo, muchísimo más difícil, en ocasiones puede, de hecho, ser imposible, y no solucionarse más que sustituyendo a la persona o mediante cambios en la cadena de genera la decisión.

Cuando critiquemos a un algoritmo por contener sesgos debido a los datos con los que lo hemos entrenado, por tanto, deberíamos tener en la cabeza que si utilizamos ese algoritmo para sustituir procesos de toma de decisiones llevados a cabo por humanos, como veremos cada vez más a menudo, estaremos dando lugar a una sustitución que se sitúa al mismo nivel en cuanto a la posibilidad de detectar esos sesgos, pero muy por encima en lo relacionado con la capacidad que tendremos para corregirlos. Entender la existencia de sesgos en un proceso de toma de decisiones algorítmico como algún tipo de enmienda a la totalidad es, simplemente, una prueba de no saber matemáticas. Los algoritmos pueden tener sesgos, sí, pero cambian, se reeducan y corrigen esos sesgos de forma mucho más sencilla y más eficiente que las personas. Con todo lo que ello conlleva. Plantéate cuántas decisiones se toman en procesos en tu compañía en función de criterios de personas que pueden tener sesgos, y hasta qué punto podrían mejorar esos procesos si esos sesgos inherentes a las personas pudiesen ser corregidos simplemente ajustando algunos parámetros matemáticos o incorporando mecanismos que corrigen el sesgo muestral, en lugar de depender de algo tan complicado como las percepciones, la experiencia o la supuesta intuición de una persona.

En el futuro, todo algoritmo contendrá analíticas que evalúen los posibles sesgos en los que incurre, generarán mecanismos de aviso cuando esos sesgos tengan lugar, y posibilitarán su posterior ajuste y corrección. Si fuese tan sencillo hacer lo mismo con el juicio de las personas, las sociedades y organizaciones humanas seguramente ganarían mucho.

This post is also available in English on my Medium page, «Which is easier to correct, an algorithm’s bias or a human’s?«

En cierto modo el algoritmo funciona muy parecido al típico jefe (de lo que sea), que por ser extremadamente justo (intentarlo a fondo), no tiene contento a ningún elemento de su personal subalterno.

«Por haches o por bes», siempre encontrará un subalterno, motivos para estar descontento. Y normalmente suele pasar por un desconocimiento más o menos profundo de las circunstancias en que se deasrroilló la trama «denuncia de algo/toma de decisión». Y esa fata de información la sufre el subalterno «que va con buena intención» y el jefe que «quiere actuar con justicia».

Y el problema de no haber «boss perfecto», es que un ser humano tiene una capacidad limitada para almacenar información. Mientras que un algoritmo no la tiene. Su limitación no está en el, si no que reside en el ser humano encargado de alimentarlo con datos.

Lo que si no cambia, mientras los humanos anden por medio, es que el big data no puede vencer a la adicción al poder que domina al ser humano (que la tiene). Así que siempre (?) existira´ la mediación manipuladora del humano. Por lo menos hasta alcanzar una versión mejorada del homo sapiens, en el que la naturaleza consiga mutar determinadas tendencias, no genéticas pero sí producto de una domesticación intensiva. Todas esas características, circunstancias decía el otro, de las que tanto alardea gentuza como el Trump o el Johnson. Esas mismas que tanto nos impiden ligar esta parte de la historia actual, con lo más potable de la historia clásica o renacentista.

No puedo estar más de acuerdo contigo…

El primer problema, es que la palabra “algoritmo”, hoy en día se liga intrínseca al Machine Learning, a la inteligencia artificial, al… señores, calcular 2 + 2, ya implica “algoritmo”… que la palabra viene de lejos (informáticamente, también).

Por supuesto, cualquier algoritmo se nutre de datos, y nos guste o no, los datos vienen de la población general. Si solo introducimos nuestros datos, bien sesgados, con aquello que nos interesa (digamos, lo “políticamente correcto”), el algoritmo, seguirá funcionando… solo que arrojara como resultado, aquello que nosotros queramos… ahí se pierde la gracia.

El “sesgo”, lo provocamos nosotros. Y lo siento Enrique, no hay matemática posible que los delimite.

2+2 no te va a decir, cuanto comunista, católico, panadero o mecánico hay en un grupo de análisis. Solo datos de entrada.

Dices: “cambios en la cadena de genera la decisión”, osea, cambiar el algoritmo al gusto, porque el dato es el dato… o cambiamos el dato del input para que el output sea el deseado (manipulación) o cambiamos el algoritmo para que nos devuelva lo deseado (manipulación).

A finales de los 80, me aficione a programar en Prolog. No iba a servirme de aquellas (y tampoco hoy), pero la toma de decisiones de cualquier motor de inferencia que te sacaras de la manga, era tan manipulable como el resultado que esperaras obtener (creo que ahí reside algo de maldad humana)…

Un «algoritmo», capaz de aprender a corregirse a si mismo… Eso seria la solucion? Tampoco lo creo. El mismo provocaria su propio sesgo. Siempre habria «algo» de la mentalidad del programador alli en lo mas profundo… sesgando…

A Abu Abdallah Muḥammad ibn Mūsā al-Jwārizmī le gusta tu comentario

En lineas generales muy de acuerdo.

Pretendemos que los algoritmos dan resultados políticamente correctos, por ejemplo que den a las mujeres la misma capacidad de crédito que a los hombres,

Muy bien, es lo políticamente correcto,…. pero o hacemos un truco, que, es programar que si he dado mas del 50% de créditos a hombres, ahora toca darlo a las mujeres y viceversa y paso de los datos que surtan al sistema, o saldrá lo que salga, probablemente que da mas créditos a unos que a otros.

Bien porque así es la estadística, y si tiras 100 veces la moneda, rara vez dará 50 caras y 50 cruces. Bien por que los datos con que surtes el sistema, están sesgados de forma que tu no detectas, Por ejemplo tiene en cuenta la edad y en una pareja, la mujer suele ser mas joven que el hombre, (excepto la de Macron)

Por ejemplo en la medicion de la DGT se parte que un movil que esta por la noche fijo en un sitio es que es la vivienda del propietario, pero mucha gente tienen un smartphone de trabjo que dejaen la oficina para que no le den la lata en su tiempo libre se queden en un cajón del despacho y no acompañen a su propietario, salvo para trabajar., no se lo lleva en vacaciones.

Igualmente van a medir unos dias de verano para ver cuando se viaja, si uno de esos días, hay mucha lluvia se viajara menos de noche, pero en cambio los camiones viajaran igual, la proporción de camiones vendrá falseada en los resultados, pero si el día es muy caluroso, mucha gente viajará fuera de las horas de mas sol y se falseará el resultado en sentido contrario..

Mi experiencia personal en este tipo de problemas, es que los datos no se falsean, lo que son falsas son las deducciones que apoyan en los datos que tienes

Alguien puede viajar desde su residencia habitual porque se ha puesto muy enfermo su padre, pero si lo hace en julio, tu «infieres» que se va de veraneo.

Estoy de acuerdo excepto en que no es suficiente poder comprobar los sesgos pues hay muchos sesgos que son implícitos y entonces no sabemos que tenemos que comprobarlos. De hecho, encontrar todos los sesgos es difícil pues hay algunos que no son obvios. Uno de mis artículos sobre este tema con Karma Peiró: ¿Es posible acabar con los sesgos de los algoritmos?.