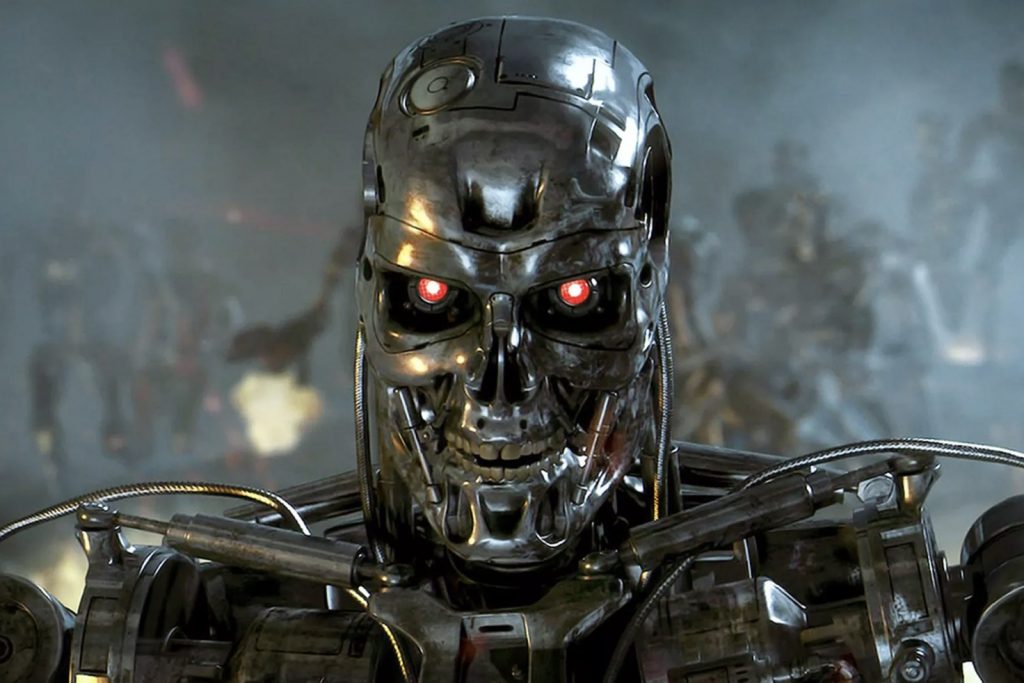

Desde hace tiempo, y de manera ya prácticamente cansina en toda la prensa generalista, las noticias que tienen que ver con el desarrollo del machine learning o la inteligencia artificial tienden a ilustrarse con la imagen de un Terminator o de algún otro tipo de robot asesino de película de los años ’80. La llamada «hipótesis Terminator» o «hipótesis Skynet» ha sido una constante en el pensamiento contemporáneo sobre el desarrollo de la inteligencia artificial, popularizada incluso por personajes de gran prestigio e influencia como Stephen Hawking o Elon Musk que hablan de ella como una supuesta amenaza existencial para la humanidad.

Y sin embargo, la realidad es que, a medida que vamos avanzando en ese ámbito, las cosas no solo no son así, sino que prueban precisamente lo contrario. Los planteamientos e inversiones de las compañías en este tipo de temas tienen que ver con automatización avanzada, con analítica, con control de procesos y con infinitas cosas más, pero en ningún caso con el desarrollo de supuestas inteligencias de propósito amplio o de máquinas capaces de adquirir conciencia. Incluso cuando hablamos de preferir que nos gobierne una inteligencia artificial frente a un político tradicional, hablamos de procesos controlados, no de una supuesta toma de decisiones autónoma o capaz de desencadenar una guerra.

El machine learning puede hacer cosas cada vez más interesantes y que sean buenas o malas dependerá lógicamente del propósito que tenga quien esté tras su desarrollo, pero lo que sí está cada vez más claro y resulta más central es la idea de multidisciplinaridad que debe mantenerse en la disciplina, combinando elementos puramente tecnológicos con otros de otras disciplinas más humanistas.

Así, a la iniciativa de centro multidisciplinar sobre AI presentada por el MIT hace cinco meses, se une ahora otra con un enfoque similar en la costa opuesta, en Stanford, que viene a reafirmar el interés por planteamientos holísticos y plurales para una disciplina tan intrínsecamente transformacional. Cada día está más claro y es más patente que los equipos dedicados a la ciencia de datos no precisan únicamente de científicos de datos como tales, sino de personas de extracción y vocación múltiple, generalista y humanista, capaces de proporcionar un enfoque amplio que considere todos los aspectos afectados por cada desarrollo. La hipótesis de un supuesto error cometido por una optimización centrada en un aspecto exclusivamente técnico o matemático pierde cada vez más fuelle: los desarrollos que hagamos estarán, en su gran mayoría validados con este tipo de enfoques humanistas. Y aunque se cometiesen errores, que sin duda se cometerán, hablamos de otro tipo de consecuencias.

Del mismo modo que muchos procesos de transformación digital fallan por creer erróneamente que se trata de una cuestión de tecnología en lugar de una cuestión de cultura y de personas, muchos desarrollos de machine learning e inteligencia artificial fracasarán por no haber tenido en cuenta aspectos mucho más amplios que su desarrollo algorítmico o la ciencia de datos implicada en ellos. Entender esto resultará fundamental para los muchos profesionales de amplio espectro que se integrarán en esos equipos multidisciplinares, que no solo tendrán que tener ideas y conocimientos claros sobre inteligencia artificial, sino además, plantear escenarios razonables, creíbles, serias y que no partan de hipótesis rocambolescas como que «la máquina va a adquirir conciencia de sí misma y va a querer matarnos a todos».

Este área no solo está recibiendo muchísima inversión y atención, sino que, además, va a recibir mucha más en los próximos años. Hablamos, sin duda, de una de las tecnologías que tiene más capacidad de impactar sobre nuestras vidas en una enorme cantidad de aspectos, y no precisamente en el de rebelarse y destruir a la humanidad. Un enorme poder transformacional… pero no en ese absurdo sentido. Cuanto antes empecemos a hacer planteamientos e hipótesis creíbles por parte de equipos multidisciplinares y releguemos la «hipótesis Terminator» al terreno de la ciencia-ficción del que nunca debió salir, mejor para todos.

This article was also published in English on Forbes, “Please, can we park the Terminator hypothesis once and for all?«

Resulta cansino, efectivamente. Solo decir que prefiero a una máquina programada inicialmente (autoprogramable después) por un buen programador (global), que a la mayoría de políticos que habitualmente muestran su deficiente uso mental en los medios de comunicación estes últimos meses. Españoles (catalanes incluídos) y del resto del mundo.

A la hora de la verdad, ¿que diferencia puede haber entre un Skynet y un trío Bolsonaro-Trump-Putin? Y no meto al Ji chino por ser algo más clandestino (desconocido).

Por otra parte, pienso que resultaría mucho más aprovechable, para el avance científico, el cerebro de Skynet.

Muy buen post Enrique, ya que cuando algo se pone de moda, los medios generalistas tienden más a amarillismo sobre estos temas. De todas maneras, la búsqueda del «Santo Grial» de la AGI (Artificial General Intelligence) siempre seguirá activa.

Creo que faltan visiones como la tuya o de otros expertos como Andrés Pedreño para que en España se defina una estrategia clara en Inteligencia Artificial, ya que la que se ha publicado recientemente parece ser demasiado vinculada al mundo científico y debería completarse con la visión realista que tú tienes.

Estoy totalmente de acuerdo en que los Data Science tiene que tener más aptitudes humanistas y no solo matemáticas, de hecho es algo que va con el puesto, un Data Science tiene que extraer valor de los datos y solo las matemáticas no son suficientes.

Por otro lado, cuando hablamos de una IA generalista, creo que los avances de los últimos años en cuanto a la comprensión de la mente humana, darán más de un susto. Ray Kurzweil en «Cómo crear una mente» o Nick Bostrom en «Superinteligencia» aportan mucha información en este sentido.

¡Qué bonito articulo! Gracias :-)

Justo estoy planteado escenarios de desarrollo competenciales, enfocados a Latinoamerica, para contribuir al desarrollo educativo. Estoy queroendo crear un prototipo, porque es muy dificil hacerlo entender, si no es tocándolo. Es apasionante contraponer el desarrollo de la autonomia del aprendizaje conjugado con un algoritimo y/o modelo de machine learning. Por ejemplo, cómo diferencio un escenario de recomendaciones en el aprendizaje con un algoritmo de aprendizaje basado en recomendaciones. O ¿Puedo aprender de mis decisiones y perfeccionar mi rendimiento. He de revisar el documento de open AI publicado en twitter, sobre consideraciones éticas del desarrollo de proyectos. Casi me obsesiona hacerlo bien eticamente hablando, pero no por enseñar a un algoritmo, sino para ayudar a que algoritmo, genere desarrollo. El contexto social aqui, en Bolivia, es «especial». No cualquier diseño sirve. No hablamos de automatizar el aprendizaje, sino más bien de hacerlo más eficiente. Escuchaba a Mario Alonso, el doctor neurocirujano, que me parece muy sensato, y transmite una responsabilidad por la motivacion y la conexion con uno mismo para agilizar los procesos de aprendizaje. Me fascina. Es metodico y sencillo. Hace que reflexione mucho. Y veo como trasladarlo al modelo. Releeré tus articulos. Gracias Enrique!!.

La insatisfacción de la gente con quienes nos desgobiernan es quizás la señal más importante de nuestra propia humanidad, en toda la historia se ha ensayado toda clase de Estados (reinos, imperios, feudalismo, democracia) para ejercer poder político y ejecutivo en cualquier sociedad, pero sin embargo siempre fracasa. El poder político, pese ser creación humana es inhumano, sólo es ocupado por autistas que tratan a la gente como idiotas, casi llegando al fanatismo de adorarlos como dioses como es el caso de varios presidentes latinoamericanos.

En este caso preferir que un ente neutral, como una IA se encargue de la organización política e instituciones burocráticas es inevitable. En la saga de libros La Cultura, los humanos entregan voluntariamente a inteligencias artificiales de otro planeta, porque nosotros mismos somos «la amenaza existencial».

Que una máquina llegue a desarrollar lo que nosotros denominamos consciencia o incluso sentimientos es algo inevitable, al fin y al cabo nuestro cerebro biológico ha seguido el mismo camino evolutivo y salvo aquellos que creen en la intervención de un ser divino, hemos de estar de acuerdo que nuestro cerebro no deja de ser una máquina un poco mas compleja de lo que por el momento son las computadoras.

En cuanto a que se convierta en una máquina asesina, eso ya tiene un antecedente, ¿no estamos quizá nosotros destruyendo a todo lo que nos precedió en la evolución?.

Es que NO ES UN CEREBRO, ni humano ni de nada que se le parezca, y lo que es más importante, NO PRETENDE SERLO. No hay investigación que vaya en la dirección de tratar de crear un cerebro multidisciplinar, la inteligencia artificial trata de automatizar de manera ambiciosa y sofisticada una tarea concreta, no de obtener una máquina que piense. Una cosa es una máquina que aprenda, y otra muy distinta una máquina que piense. La consciencia y la capacidad de reaccionar no se va a desarrollar mediante la generación actual de tecnología, porque no cabe esperar que a base de acumular contextos, una máquina llegue a convertirse en maestra de todos ellos. Mientras sigamos confundiendo una máquina con un algoritmo de machine learning con un cerebro, seguiremos teniendo miedos absurdos y generados por la ignorancia.

¿No es pensar la consecuencia lógica de aprender?.

Si una máquina biológica o no, es capaz de almacenar conocimientos, relacionarlos y a través de procesos lógicos llegar a conclusiones, mas allá de los conocimiento previos ¿esta pensando?.

No entiendo el por qué de esa egocéntrica presunción de que un cerebro, que como decía antes no es mas que una máquina biologica, no puede ser superado por una máquina basada en otros principios físicos.

En cuanto al miedo, ya tenemos bastantes miedos a lo que elucubran los cerebros humanos, no parece que la amenaza que presentan esos nuevos entes vaya a ser mucho peor.

Cabe la posibilidad que seamos desplazados por seres superiores, que hayamos creado nosotros mismos, en ese nuevo orden ocupariamos la posición que ahora ocupan los simios, no parece que los simios lo están pasando tan mal.

No. No funcionan igual. Estás haciendo una analogía incorrecta e imposible. Estás comparando especies con máquinas. Tu error está en pensar que una máquina puede llegar a ser algo capaz de operar como un organismo, y no es así, o al menos, no con la tecnología que está desarrollada y en planes de desarrollo en un futuro razonable.

Te voy a dar un ejemplo (hipotético) de porqué te puede asustar la IA.

Puede ocurrir que un día alguien te ponga un tema de música electrónica y te diga que es una cara B o una antigua maqueta de Vangelis o the Prodigy(por poner un ejemplo de algún artista con cuyo nombre quizá sintieras más interés en escucharlo).

Lo escuchas y te ha gustado.

Después te dicen que era mentira, que esa música la ha generado una IA que ni siquiera ha mezclado material de esos artistas. Intentarían burlarse de ti.

Y cómo te ha gustado y a otros muchos también, muchos de los que la oyeron y tienen la grabación la escucharían a escondidas discretamente.

La tecnología que permitirá que una máquina sea experta en muchos contextos y llegue a operar como un organismo único está lejos de ser una realidad. Pero lo será, tarde o temprano. Digamos 100 ó 200 años. O 500.

Y cuando eso ocurra, cualquier escenario será posible, incluido el escenario «Skynet», porque la inteligencia de nuestra especie seguirá estancada dentro de su límite natural (el cráneo humano y su capacidad, velocidad y eficiencia para crear y compartir información). Las máquinas no tendrán esas limitaciones.

Ya, pero la tecnología no solo no es estática sino que progresa a ritmo geométrico.

Lo que hoy no existe ni siquiera en proyecto, nadie puede afirrmar que no sea posible, excepto cuando vaya contra las leyes físicas.

Recurramos a un clasico.

Vaya! Te estás conviritendo a los no-brainless. Congratulations!